Python爬虫入门教程:爬取boss直聘招聘数据并做可视化展示

本文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,如有问题请及时联系我们以作处理。

基本开发环境

Python 3.8

Pycharm

相关模块的使用

from selenium import webdriver import csv

安装Python并添加到环境变量,pip安装需要的相关模块即可。

如图所示,通过 Python 来控制 Selenium,然后让 Selenium 控制浏览器,操纵浏览器,这样就实现了使用Python 间接的操控浏览器。

兄弟们学习python,有时候不知道怎么学,从哪里开始学。掌握了基本的一些语法或者做了两个案例后,不知道下一步怎么走,不知道如何去学习更加高深的知识。

那么对于这些大兄弟们,我准备了大量的免费视频教程,PDF电子书籍,以及视频源的源代码!

还会有大佬解答!

都在这个群里了【点我进Python学习交流裙】

欢迎加入,一起讨论 一起学习!

Selenium具体怎么就能操纵浏览器呢?这要归功于 浏览器驱动 ,Selenium可以通过API接口实现和浏览器驱动的交互,进而实现和浏览器的交互。

所以要配置浏览器驱动。

本教材使用版本:

火狐驱动:geckodriver 0.23.0 ( 2018-10-04)

火狐驱动下载地址: http://npm.taobao.org/mirrors/geckodriver/

谷歌驱动:ChromeDriver 71.0.3578.33

谷歌驱动下载地址:

https://npm.taobao.org/mirrors/chromedriver/

http://chromedriver.storage.googleapis.com/index.html

配置浏览器驱动:

将下载好的浏览器驱动解压,将解压出的 exe 文件放到Python的安装目录下,也就是和python.exe同目录即可。

代码实现

from selenium import webdriver import csv f = open('data.csv', mode='a', encoding='utf-8', newline='') csv_writer = csv.DictWriter(f, fieldnames=[ '标题', '地区', '薪资', '经验', '公司名', '公司领域', '福利', '详情页', ]) csv_writer.writeheader() driver = webdriver.Chrome() driver.get('https://www.zhipin.com/job_detail/?query=python&city=100010000&industry=&position=') driver.implicitly_wait(10) def get_job_info(): lis = driver.find_elements_by_css_selector('.job-list li') for li in lis: # 标题 title = li.find_element_by_css_selector('.job-name a').get_attribute('title') # 地区 area = li.find_element_by_css_selector('.job-area').text # 薪资 money = li.find_element_by_css_selector('.job-limit .red').text # 经验 limit = li.find_element_by_css_selector('.job-limit p').text # exp = limit[0].text company_name = li.find_element_by_css_selector('.company-text .name a').text company_type = li.find_element_by_css_selector('.company-text p a').text desc = li.find_element_by_css_selector('.info-append .info-desc').text href = 'https://www.zhipin.com/' + li.find_element_by_css_selector('.job-name a').get_attribute('href') print(title, area, money, limit, company_name, company_type, desc, sep='|') dit = { '标题': title, '地区': area, '薪资': money, '经验': limit, '公司名': company_name, '公司领域': company_type, '福利': desc, '详情页': href, } csv_writer.writerow(dit)

数据可视化

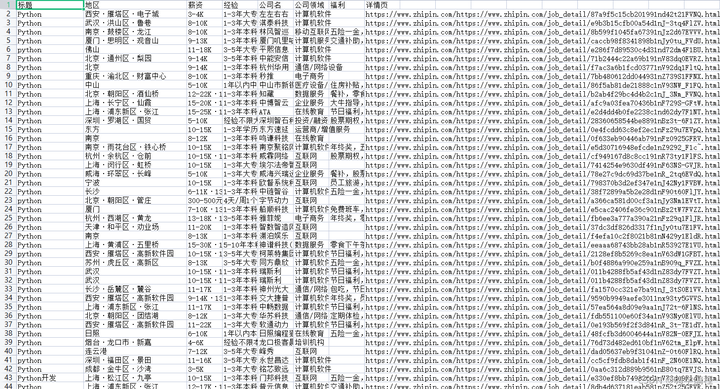

只是获取前10页的数据内容,总计是300条数据

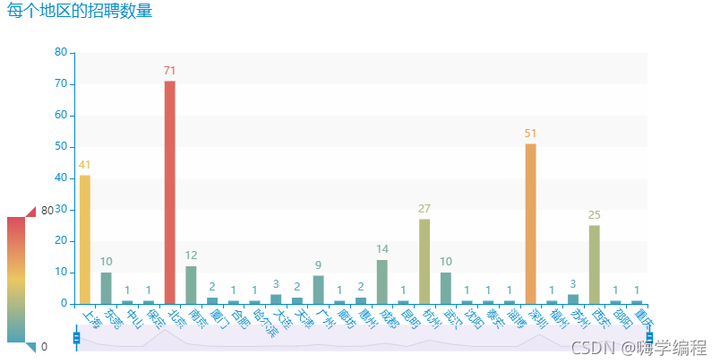

每个地区的招聘数量

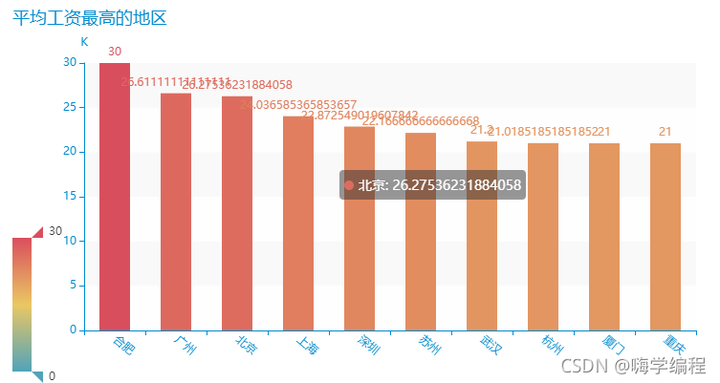

平均工资最高的地区

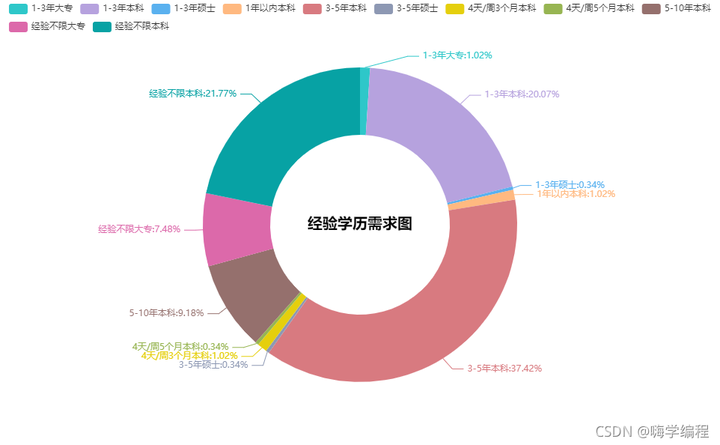

经验学历需求图

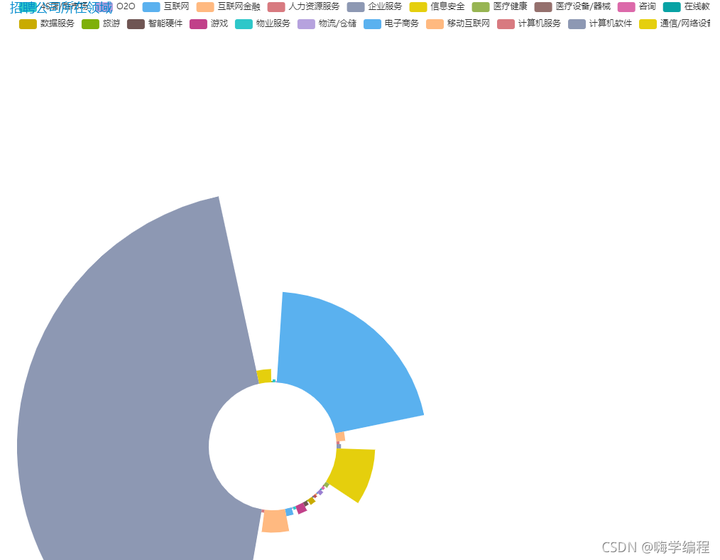

招聘公司所在领域

浙公网安备 33010602011771号

浙公网安备 33010602011771号