通过Python读取sqlserver数据写成json文件的总结

最近在做将sqlserver的数据迁移到redshift上面,然后再做的过程当中出现了很多问题。(通过sqlserver 读取数据,然后写成json文件然后长传到S3上面,然后通过S3copy的形式将数据写入到redshift上面)

第一次通过csv的形式然后通过s3copy的形式将数据长传,里面出险了一些特殊的字符(比如\n \t \r)就很坑爹,这就是csv不好的地方。

具体看下面这篇博客(https://blog.csdn.net/qq_39188891/article/details/90480907)

遇到的问题1:

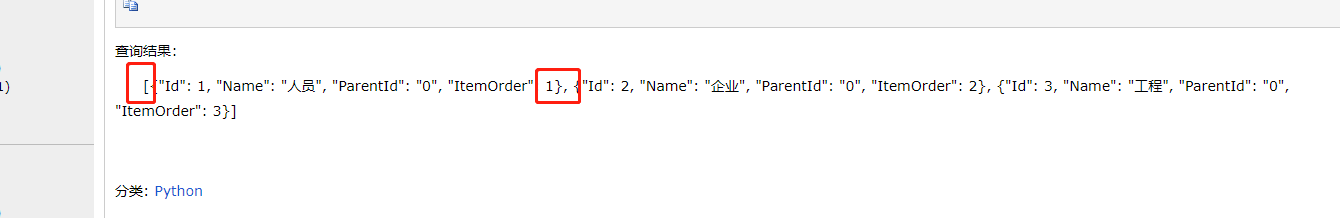

使用pands读取sql,然后将数据转成json之后,发现redshift不能加载直接转成的json。

转成的json格式,出险了上面的两遍带有[]的标识而且中间有逗号分隔,这样的json数据不能被redshift识别。要想识别还得重新对数据进行清洗。

问题2:

通过下面的这种方式读取的数据,然后将每一行的数据转成一个dataframe的形式再写成json的形式,然后把文件打开然后再将数据写入到文件当中。

但是这种的数据在逐条写入的时候,速度就特别的慢。40万的数据,写了一个小时没写完。

connect = pymssql.connect(host=sqlserver_host, user=sqlserver_username,

password=sqlserver_pwd, database=sqlserver_dbname, port=sqlserver_port) # 建立连接

cursor = connect.cursor()

if connect:

print("sqlserver连接成功!")

sql = '''select * from %s a''' % (sqlserver_script)

print(sql)

cursor.execute(sql) # 执行sql语句

columnDes = cursor.description # 获取连接对象的描述信息

columnNames = [columnDes[i][0] for i in range(len(columnDes))]

rs = cursor.fetchall()

f = open('/data/etl_log/sqlserver_data/{name}.json'.format(name=sqlserver_script), 'a')

count=0

for i in rs:

df = pd.DataFrame([list(i)], columns=columnNames)

#df = df.applymap(lambda x: str(x).replace('\r', '').replace('\n', '').replace('\t', ''))

#df = df.applymap(replace_func,axis=0)

ss = df.to_json(orient='records').replace('[', '').replace(']', '')

f.write(ss+'\n')

print(count)

count+=1

f.close()

读取速度慢的原因,一条数据在转成df的时候产生了很多对象。这个导致内存不能释放,所以速度很慢

最终的解决方案是通过map的形式将数据转成一个list,然后做成字典的形式,然后转化为json,然后写入到文件当中这样的速度还可以,40万的数据差不多10分钟不到。

for i in rs: list_ = list(map(lambda x: str(x).replace('\t', '').replace('\n', '').replace('\r', ''), i)) ss = json.dumps(dict(zip(columnNames, list_))) f.write(ss+'\n') print(count) count+=1

至此问题得到解决。