《动手学深度学习》task03课后习题

Task03:过拟合、欠拟合及其解决方案;梯度消失、梯度爆炸;循环神经网络进阶

task03笔记见:https://www.cnblogs.com/guohaoblog/p/12324894.html

过拟合、欠拟合及其解决方案

1、关于验证数据集的描述错误的是:

A、测试数据集可以用来调整模型参数

B、验证数据集可以用来调整模型参数

C、在数据不够多的时候,k折交叉验证是一种常用的验证方法

D、k折交叉验证将数据分为k份,每次选择一份用于验证模型,其余的用于训练模型

答:选择A

测试数据集不可以用来调整模型参数,如果使用测试数据集调整模型参数,可能在测试数据集上发生一定程度的过拟合,此时将不能用测试误差来近似泛化误差。

2、关于过拟合、欠拟合概念的描述错误的是:

A、过拟合是指训练误差很低,泛化误差相对于训练误差要高很多

B、过拟合和欠拟合可以同时发生

C、欠拟合是指训练误差和泛化误差都无法到达一个较低的水平

D、过拟合和欠拟合都是在训练中容易遇到的经典问题

答:选择B

过拟合是指训练误差达到一个较低的水平,而泛化误差依然较大。

欠拟合是指训练误差和泛化误差都不能达到一个较低的水平。

发生欠拟合的时候在训练集上训练误差不能达到一个比较低的水平,所以过拟合和欠拟合不可能同时发生。

3、关于模型复杂度和数据集大小造成欠拟合和过拟合的描述错误的是:

A、模型复杂度低容易导致欠拟合

B、训练数据集小容易导致过拟合

C、解决欠拟合可以考虑增加模型的复杂度

D、缓解过拟合只能增加训练数据集的大小

答:选择D

过拟合还可以使用权重衰减和丢弃法来缓解,即使在一个比较小的数据集上使用了权重衰减和丢弃法之后也能够达到一个比较好的效果。

4、关于权重衰减和丢弃法的描述错误的是:

A、L2范数正则化在损失函数的基础上添加了L2范数惩罚项

B、L2范数惩罚项通过惩罚绝对值较大的参数的方法来应对欠拟合的

C、丢弃法通过随机丢弃层间元素,使模型不依赖于某一个元素来应对过拟合的

D、L2范数正则化是权重衰减的一种方式

答:选择B

L2范数正则化也就是权重衰减是用来应对过拟合的。

有时可以同时结合L1和L2范数,加入到损失函数中,以应对过拟合问题

梯度消失、梯度爆炸

1、关于导致梯度消失和梯度爆炸的描述错误的是:

A、梯度消失会导致模型训练困难,对参数的优化步长过小,收效甚微,模型收敛十分缓慢

B、梯度爆炸会导致模型训练困难,对参数的优化步长过大,难以收敛

C、激活函数使用sigmoid或者tanh可以缓解梯度消失

D、在训练模型时,我们应该采取适当的措施防止梯度消失和梯度爆炸的现象

答:选择C

在深层网络中尽量避免选择sigmoid和tanh激活函数,原因是这两个激活函数会把元素转换到[0, 1]和[-1, 1]之间,会加剧梯度消失的现象。ReLU激活函数目前在深度神经网络中用的最多。

2、一个在冬季部署的物品推荐系统在夏季的物品推荐列表中出现了圣诞礼物,我们可以推断该系统没有考虑到:

A、协变量偏移

B、标签偏移

C、概念偏移

D、没有问题

答:选择A

可以理解为在夏季的物品推荐系统与冬季相比,时间或者说季节发生了变化,导致了夏季推荐圣诞礼物的不合理的现象,这个现象是由于协变量时间发生了变化造成的。

3、下列关于模型训练实战步骤排序正确的是:

- 模型验证和模型调整(调参)

- 获取数据集

- 模型设计

- 模型预测以及提交

- 数据预处理

A、12345

B、23145

C、25143

D、25314

答:选择D

正确的顺序应该是:

- 获取数据集

- 数据预处理

- 模型设计

- 模型验证和模型调整(调参)

- 模型预测及提交

所以最终选择25314。

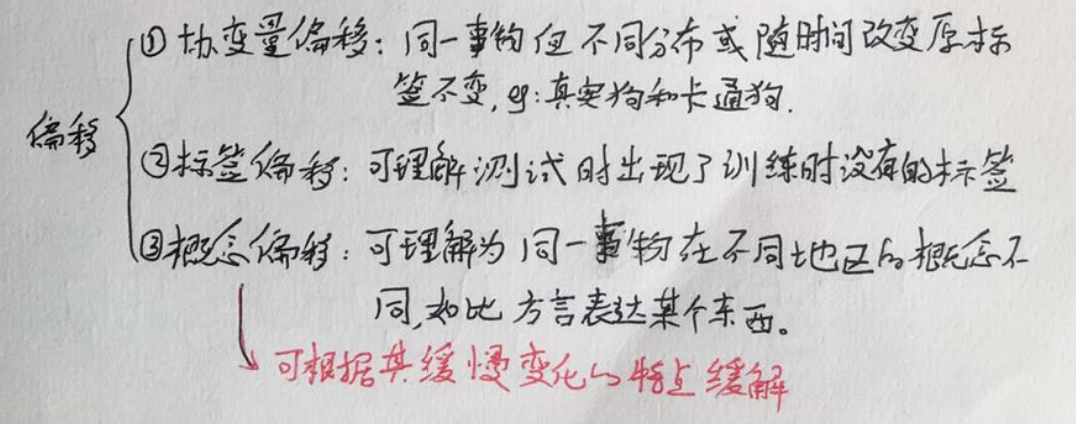

4、关于协变量偏移、标签偏移、概念偏移的描述中错误的是:

A、协变量偏移和标签偏移可能同时发生

B、标签偏移可以简单理解为测试时出现了训练时没有的标签

C、确保训练集和测试集中的数据取自同一个数据集,即使训练数据和测试数据数据量很少也可以防止协变量偏移和标签偏移

D、概念偏移可以根据其缓慢变化的特点缓解

答:选择C

如果数据量足够的情况下,确保训练数据集和测试集中的数据取自同一个数据集,可以防止协变量偏移和标签偏移是正确的。如果数据量很少,少到测试集中存在训练集中未包含的标签,就会发生标签偏移。

循环神经网络进阶

1、关于循环神经网络描述错误的是:

A、在同一个批量中,处理不同语句用到的模型参数Wh和bh是一样的

B、循环神经网络处理一个长度为T的输入序列,需要维护T组模型参数

C、各个时间步的隐藏状态Ht不能并行计算

D、可以认为第t个时间步的隐藏状态Ht包含截止到第t个时间步的序列的历史信息

答:选择B

A项:批量训练的过程中,参数是以批为单位更新的,每个批次内模型的参数都是一样的。

B项:循环神经网络通过不断循环使用同样一组参数来应对不同长度的序列,故网络的参数数量与输入序列长度无关。

C项:隐状态Ht的值依赖于H1, ..., Ht−1,故不能并行计算。

D项:正确

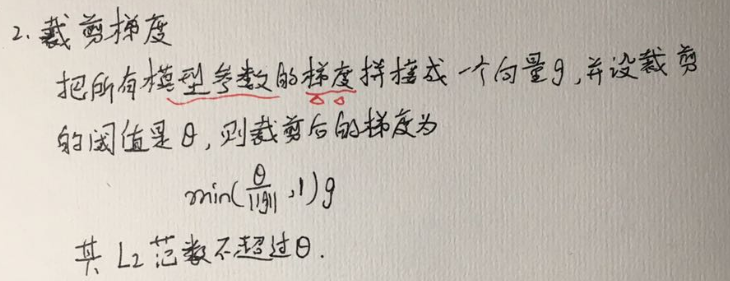

2、关于梯度裁剪描述错误的是:

A、梯度裁剪之后的梯度小于或者等于原梯度

B、梯度裁剪是应对梯度爆炸的一种方法

C、裁剪之后的梯度L2范数小于阈值Θ

D、梯度裁剪也是应对梯度消失的一种方法

答:选择D

梯度裁剪只能应对梯度爆炸

3、关于困惑度的描述错误的是:

A、困惑度用来评价语言模型的好坏

B、困惑度越低语言模型越好

C、有效模型的困惑度应该大于类别个数

答:选择C

一个随机分类模型(基线模型)的困惑度等于分类问题的类别个数,有效模型的困惑度应小于类别个数。

4、关于采样方法和隐藏状态初始化的描述错误的是:

A、采用的采样方法不同会导致隐藏状态初始化方式发生变化

B、采用相邻采样仅在每个训练周期开始的时候初始化隐藏状态是因为相邻的两个批量在原始数据上是连续的

C、采用随机采样需要在每个小批量更新前初始化隐藏状态是因为每个样本包含完整的时间序列信息

答:选择C

随机采样中每个样本只包含局部的时间序列信息,因为样本不完整所以每个批量需要重新初始化隐藏状态。