动手实现深度学习(14):卷积神经网络

11.1 卷积神经网络的实现

传送门: https://www.cnblogs.com/greentomlee/p/12314064.html

github: Leezhen2014: https://github.com/Leezhen2014/python_deep_learning

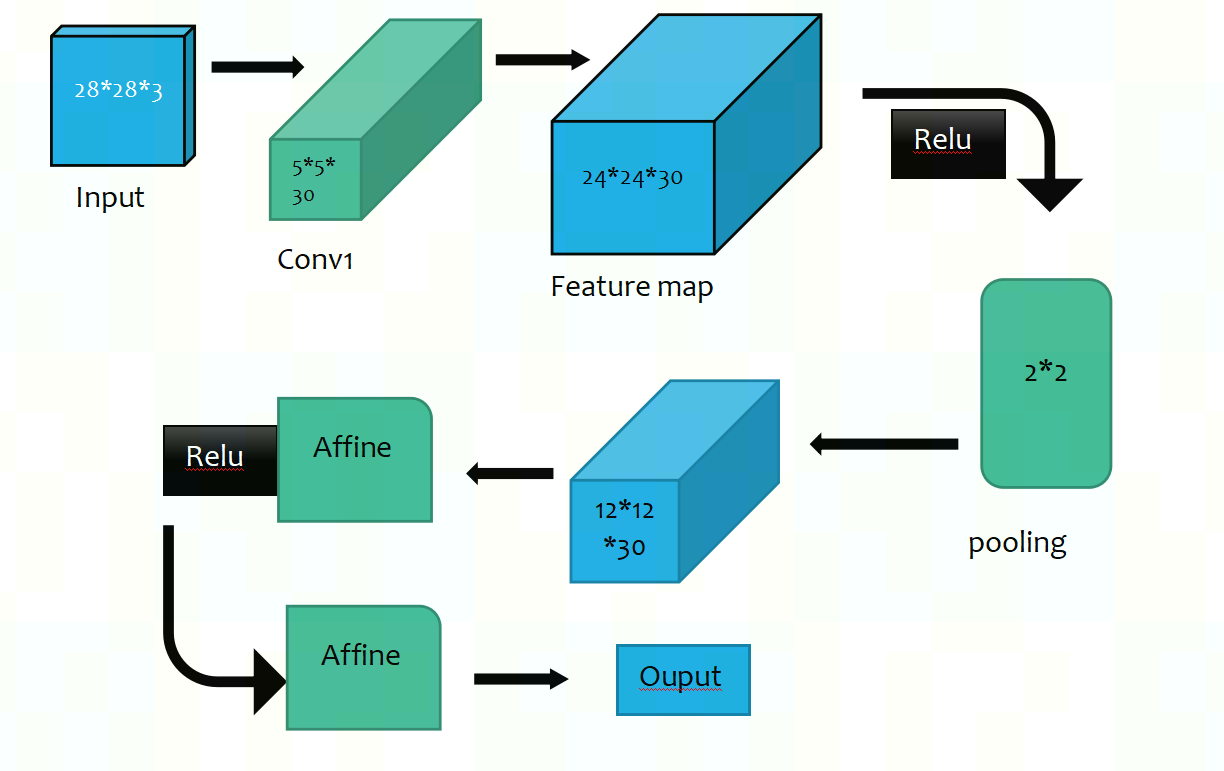

本篇会实现一个名为 SampleNet的简单神经网络,该神经网络会使用到 第九章实现的conv 操作和第十章中实现的pooling操作。SimpleNet是用来检验我们实现的Op 是否正确,所采用的数据集依旧是 mnist;

结构大致如下:

具体代码详情见 https://github.com/Leezhen2014/python_deep_learning

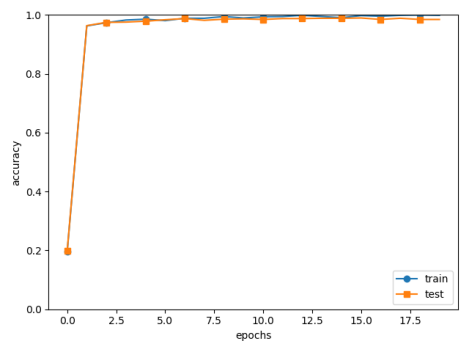

程序的输出:

=============== Final Test Accuracy ===============

test acc:0.9882

11.2 神经网络的可视化

回顾前几张我们已经做到的事情:

1. 我们实现了conv+pool的操作,并利用自己写的conv/pooling 实现了一个网络;

2. 我们将网络训练后的权重保存到了一个pkl中;

3. 我们简单的测试了一下网络加载权重的功能;

实现以上的3个步骤以后,我们还可在可视化上做一些事情:

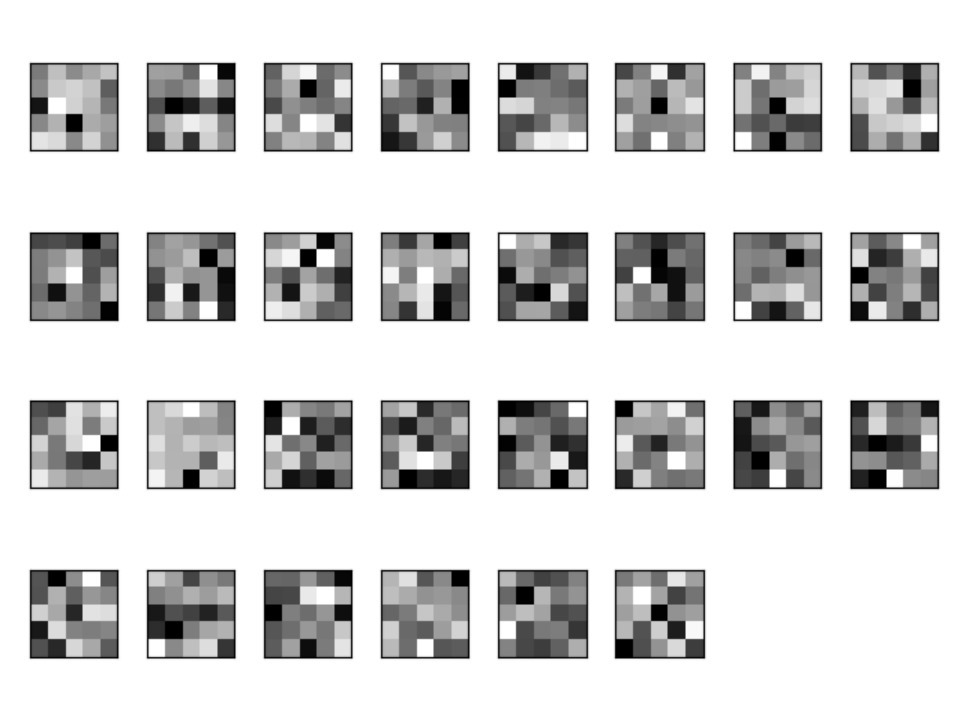

1. 实现filter的可视化: 这个很简单了,就是将训练好的文件(*.plk)重新加载到网络,然后把权重画出来;这里用到了skimage

2. 实现了feature map的可视化:这里的实现思路是: 1. 加载已经训练好的网络权重 --> 2.将一张图片作为训练样本输入 --> 3. 保存每一次filter产生的feature map;

因此本章的两个重点是 对filter 和feature map的可视化;

11.2.1 filter的可视化

分析: 由于我们在之前的训练神经网络的时候把权重weight都保存到w[1],w[2]中,因此只需要加载一个已经训练好的神经网络,然后将filter可视化即可;

代码详情见 python_deep_learning\src\test\testVisibaleFilter.py

Filter的可视化效果如下:

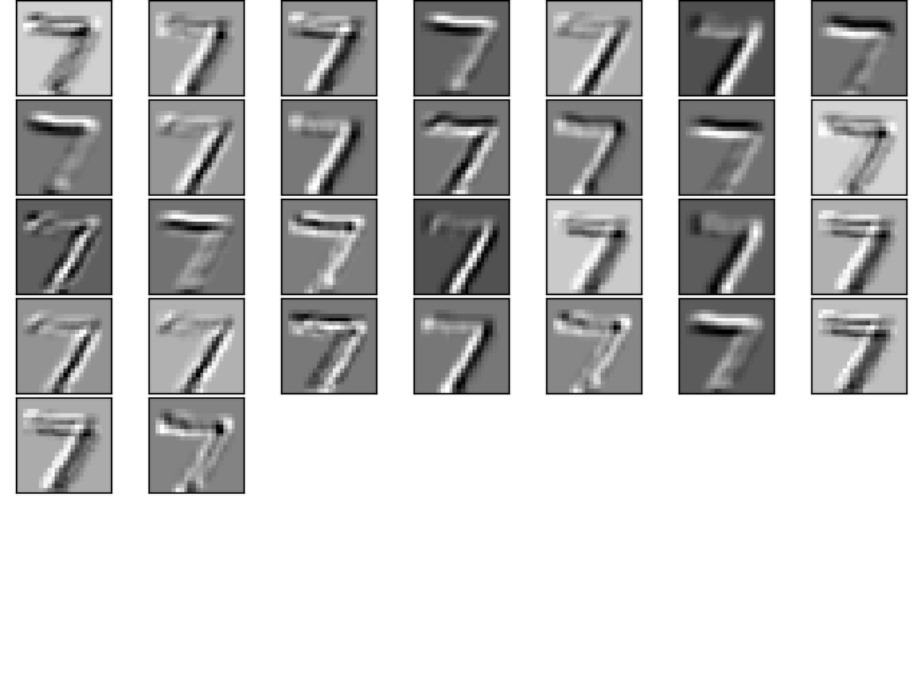

11.2.2 Feature map的可视化

Feature map 的可视化比较复杂一些,假设我们需要获取conv 层输出的feature map; 需要先获取conv层的引用;

目前的SimpleNet中并没有提供获取layer成员的方法,因此我们需要现在SimpleNet中添加getLayer();

具体的实现也很简单:

1 def getLayers(self): 2 """ 3 add by 2021/04/01 4 for feature map Visualization 5 """ 6 return self.layers 7 8 有了这个方法后,当我们加载权重文件以后,就能够获取每层输出的特征图了, 具体的使用方法如下: 9 network = SimpleConvNet() 10 network.load_params("params.pkl") 11 # load data 12 (x_train, t_train), (x_test, t_test) = load_mnist(flatten=True, normalize=False) 13 x = x_test[0].reshape(1,1,28,28) 14 # result=network.predict(x) 15 # y = np.argmax(result) 16 # print(y) 17 # shou input 18 19 ### show featurn map 20 conv1=network.getLayers()['Conv1'] 21 feature_maps = conv1.forward(x) 22 print("shape of feature_map :",str(feature_maps.shape)) # (1, 30, 24, 24) 23

详情代码见:github )

代码运行后,对特征途的可视化效果如下: