环境

windows7 64位

JDK环境已经配置好(测试的是jdk1.8.0_191)

hadoop体现结构:

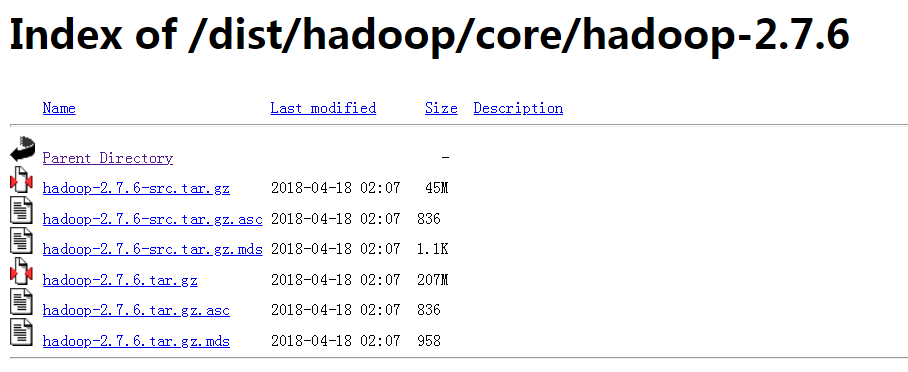

下载Hadoop,地址 http://archive.apache.org/dist/hadoop/core/ 我选择的版本是hadoop-2.7.6,进入如目录后下载hadoop-2.7.6.tar.gz文件

下载完成后解压文件,我解压到D:\hadoop-2.7.6

配置环境变量

1.HADOOP_HOME的值为D:\hadoop-2.7.6

2.接着编辑环境变量path,加入%HADOOP_HOME%\bin;

修改hadoop配置文件

在创建“D:\hadoop-2.7.6”下创建workplace文件夹,然后在workplace里面创建data,name,tmp文件夹

1.编辑“D:\hadoop-2.7.6\etc\hadoop”下的core-site.xml文件

<configuration> <property> <name>hadoop.tmp.dir</name> <value>/D:/hadoop-2.7.6/workplace/tmp</value> </property> <property> <name>dfs.name.dir</name> <value>/D:/hadoop-2.7.6/workplace/name</value> </property> <property> <name>fs.default.name</name> <value>hdfs://localhost:9000</value> </property> </configuration>

2.编辑“D:\hadoop-2.7.6\etc\hadoop目录下的mapred-site.xml(没有就将mapred-site.xml.template重命名为mapred-site.xml)文件

<configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> <property> <name>mapred.job.tracker</name> <value>hdfs://localhost:9001</value> </property> </configuration>

3.编辑“D:\hadoop-2.7.6\etc\hadoop”目录下的hdfs-site.xml文件

<configuration> <!-- 这个参数设置为1,因为是单机版hadoop --> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.data.dir</name> <value>/D:/hadoop-2.7.6/workplace/data</value> </property> </configuration>

4.编辑“D:\hadoop-2.7.6\etc\hadoop”目录下的yarn-site.xml文件

<configuration> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name> <value>org.apache.hadoop.mapred.ShuffleHandler</value> </property> </configuration>

5.编辑“D:\hadoop-2.7.6\etc\hadoop”目录下的hadoop-env.cmd文件,将JAVA_HOME用 @rem注释掉,编辑为JAVA_HOME的路径(JDK安装在C:\Program Files\Java\jdk1.8.0_191),然后保存;

@rem The java implementation to use. Required.

@rem set JAVA_HOME=%JAVA_HOME%

set JAVA_HOME=C:\PROGRA~1\Java\jdk1.8.0_191

替换文件

下载到的hadooponwindows-master.zip,(链接:https://pan.baidu.com/s/1AZEDLb6XijXHQrbZ4nzXpQ 密码:jvf8)解压,将bin目录(包含以下.dll和.exe文件)文件替换原来hadoop目录下的bin目录

运行测试

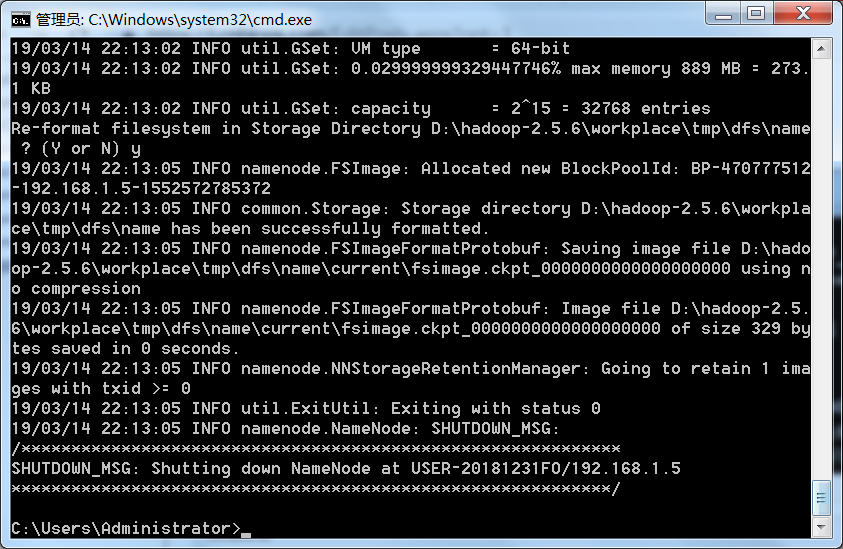

1.运行cmd窗口,执行“hdfs namenode -format”; (如果失败,有可能是环境变量没有起作用,重启一下就可以了)

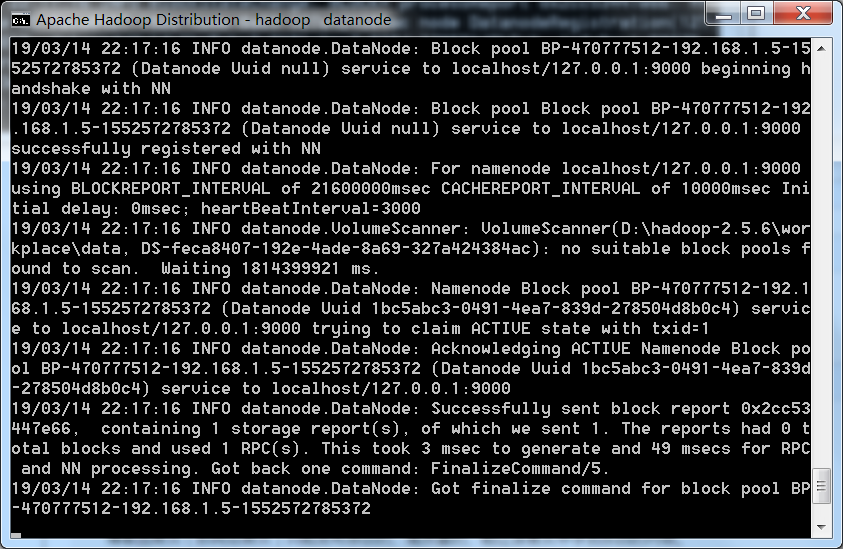

2.运行cmd窗口,切换到hadoop的sbin目录,执行“start-all.cmd”,它将会启动以下进程。

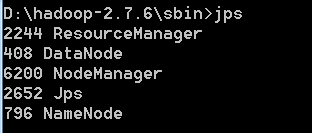

输入jps,可以查看运行的所有节点

1.创建输入目录

D:\hadoop-2.7.6\sbin>hadoop fs -mkdir hdfs://localhost:9000/user/

D:\hadoop-2.7.6\sbin>hadoop fs -mkdir hdfs://localhost:9000/user/wcinput

2.上传数据到目录,在D盘下创建file1.txt和file2.txt,在文件中随意输入内容

D:\hadoop-2.7.6\sbin>hadoop fs -put D:\file1.txt hdfs://localhost:9000/user/wcin

put

D:\hadoop-2.7.6\sbin>hadoop fs -put D:\file2.txt hdfs://localhost:9000/user/wcin

put

3.查看文件

D:\hadoop-2.7.6\sbin>hadoop fs -ls hdfs://localhost:9000/user/wcinput

hadoop自带的web控制台GUI

1.资源管理GUI:http://localhost:8088/;

2.节点管理GUI:http://localhost:50070/;

浙公网安备 33010602011771号

浙公网安备 33010602011771号