给不明白深度学习能干什么的同学,感受下深度学习的power

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 | import tensorflow as tfimport numpy as np#使用numpy生成100个随机点x_data=np.random.rand(100)y_data=x_data*0.1+0.2 #这里我们设定已知直线的k为0.1 b为0.2得到y_data#构造一个线性模型b=tf.Variable(0.)k=tf.Variable(0.)y=k*x_data+b#二次代价函数(白话:两数之差平方后取 平均值)loss=tf.reduce_mean(tf.square(y_data-y))#定义一个梯度下降法来进行训练的优化器(其实就是按梯度下降的方法改变线性模型k和b的值,注意这里的k和b一开始初始化都为0.0,后来慢慢向0.1、0.2靠近)optimizer=tf.train.GradientDescentOptimizer(0.2) #这里的0.2是梯度下降的系数也可以是0.3...#最小化代价函数(训练的方式就是使loss值最小,loss值可能是随机初始化100个点与模型拟合出的100个点差的平方相加...等方法)train=optimizer.minimize(loss)#初始化变量init=tf.global_variables_initializer()with tf.Session() as sess: sess.run(init) for step in range(201): sess.run(train) if step%20==0: print(step,sess.run([k,b])) #这里使用fetch的方式只是打印k、b的值,每20次打印一下,改变k、b的值是梯度下降优化器的工作 |

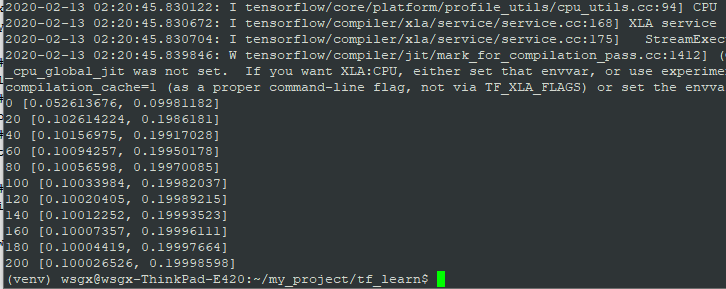

贴一张我的运行结果:

看,k和b在一步步逼近0.1和0.2,是不是很神奇!最终的误差仅为0.000026526和0.00001402,厉害吧,感受到深度学习的强大了么,这里还只是一个神经元,如果成千上万个甚至几十万个会有什么效果呢?(效果就是不好优化,哈哈哈哈哈 :p)

目录:

- tensorflow简介、目录

- tensorflow中的图(02-1)

- tensorflow变量的使用(02-2)

- tensorflow中的Fetch、Feed(02-3)

- tensorflow版helloworld---拟合线性函数的k和b(02-4)

- tensorflow非线性回归(03-1)

- MNIST手写数字分类simple版(03-2)

- 二次代价函数、交叉熵(cross-entropy)、对数似然代价函数(log-likelihood cost)(04-1)

- 多层网络通过防止过拟合,增加模型的准确率(04-2)

- 修改优化器进一步提升准确率(04-3)

- 手写数字识别-卷积神经网络cnn(06-2)

- 循环神经网络rnn与长短时记忆神经网络简述(07-2)

- 循环神经网络lstm代码实现(07-3)

- tensorflow模型保存和使用08

- 下载inception v3 google训练好的模型并解压08-3

- 使用inception v3做各种图像分类识别08-4

- word2vec模型训练简单案例

- word2vec+textcnn文本分类简述及代码

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】博客园携手 AI 驱动开发工具商 Chat2DB 推出联合终身会员

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步