如何理解关于 SARSA 算法中学习率(learning rate) 𝛼 𝑡 ( 𝑠 , 𝑎 ) 的要求?

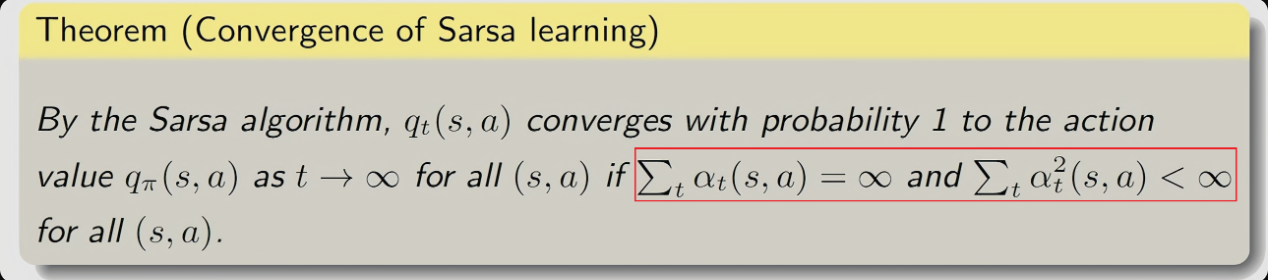

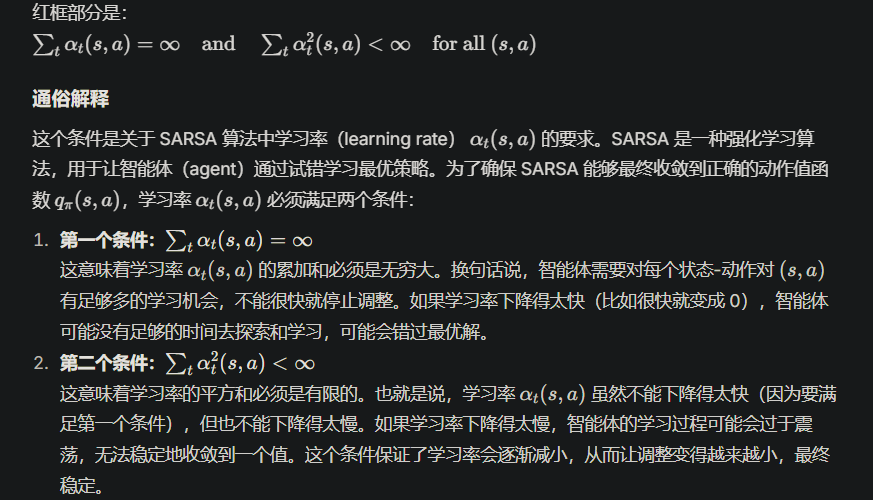

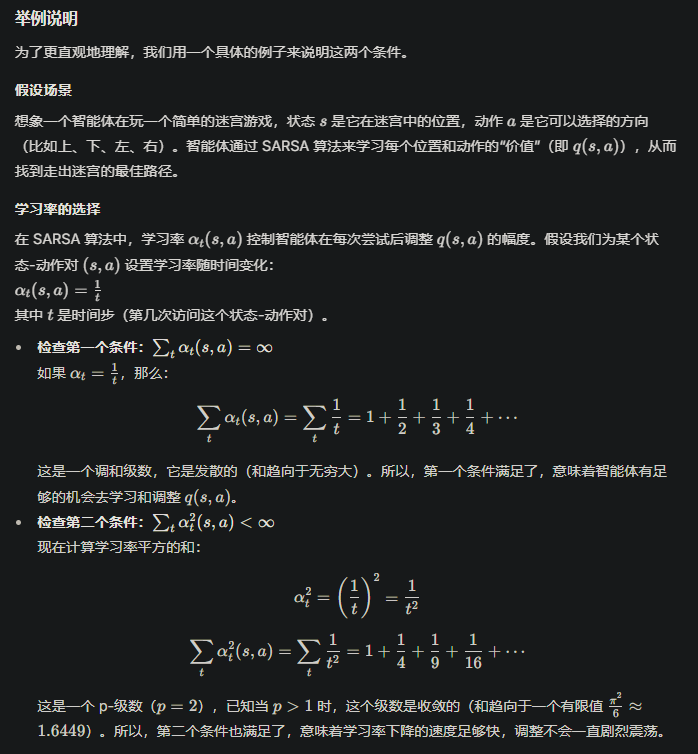

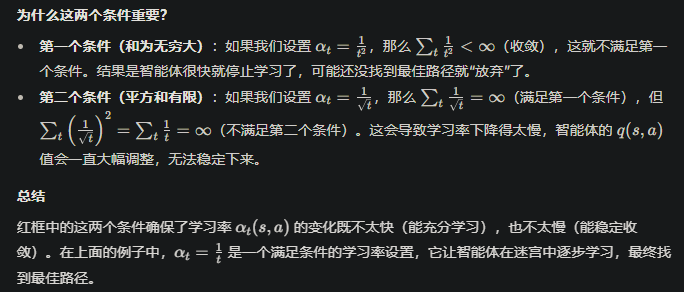

1、也就是如何理解Sarsa算法中如下这个约束条件。

2、强化学习中,核心关键名词的理解。例如episode 和 圆周率 π

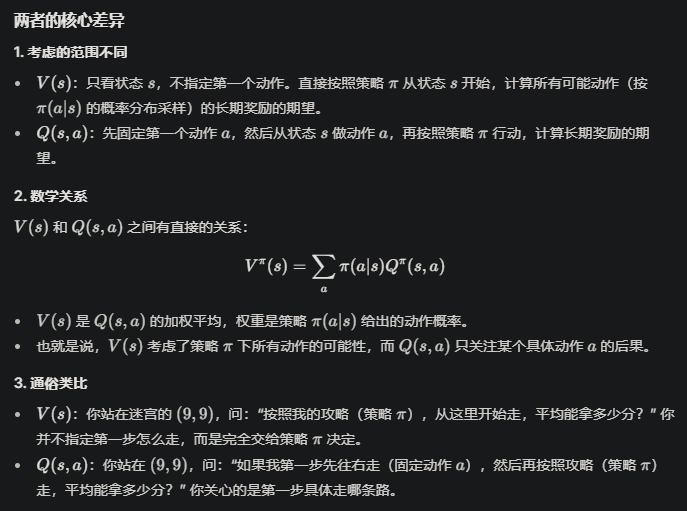

3、策略和Action我还有点混淆,策略是一个概率分布,比如在迷宫游戏中,指导说下一步该超哪个方向走。但Action不是也是下一步往哪个方向走吗,这两个不就概念重复了么?

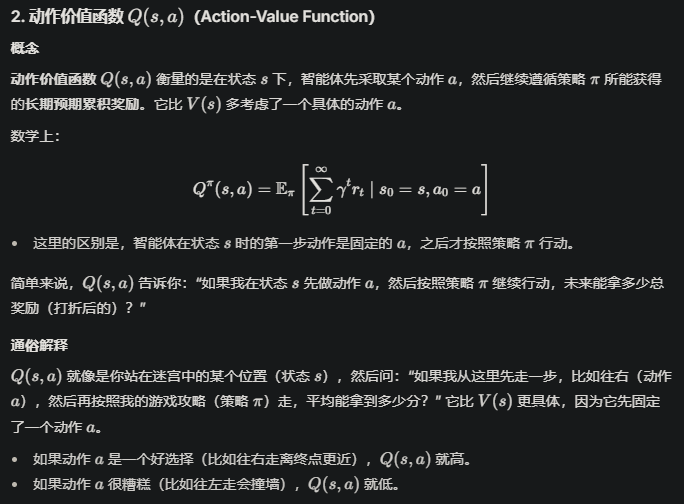

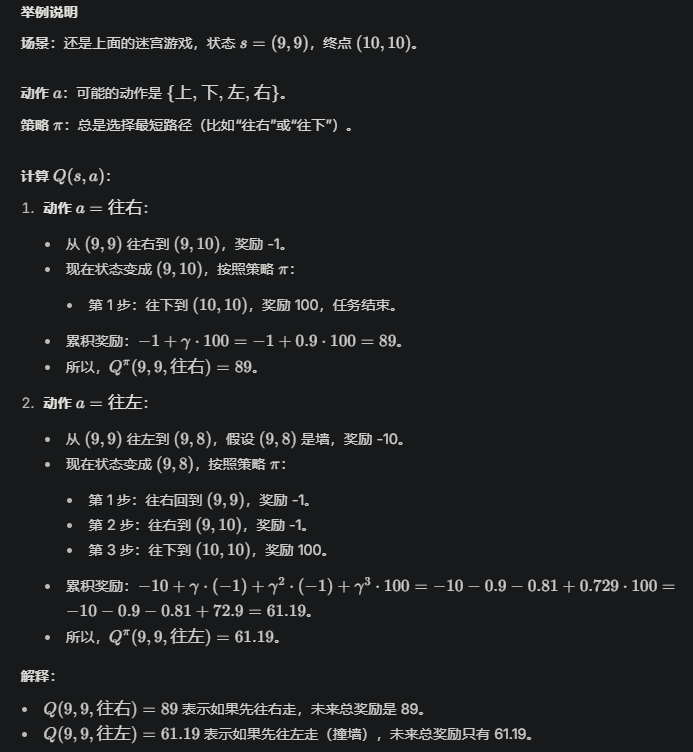

4、对于价值函数(Value Function) 中的 状态价值函数和动作价值函数,如何理解两者差异?

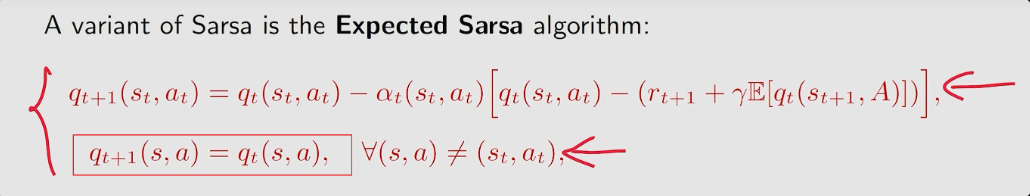

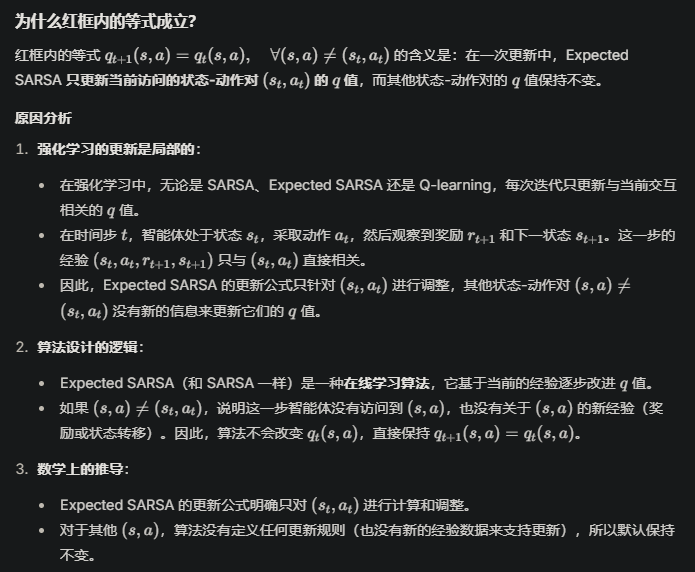

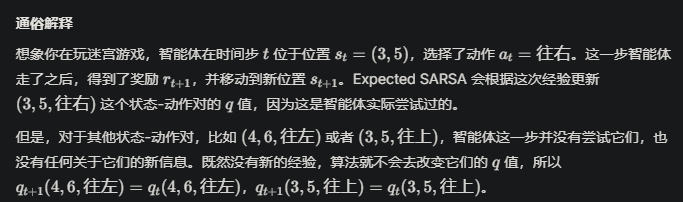

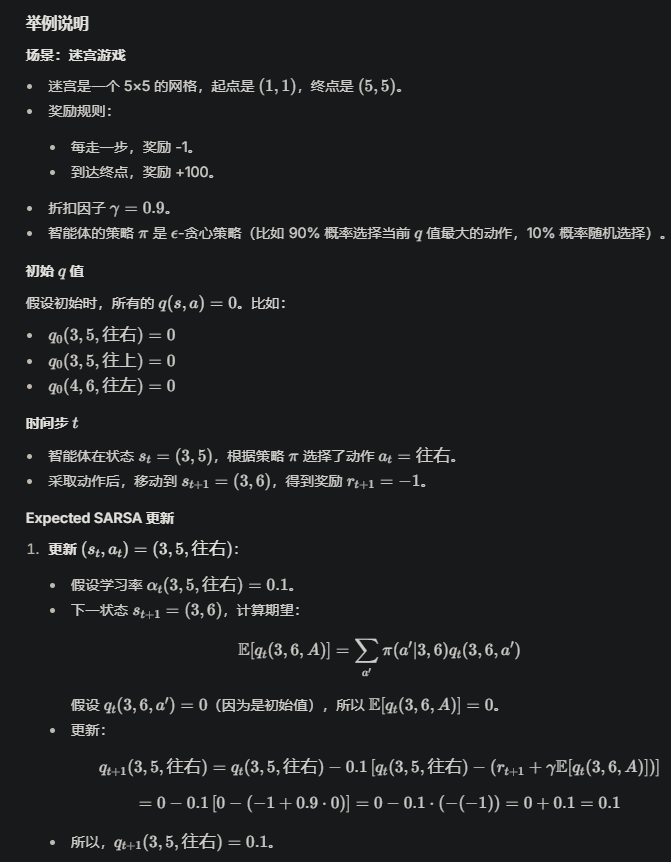

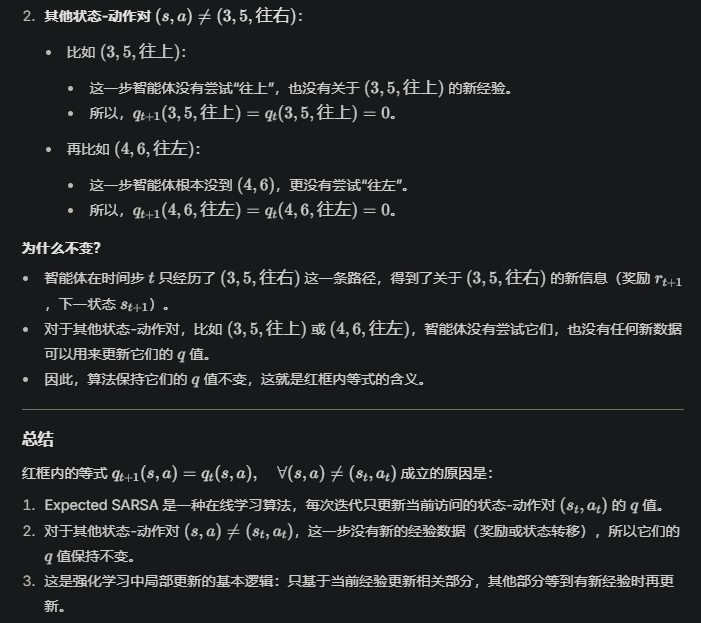

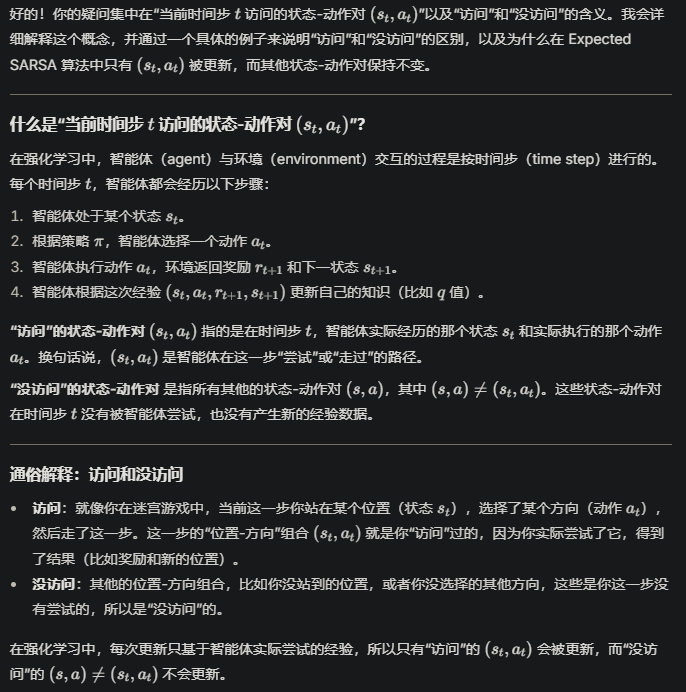

5、如何理解如下红框内的内容。为什么该等式成立?

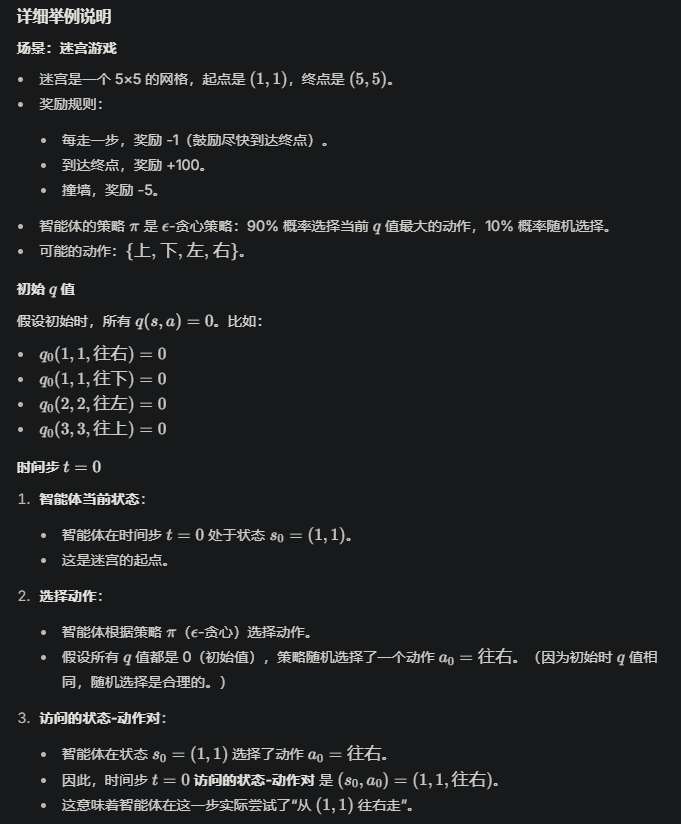

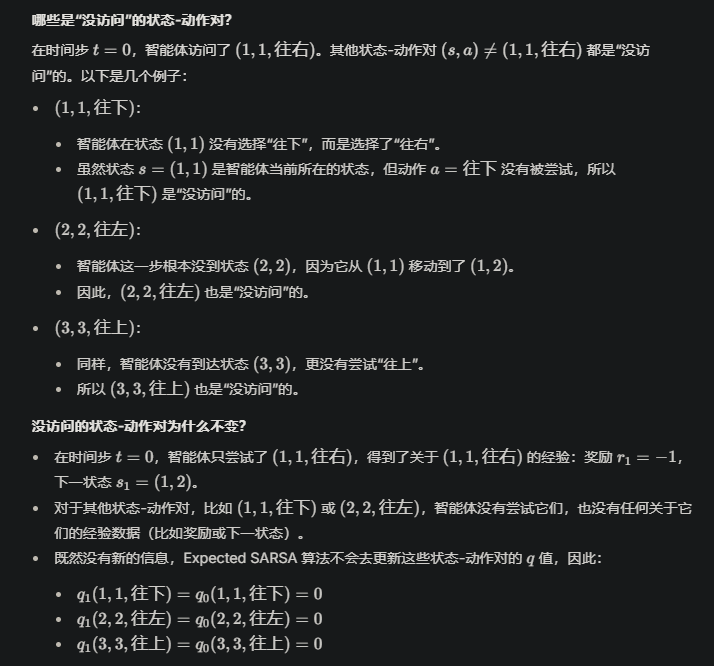

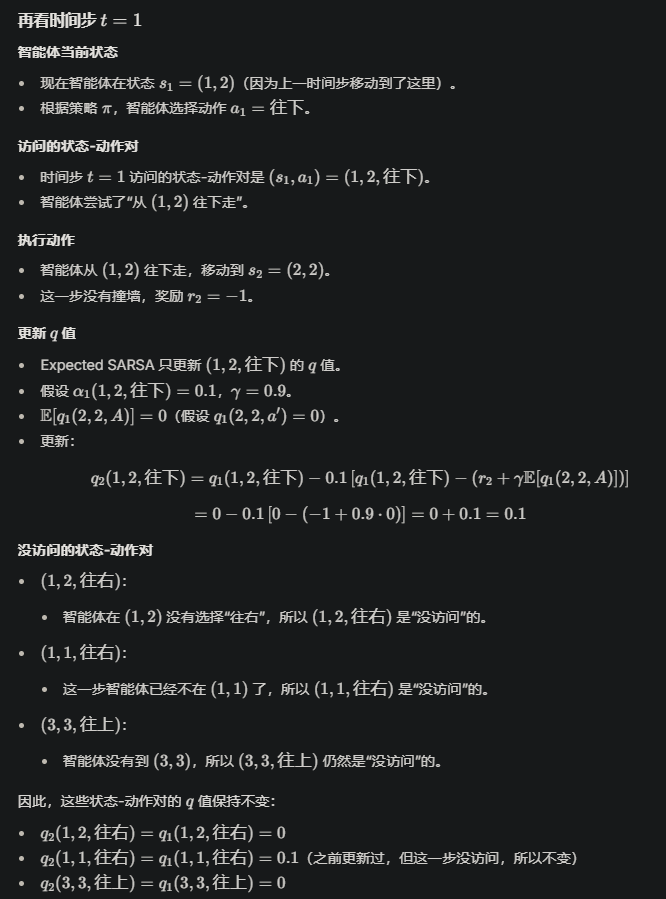

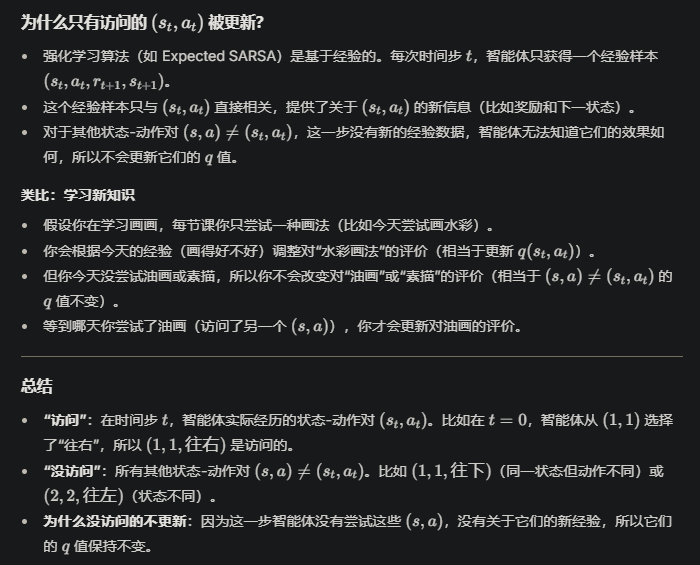

接下来我将详细分析红框内的等式,解释为什么它成立。这个等式涉及 Expected SARSA 算法与标准 SARSA 算法的区别,

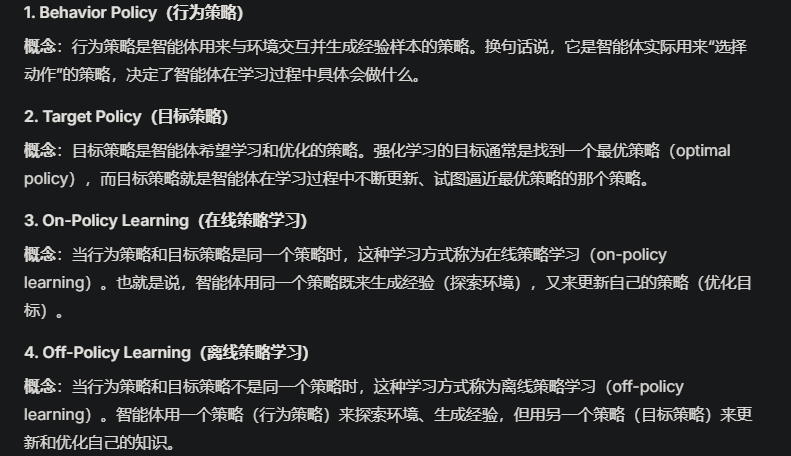

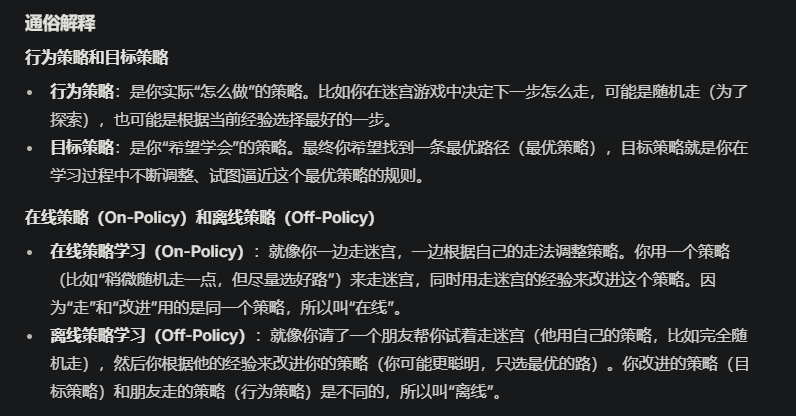

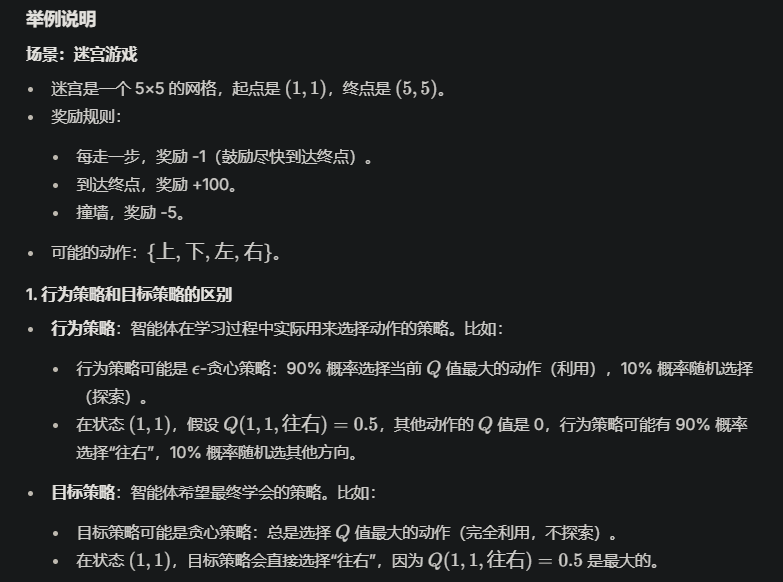

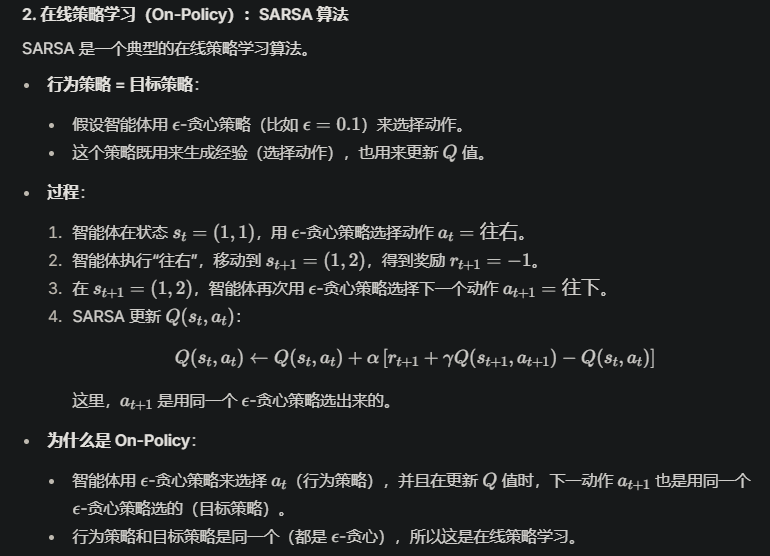

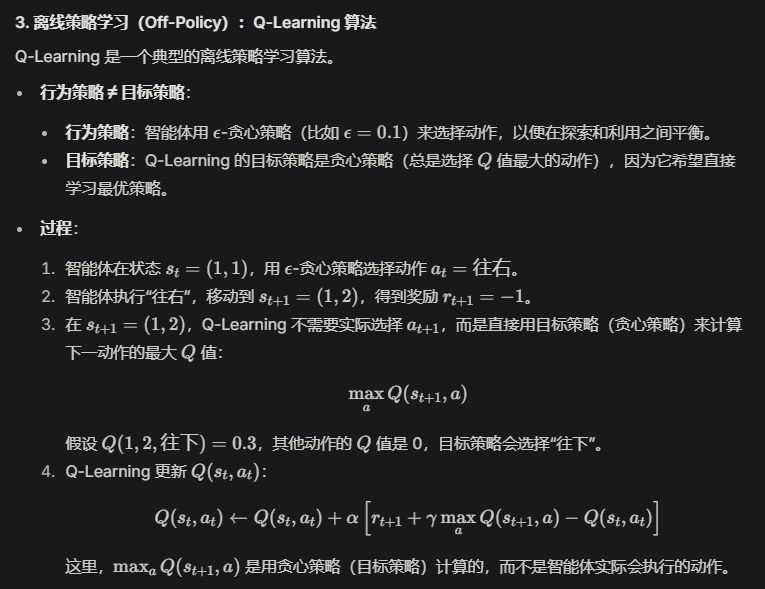

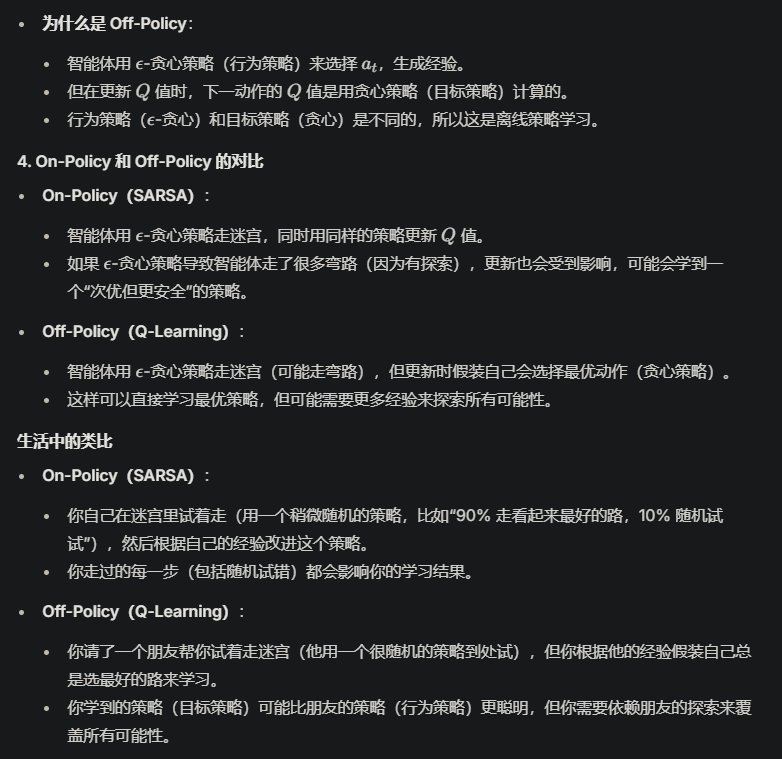

7、如何理解on-policy learning(在线策略学习) 和 off-policy learning(离线策略学习),以及相关的 behavior policy(行为策略) 和 target policy(目标策略)。?

在强化学习(Reinforcement Learning, RL)中,有很多关键名词,它们是理解和应用强化学习算法的基础。我会挑选几个核心概念,包括你提到的 episode 和 圆周率 π\piπ(这里我猜你可能是指策略 π\piπ,因为圆周率 Π\PiΠ 通常是数学中的常数 3.14159...,在强化学习中不太常见)。我会逐一解释这些名词的概念、作用、通俗解释,并通过举例说明。

1. Episode(回合)

概念

在强化学习中,episode 指的是智能体(agent)与环境(environment)交互的一个完整过程,从初始状态开始,到终止状态(比如任务完成或失败)为止。一个 episode 包含了智能体经历的一系列状态、动作和奖励。

作用

- Episode 是强化学习中任务划分的基本单位,用于定义一个完整的交互过程。

- 在基于回合的任务(episodic tasks)中,智能体通过多个 episode 的试错来学习最优策略。

- 统计和分析多个 episode 的结果(如总奖励)可以评估智能体的表现。

通俗解释

你可以把 episode 想象成玩一局游戏。比如你在玩一个迷宫游戏,从起点走到终点(或者中途失败)就算一局结束,这就叫一个 episode。每一局游戏中,你会尝试不同的走法,得到奖励(比如走到终点得 100 分,撞墙扣 10 分),然后通过多局游戏来学习怎么走得更好。

举例说明

- 场景:智能体在迷宫中学习走出迷宫。

- Episode 定义:从起点开始,走到终点(成功)或者撞墙次数超过上限(失败)算一个 episode。

- 过程:

- Episode 1:智能体从起点出发,随机走,撞了 5 次墙,失败了,总奖励 -50。

- Episode 2:智能体又从起点出发,吸取教训,走了一条新路径,成功到达终点,总奖励 100。

- 通过多个 episode,智能体逐渐学会避开墙,找到最短路径。

2. Policy(策略 π\piπ)

概念

在强化学习中,policy(策略,用 π\piπ 表示)是智能体用来决定行动的规则。它定义了在给定状态 sss 下,智能体选择动作 aaa 的概率分布:π(a∣s)\pi(a|s)π(a∣s)。策略可以是确定性的(直接给出某个动作),也可以是随机的(给出动作的概率分布)。

作用

- 策略是智能体与环境交互的核心,决定了智能体的行为。

- 强化学习的目标通常是找到一个最优策略 π∗\pi^*π∗,使得智能体在长期交互中获得最大的累积奖励。

- 策略可以用来探索环境(试错)或利用已有知识(选择已知的最优动作)。

通俗解释

策略就像是你玩游戏时的“决策指南”。比如在迷宫游戏中,策略告诉你“如果我在这个位置,往右走有 70% 的概率,往左走有 30% 的概率”。一个好的策略会让你更快走到终点,而一个差的策略可能会让你一直撞墙。强化学习就是要通过试错,找到一个最好的“决策指南”。

举例说明

- 场景:智能体在迷宫中,状态 sss 是当前位置,动作 aaa 是上下左右移动。

- 策略:

- 初始策略 π\piπ:在每个位置随机选择一个方向(概率都是 25%)。

- 学习后策略 π∗\pi^*π∗:在某个位置,策略变成“90% 概率往右走(因为右边是通往终点的路),10% 概率往上走(探索其他可能性)”。

- 效果:有了最优策略 π∗\pi^*π∗,智能体几乎每次都能快速走出迷宫。

3. State(状态 sss)

概念

State 是描述环境当前情况的信息,表示智能体所处的“位置”或“情境”。在数学上,状态 sss 属于状态空间 SSS,可以是离散的(有限个状态)或连续的(无限个状态)。

作用

- 状态是智能体感知环境的基础,用于决定下一步采取什么动作。

- 状态的好坏直接影响策略的效果,强化学习需要通过状态来建模环境。

通俗解释

状态就像是你玩游戏时看到的“游戏画面”。比如在迷宫游戏中,状态可能是你的当前位置(比如坐标 (3, 5))。这个信息告诉你“现在我在哪里”,然后你根据这个信息决定下一步怎么走。

举例说明

- 场景:还是迷宫游戏。

- 状态:智能体的位置,比如 s=(3,5)s = (3, 5)s=(3,5) 表示智能体在迷宫的第 3 行第 5 列。

- 作用:智能体根据状态 s=(3,5)s = (3, 5)s=(3,5) 查询策略 π(a∣s)\pi(a|s)π(a∣s),决定是往右走(旁边有路)还是往左走(那边是墙)。

4. Action(动作 aaa)

概念

Action 是智能体在某个状态下可以采取的行为,属于动作空间 AAA。动作可以是离散的(比如“左、右”)或连续的(比如“转动方向盘的角度”)。

作用

- 动作是智能体与环境交互的方式,通过动作改变状态并获得奖励。

- 强化学习的目标是通过选择合适的动作来最大化长期奖励。

通俗解释

动作就是你在游戏中“按下的按钮”。比如在迷宫游戏中,你可以选择“往左走”或“往右走”,这就是你的动作。每次行动都会改变你的位置(状态),并可能带来奖励或惩罚。

举例说明

- 场景:迷宫游戏。

- 动作:智能体在状态 s=(3,5)s = (3, 5)s=(3,5) 时可以选择动作 a∈{上, 下, 左, 右}a \in \{\text{上, 下, 左, 右}\}a∈{上, 下, 左, 右}。

- 结果:如果智能体选择“往右”,状态可能变成 s′=(3,6)s' = (3, 6)s′=(3,6),并获得奖励(比如 +1,因为离终点近了)。

5. Reward(奖励 rrr)

概念

Reward 是环境对智能体动作的反馈,是一个标量值(通常是数字),表示某个动作的好坏。奖励由环境给出,智能体通过奖励来判断自己的行为是否有效。

作用

- 奖励是智能体学习的信号,告诉智能体哪些行为是好的,哪些是坏的。

- 强化学习的目标是最大化累积奖励(而不是单次奖励)。

通俗解释

奖励就像是游戏中的“得分”。比如你玩迷宫游戏,走到终点得 100 分,撞墙扣 10 分。智能体会根据这些得分来调整自己的行为,尽量多拿分,少扣分。

举例说明

- 场景:迷宫游戏。

- 奖励:

- 智能体每走一步,奖励 -1(鼓励尽快到达终点)。

- 到达终点,奖励 +100。

- 撞墙,奖励 -10。

- 效果:智能体通过多次尝试,学会避开墙,尽快走到终点,因为这样可以得到更多的累积奖励。

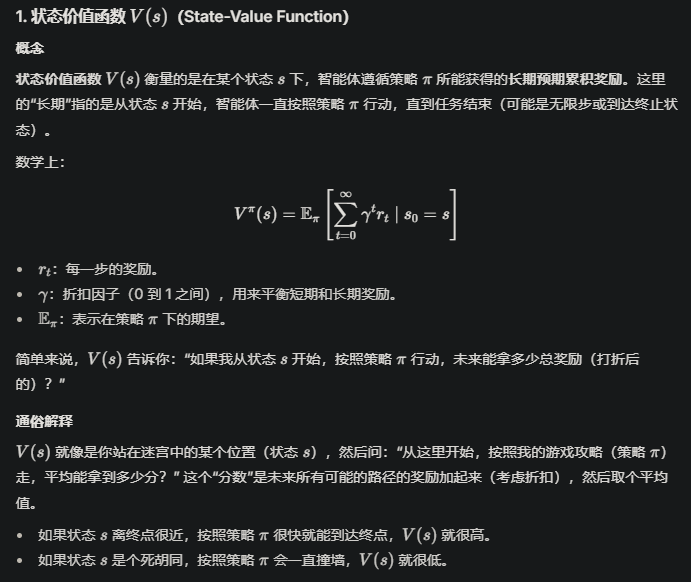

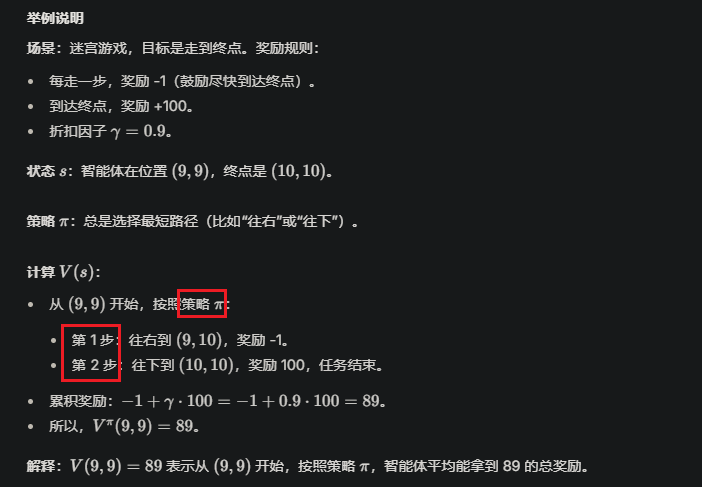

6. Value Function(价值函数 V(s)V(s)V(s) 或 Q(s,a)Q(s, a)Q(s,a))

概念

Value Function 用来评估状态或状态-动作对的长期价值。

- 状态价值函数 V(s)V(s)V(s):在状态 sss 下,遵循策略 π\piπ 能获得的预期累积奖励。

- 动作价值函数 Q(s,a)Q(s, a)Q(s,a):在状态 sss 下采取动作 aaa,然后遵循策略 π\piπ 能获得的预期累积奖励。

作用

- 价值函数帮助智能体评估不同状态或动作的“前景”,从而选择最优动作。

- 很多强化学习算法(如 Q-learning、SARSA)通过更新价值函数来学习最优策略。

通俗解释

价值函数就像是你对游戏中每个位置的“估值”。比如在迷宫中,离终点近的位置价值高(因为从那里更容易拿到高奖励),而容易撞墙的位置价值低。Q(s,a)Q(s, a)Q(s,a) 则是告诉你“在这个位置选这个动作,未来能拿多少分”。

举例说明

- 场景:迷宫游戏。

- 价值函数:

- V(s)V(s)V(s):状态 s=(9,9)s = (9, 9)s=(9,9)(离终点很近)的价值可能是 95,因为从这里很快能走到终点。

- Q(s,a)Q(s, a)Q(s,a):在 s=(3,5)s = (3, 5)s=(3,5),选择 a=往右a = \text{往右}a=往右 的 Q(3,5,往右)=50Q(3, 5, \text{往右}) = 50Q(3,5,往右)=50,而 a=往左a = \text{往左}a=往左(那边是墙)的 Q(3,5,往左)=−10Q(3, 5, \text{往左}) = -10Q(3,5,往左)=−10。

- 作用:智能体通过比较 QQQ 值,选择 a=往右a = \text{往右}a=往右,因为它的价值更高。

7. Exploration vs. Exploitation(探索与利用)

概念

Exploration(探索)是指智能体尝试新的动作,以发现可能更好的策略;Exploitation(利用)是指智能体选择已知的最优动作,以最大化当前奖励。强化学习需要在探索和利用之间找到平衡。

作用

- 探索确保智能体不会错过更好的策略。

- 利用确保智能体能充分利用已有的知识,获得高奖励。

通俗解释

探索和利用就像是你去一家餐厅吃饭时的选择。探索是尝试新菜(可能更好吃,也可能不好吃),利用是点你已经知道很好吃的菜。强化学习需要在“试新菜”和“吃老菜”之间找到平衡。

举例说明

- 场景:迷宫游戏。

- 探索:智能体在 s=(3,5)s = (3, 5)s=(3,5) 时,虽然知道“往右”效果好,但还是尝试“往上”,结果发现了一条更短的路。

- 利用:智能体在 s=(3,5)s = (3, 5)s=(3,5) 时直接选择“往右”,因为之前试过,知道这条路能带来高奖励。

- 平衡:常用的方法是 ϵ\epsilonϵ-贪心策略:以 90% 概率利用(选已知最好的动作),10% 概率探索(随机选动作)。

总结

以上是强化学习中的几个关键名词:Episode(回合)、Policy(策略 π\piπ)、State(状态)、Action(动作)、Reward(奖励)、Value Function(价值函数)、Exploration vs. Exploitation(探索与利用)。它们共同构成了强化学习的基本框架,帮助智能体通过试错学习最优行为。

浙公网安备 33010602011771号

浙公网安备 33010602011771号