GRU模型结构

一、概述:

GRU(Gate Recurrent Unit)是LSTM网络的一种效果很好的变体,它较LSTM网络的结构更加简单,而且效果也很好,因此也是当前非常流形的一种网络。GRU既然是LSTM的变体,因此也是可以解决RNN网络中的长依赖问题。

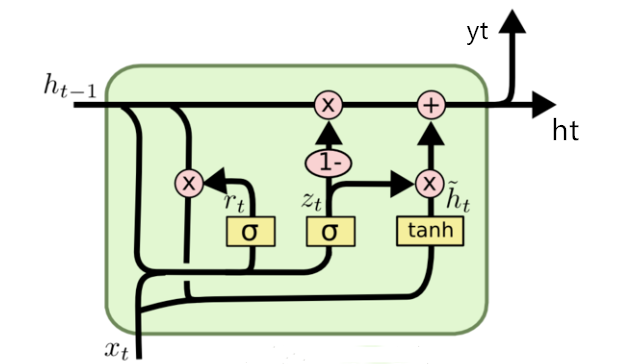

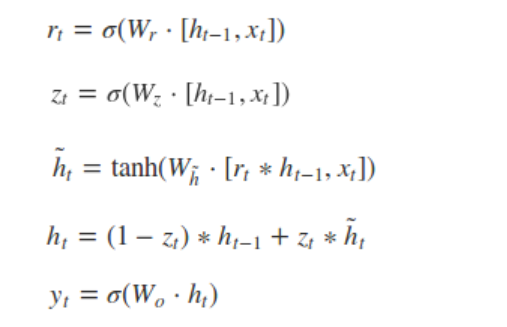

在LSTM中引入了三个门函数:输入门、遗忘门和输出门来控制输入值、记忆值和输出值。而在GRU模型中只有两个门:分别是更新门和重置门。具体结构如下图所示:

图中的rt和zt分别表示重置门和更新门。

- 重置门控制前一状态有多少信息被写入到当前的候选集

上,重置门越小,前一状态的信息被写入的越少。

上,重置门越小,前一状态的信息被写入的越少。 - 更新门用于控制前一时刻的状态信息被带入到当前状态中的程度,更新门的值越大说明前一时刻的状态信息带入越多

二、为什么有了LSTM还要GRU呢?

与LSTM相比,GRU内部少了一个”门控“,参数比LSTM少,但是却也能够达到与LSTM相当的功能。考虑到硬件的计算能力和时间成本,因而很多时候我们也就会选择更加”实用“的GRU啦。

参考链接: