深度学习算法-长短时记忆网络LSTM(Long Short Term Memory Network)

长短时记忆网络LSTM(Long Short Term Memory Network)

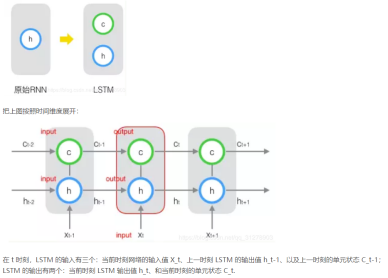

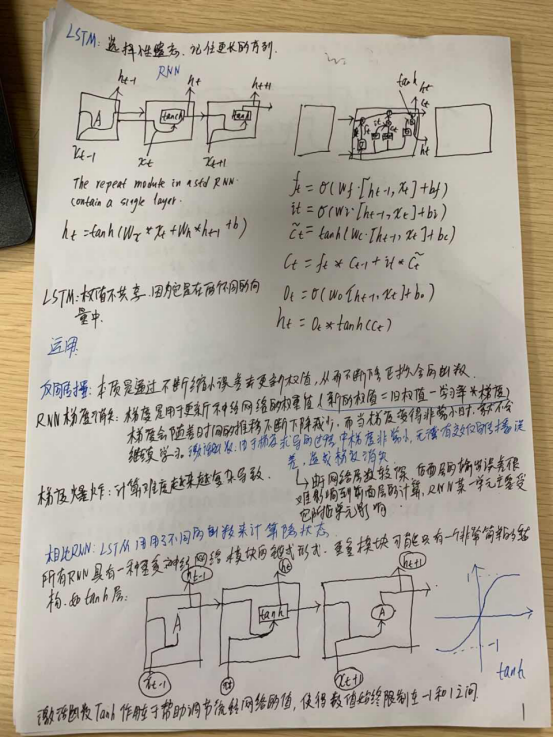

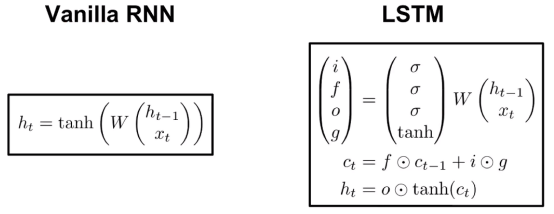

思路:原始 RNN 的隐藏层只有一个状态,即h,它对于短期的输入非常敏感。再增加一个状态,即c,让它来保存长期的状态,称为单元状态(cell state)。

例子参考:

大脑:working memory 3.1415926

RNN:Ct(cell state)

RNN:隐层+输入

LSTM:隐层+输入+隐层输入 3个门

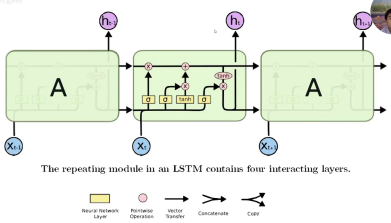

LSTM的结构:

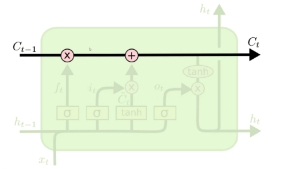

信息流可以一直流入,不用经过W。

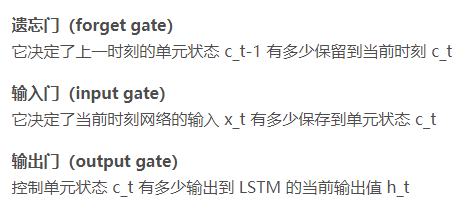

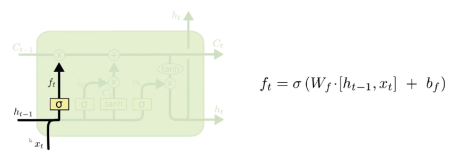

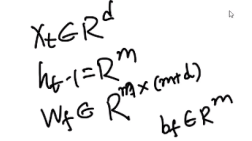

1.遗忘门

输入:xt:新的输入,ct-1过去记忆存储的东西,到新的时刻,有的信息没用了,根据xt和ht-1进行判断。

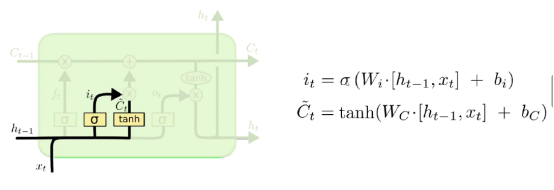

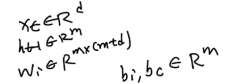

2.输入门:多少信息需要写进去

it:计算有多少比例信息需要写进去

Ct~:计算里面存在多少有用信息

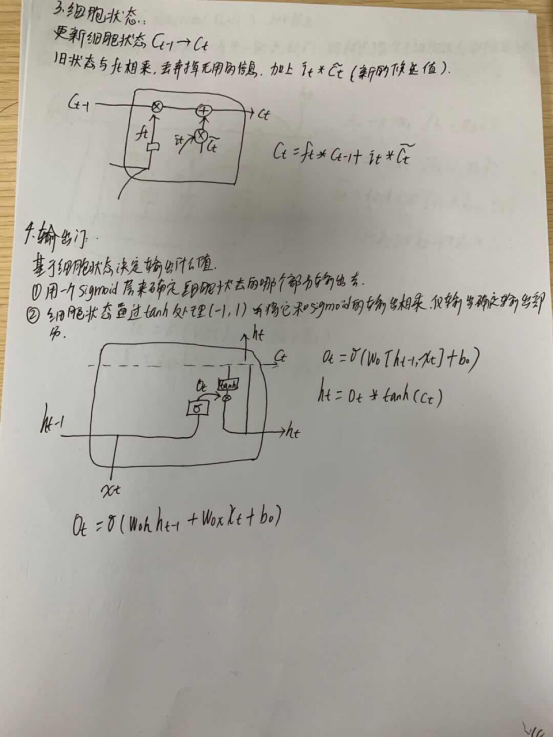

3.细胞状态

It:一直等于0,ft一直等于1,永久记忆。

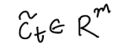

4.输出门

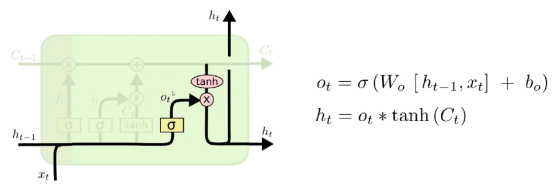

LSTM保持梯度流的原因:

ht和ct有点重复,ht加了过去的信息就行了。

于是有了GRU:

LSTM:只能看到前面的信息。

双向LSTM:可以看到前后的信息。

参考链接:

LSTM原理详解:https://blog.csdn.net/qq_31278903/article/details/88690959

以大多数人努力程度之低,根本轮不到去拼天赋~

浙公网安备 33010602011771号

浙公网安备 33010602011771号