【NeurIPS2022】Fast Vision Transformers with HiLo Attention

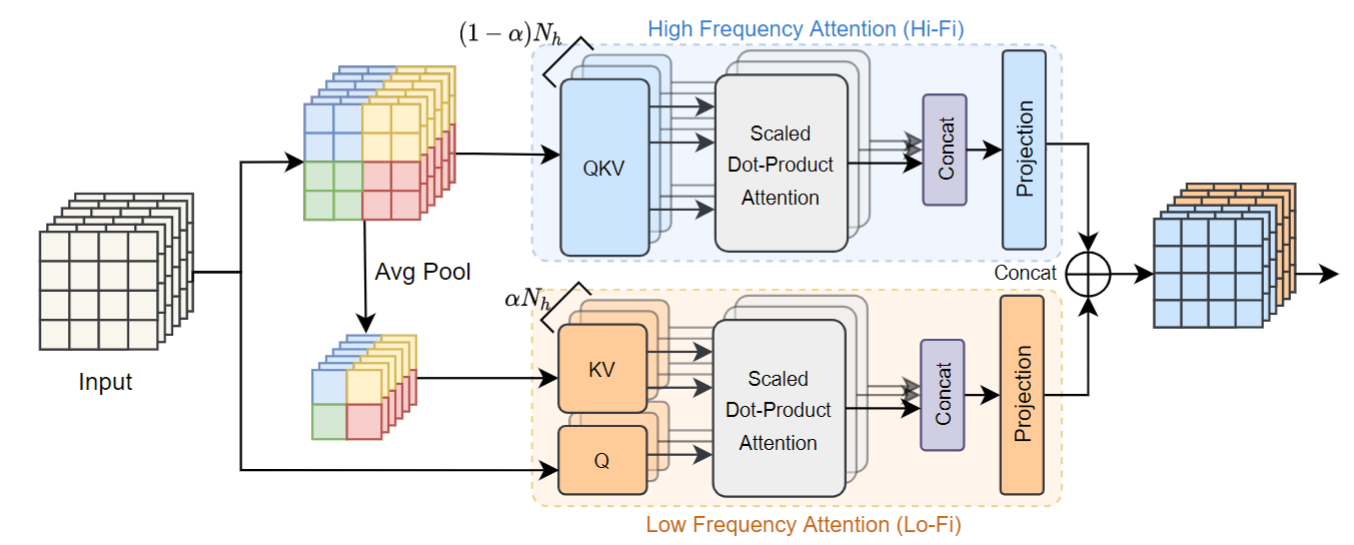

这个论文的核心贡献是提出了一种新的注意力机制 HiLo(High / Low frequency)。如下图所示,在上面部分,分配了 比例的 head 用于提取高频注意力,下面分配了 比例的 head 用于提取低频注意力。

高频注意力: 在2x2的窗口中计算 attention。

低频注意力: 将2x2的窗口池化,得到的特征做为 K 和 V。原始特征做为 Q,再计算注意力。(基本上和 PVT 中的计算方法一样)。因为 KV 特征维度减少,计算效率显著提升。

论文中还使用了一个 trick,使用 3x3 的 depth-wise conv 替换位置编码,这样不仅能引入 positional encoding,还能够增大网络前期的感受野。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 分享一个免费、快速、无限量使用的满血 DeepSeek R1 模型,支持深度思考和联网搜索!

· 使用C#创建一个MCP客户端

· ollama系列1:轻松3步本地部署deepseek,普通电脑可用

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· 按钮权限的设计及实现