【CVPR2022】Beyond Fixation: Dynamic Window Visual Transformer

【CVPR2022】Beyond Fixation: Dynamic Window Visual Transformer

个人感觉,这个论文的 idea 部分来自于 SKNet ,模块的图也类似。

大多数VIT都在固定的 7X7 窗口内计算局部 attention,忽略了窗口大小对性能的影响。因此,作者提出使用多尺度的窗口计算 attention,类似于 SKNet ,用 softmax 动态为各个分支的窗口分配权重。

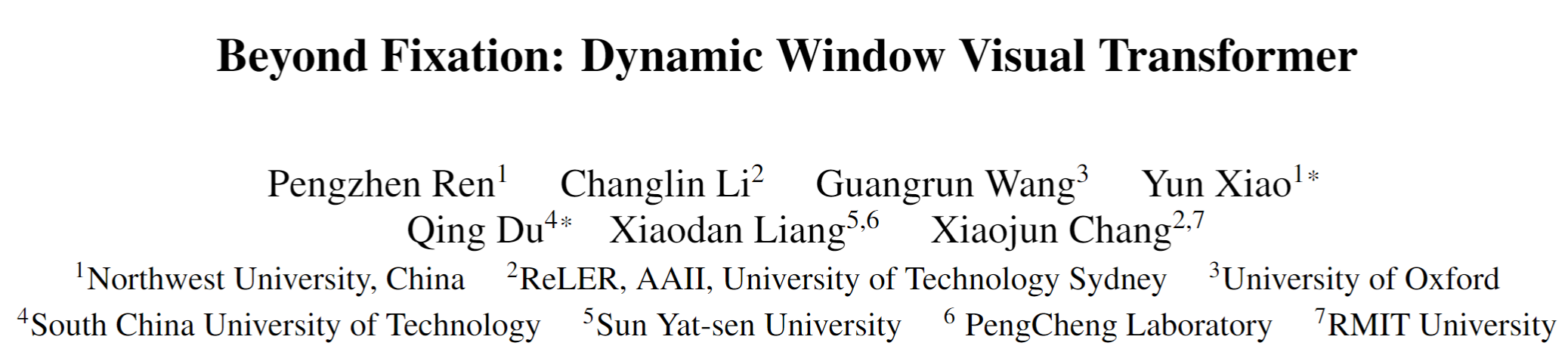

论文的核心就是下面这个 dynamic window module。可以看出,一共6个 channel 的数据,均分成三份,分别用尺寸为 7、14、21的 window 计算 attention ,最后将特征拼接,通过一系列pooling,FC层后,用 softmax 给各个通道分配权重,然后跟原始特征加权。

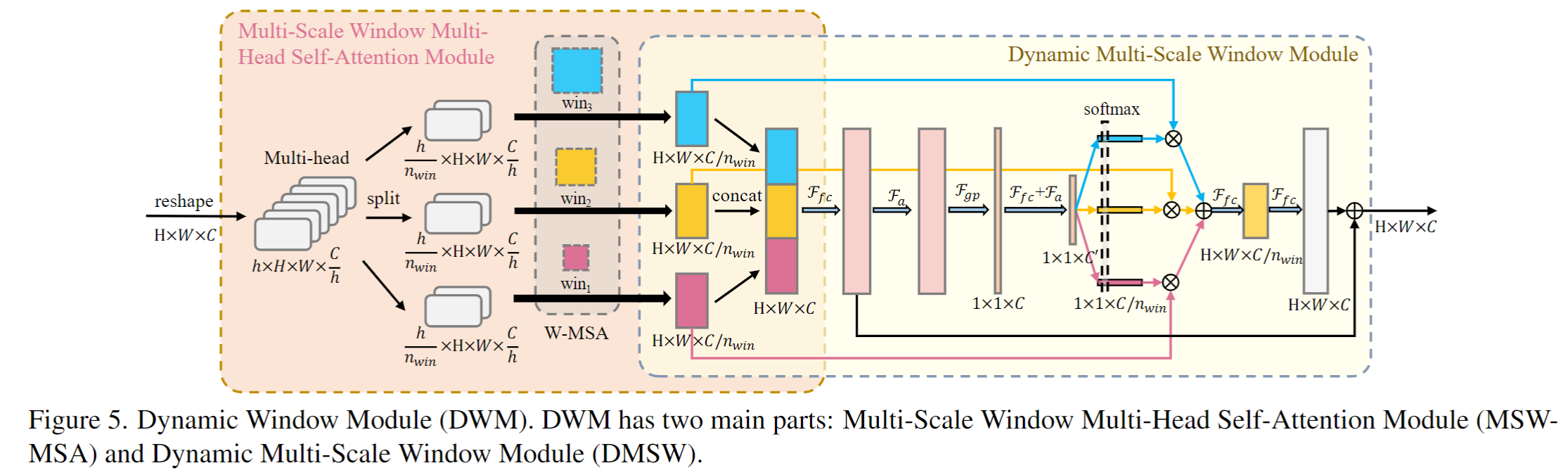

总体架构上还是标准的4阶段,如下图所示。

作者也指出,所提出的方法存在两个 limitation:

(1)DWM introduces a small number of additional parameters and calculations.

(2)As far as DWM's dynamic window mechanism is concerned, part of the computational budget is still allocated to suboptimal optional windows.

浙公网安备 33010602011771号

浙公网安备 33010602011771号