爬虫笔记(二):爬取网页的通用代码框架

BEGIN:

爬虫系列:

上节提到r.raise_for_status()异常方法,这里将给出爬虫的通用代码框架,并将该异常方法运用到代码中。

爬取网页的通用代码框架

import requests def getHTMLText(url): try: r = requests.get(url, timeout=30) r.raise_for_status() # 如果状态不是200,引发HTTPError异常 r.encoding = r.apparent_encoding return r.text except: return "产生异常" if __name__=="__main__": url = "http://www.baidu.com" print(getHTMLText(url))

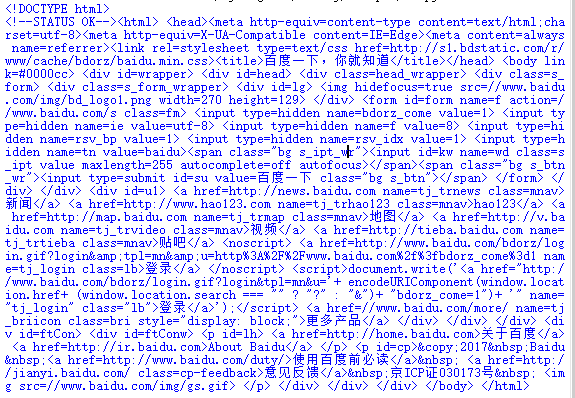

上述代码正常情况下返回百度页面的信息:

出现异常时,如去掉网页中的http://,则返回异常:

if __name__=="__main__": url = "www.baidu.com" print(getHTMLText(url))

结果如下:

END.

勇气,不过就是人在无路可退时那最后的孤注一掷。