总结2

没有offer的一天

机器学习相关

概念

欠拟合 拟合 过拟合

训练集和测试集:模型在训练集和测试集都表现不好,...

bias+variance

bias: 模型刻画的分布(所有可能的训练数据集训出的所有模型的输出平均值(模型的期望))与真实分布的差距

variance: 不同训练集训练下模型输出值之间的差异

“偏差-方差分解”说明,泛化性能是由学习算法的能力、数据的充分性以及学习任务本身的难度所共同决定的。给定学习任务,为了取得好的泛化性能,则需使偏差较小,即能够充分拟合数据,并且使方差较小,即使得数据扰动产生的影响小。

欠拟合: bias high

过拟合: variance high

过拟合: 拟合了噪声和outlier

bagging and boosting

bagging: 多个分类器共同决定(完整的决策树), random forest(随机); low variance

boosting:low bias, adaboost(调整样本权重,e=错误率, \(\alpha_t = \frac{1}{2}ln(\frac{1-e}{e})\),权重变化 \(exp(-\alpha_th_t(x)y)\), \(sgn(\sum \alpha_t h_t(x))\));

GBDT: 拟合残差,将残差作为下一个学习器的样本的label,继续学习,有shriange收缩的思想; 往往是深度较小的树;不容易并行

k折交叉验证:

k较大,训练集的数据量较小,bias小,variance大

k较小是, variance 比较小, bias比较大

避免欠拟合:

- 更好的特征--与数据的分布相关的具有代表性的特征

- 更多的特征--增大输入向量的维度, 增加模型的复杂度

避免过拟合(降低 variance)

- 增大数据集

- 减少数据特征(降维,PCA)

- 正则化 L1,L2

- dropout(以一定的概率丢掉某些神经元)

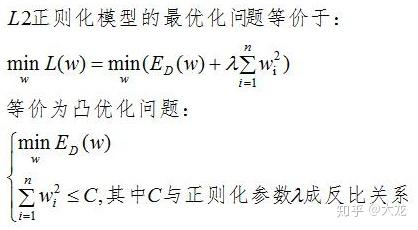

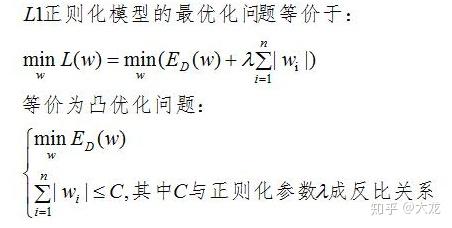

L1 和 L2 正则

- 增加约束

L1 正则容易是参数为0,即特征稀疏化;L2正则会是参数变小;都能降低variance

- 先验

L1先验是laplace分布,0附近更为集中

L2 则是0周围比较集中, gauss分布

logistic regression

分类算法,线性分类平面

sigmoid \(h_{\theta} = \frac{1}{1+e^{\theta^Tx+b}}\)(是正例的概率)

假设是伯努利分布,采用最大似然的方法,连乘

\(L_\theta(x) = \prod h_\theta(x)^{y_i}(1-h_\theta(x))^{1-y_i}\)

去\(ln\)后,就变成加的形式

所以我们需要最大化最大似然函数

郁之相关的是多分类问题的\(softmax\)函数,\(\frac{e^x}{e^x+e^y+e^z}\); 从\(softmax\)的角度来看,\(w\)可以看作\(w_1-w_0\)