【shell 工具 03】

一、工具

cut

在文件中负责剪切数据。cut命令从文件的每一行剪切字节、字符和字段并将这些字节、字符和字段输出。

2、基本用法

cut[选项参数] filename

说明:默认分隔符时制表符

3、选项参数说明

-f 列号,提取第几列

-d 分隔符、按照指定分隔符分隔列

举例1:

1)数据准备

[root@localhost data]# touch cut.txt

[root@localhost data]# vi cut.txt

hen

guan zhen

wo wo

lai lai

le le

2)切割出cut.txt第一列

[root@localhost data]# cut -d " " -f 1 cut.txt

hen

guan

wo

lai

le

-d " " 指:已空格为分隔符 -f 1 指:提取第一行

3)切割出cut.txt第二、三列

[root@localhost data]# cut -d " " -f 2,3 cut.txt

hen

zhen

wo

lai

le

提取多行时,用逗号分隔:-f 2,3

3)从cut.txt文件中切割出"hen"

[root@localhost data]# cat cut.txt |grep hen

hen

guan zhen

[root@localhost data]# cat cut.txt |grep hen|cut -d " " -f 1

hen

guan

[root@localhost data]# cat cut.txt |grep hen|cut -d " " -f 1|grep hen

hen

第一步:从cut.txt文件中查找包含“hen”字符的所有内容

第二步:从所查找到的内容中,已空格为分隔符,取第一列

第三部:从第二步中在继续查找包含“hen”的字段

举例2:

1)选取系统PATH变量值,第2个“:”开始后的所有路径

[root@localhost data]# echo $PATH /usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/root/bin [root@localhost data]# echo $PATH| cut -d : -f 3- /usr/sbin:/usr/bin:/root/bin [root@localhost data]# echo $PATH| cut -d : -f 3 /usr/sbin

注意:已“:”为分隔符,3- :加上“-”表示第三列以后所有的,不加“-”表示只取第三列

举例3:截取IP地址:

1)ifconfig查看截取

[root@localhost data]# ifconfig ens33: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500 inet 172.16.203.135 netmask 255.255.255.0 broadcast 172.16.203.255 inet6 fe80::6465:b9c5:2afe:d428 prefixlen 64 scopeid 0x20<link> ether 00:0c:29:f4:b0:94 txqueuelen 1000 (Ethernet) RX packets 2919 bytes 248522 (242.6 KiB) RX errors 0 dropped 0 overruns 0 frame 0 TX packets 1547 bytes 193218 (188.6 KiB) TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0 lo: flags=73<UP,LOOPBACK,RUNNING> mtu 65536 inet 127.0.0.1 netmask 255.0.0.0 inet6 ::1 prefixlen 128 scopeid 0x10<host> loop txqueuelen 1 (Local Loopback) RX packets 0 bytes 0 (0.0 B) RX errors 0 dropped 0 overruns 0 frame 0 TX packets 0 bytes 0 (0.0 B) TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

2)截取

[root@localhost data]# ifconfig -a|grep inet|grep -v inet6|grep -v "127.0"|awk '{print $2}'

172.16.203.135

grep inet:查找包含inet的选项

grep -v inet6:-v是过滤包含inet6的选项

grep -v "127.0":过滤包含127.0的选项

awk '{print$2}':通过awk打印,打印第二个内容

3)ip addr查看截取

[root@localhost data]# ip addr 1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN qlen 1 link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00 inet 127.0.0.1/8 scope host lo valid_lft forever preferred_lft forever inet6 ::1/128 scope host valid_lft forever preferred_lft forever 2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000 link/ether 00:0c:29:f4:b0:94 brd ff:ff:ff:ff:ff:ff inet 172.16.203.135/24 brd 172.16.203.255 scope global dynamic ens33 valid_lft 1372sec preferred_lft 1372sec inet6 fe80::6465:b9c5:2afe:d428/64 scope link valid_lft forever preferred_lft forever

4)截取

[root@localhost data]# ip addr|grep inet inet 127.0.0.1/8 scope host lo inet6 ::1/128 scope host inet 172.16.203.135/24 brd 172.16.203.255 scope global dynamic ens33 inet6 fe80::6465:b9c5:2afe:d428/64 scope link [root@localhost data]# ip addr|grep inet|grep -v inet6 inet 127.0.0.1/8 scope host lo inet 172.16.203.135/24 brd 172.16.203.255 scope global dynamic ens33 [root@localhost data]# ip addr|grep inet|grep -v inet6|grep -v "127.0" inet 172.16.203.135/24 brd 172.16.203.255 scope global dynamic ens33 [root@localhost data]# ip addr|grep inet|grep -v inet6|grep -v "127.0"|awk '{print$2}' 172.16.203.135/24 [root@localhost data]# ip addr|grep inet|grep -v inet6|grep -v "127.0"|awk '{print$2}'|cut -d / -f 1 172.16.203.135 [root@localhost data]#

sed

是一种流编辑器,它一次处理一行内容。处理时,把当前处理的行存储在临时缓冲区中,称为“模式空间”,接着用sed命令处理缓冲区中的内容,处理完成后,把缓冲区的内容送往屏幕。接着处理

下一行,这样不断重复,直到文件末尾。文件内容并没有改变,除非你使用重定向存储输出。

1、基本用法

sed [选项参数] ‘command’ filename

2、选项参数说明

-e 直接在指令列模式上进行sed的动作编辑 (执行单个命令的时候不需要)

3、命令功能描述

a 新增,a的后面可以接字串,在下一行出现

d 删除

s 查找并替换

举例1:

1)数据准备

[root@localhost data]# touch sed.txt

[root@localhost data]# vi sed.txt

dong shen

guan zhen

wo wo

lai lai

le le

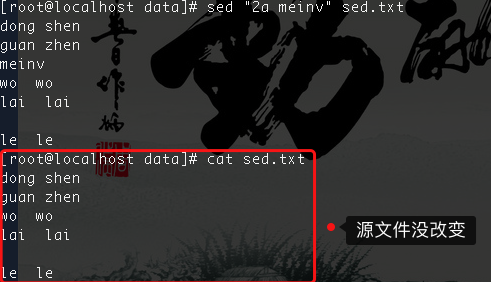

2)将“mei nv” 这个单词插入到sed.txt第二行下,打印

[root@localhost data]# sed "2a meinv" sed.txt

dong shen

guan zhen

meinv

wo wo

lai lai

le le

备注:sed "2a meinv" 指的是在第二行下新增"meinv",如果是在第三行下新增就写“3a”

源文件并没有改变,只是在显示屏上改变了

3)删除文件中所有包含“wo”的行

[root@localhost data]# sed "/wo/d" sed.txt

dong shen

guan zhen

lai lai

le le

4)将sed.txt文件中wo替换为ni

[root@localhost data]# sed "s/wo/ni/g" sed.txt

dong shen

guan zhen

ni ni

lai lai

le le

"s/wo/ni/g" 其中s是替换,wo/ni是把wo替换成ni,g是(global)全局替换的意思

5)将sed.txt文件中的第二行删除并将wo替换成ni

[root@localhost data]# sed -e '2d' -e 's/wo/ni/g' sed.txt

dong shen

ni ni

lai lai

le le

awk

一个强大的文本分析工具,把文件逐行的读入,以空格为默认分隔符将每行切片,切开的部分在进行分析处理

1、基本用法

awk[选项参数] ‘pattern1{action1} pattern2{action2}..’ filename

pattern1:表示awk在数据中查找的内容,就是匹配模式

action:在找到匹配内容时所执行的一系列命令

整体就是先按照pattern1匹配,然后按照action执行

2、选项参数说明

-F 指定输入文件拆分隔符

-v 赋值一个用户定义变量

举例1

1)数据准备

[root@localhost data]# cp /etc/passwd ./

复制后的passwd文件内容如下:

[root@localhost data]# cat passwd root:x:0:0:root:/root:/bin/bash bin:x:1:1:bin:/bin:/sbin/nologin daemon:x:2:2:daemon:/sbin:/sbin/nologin adm:x:3:4:adm:/var/adm:/sbin/nologin lp:x:4:7:lp:/var/spool/lpd:/sbin/nologin sync:x:5:0:sync:/sbin:/bin/sync shutdown:x:6:0:shutdown:/sbin:/sbin/shutdown halt:x:7:0:halt:/sbin:/sbin/halt mail:x:8:12:mail:/var/spool/mail:/sbin/nologin operator:x:11:0:operator:/root:/sbin/nologin games:x:12:100:games:/usr/games:/sbin/nologin ftp:x:14:50:FTP User:/var/ftp:/sbin/nologin nobody:x:99:99:Nobody:/:/sbin/nologin systemd-network:x:192:192:systemd Network Management:/:/sbin/nologin dbus:x:81:81:System message bus:/:/sbin/nologin polkitd:x:999:997:User for polkitd:/:/sbin/nologin postfix:x:89:89::/var/spool/postfix:/sbin/nologin sshd:x:74:74:Privilege-separated SSH:/var/empty/sshd:/sbin/nologin

2)搜索passwd文件以root关键字开头的所有行,并输出该行的第7列

[root@localhost data]# awk -F: '/^root/ {print $7}' passwd /bin/bash

备注:“-F:” 指的是以:切割;“^root” 指的是已root开头 其中“^”指的是开头 "$"指的是结尾

[root@localhost data]# awk -F: '/sync$/ {print $7}' passwd /bin/sync

3)搜索passwd文件以root关键字开头的所有行,并输出该行的第1列和第7列,中间以“,”号连接

[root@localhost data]# awk -F: '/^root/{print $1","$7}' passwd root,/bin/bash

[root@localhost data]# awk -F: '/^root/{print $1$7}' passwd

root/bin/bash

备注:如果{print $1$7}的$1$7中间没有内容,则输出的内容就没有连接符,$1","$7中间有","则输出的第一列和第七列已","号连接

4)只显示/etc/passwd的第一列和第七列,以逗号分隔,且在所有行前面添加列名user,shell在最后一行添加“daihai, /bin/zuishuai”.

[root@localhost data]# awk -F: 'BEGIN{print "user,shell"} {print $1","$7} END{print "daihai,/zuishuai"}' passwd

user,shell

root,/bin/bash

bin,/sbin/nologin

daemon,/sbin/nologin

adm,/sbin/nologin

lp,/sbin/nologin

sync,/bin/sync

shutdown,/sbin/shutdown

halt,/sbin/halt

mail,/sbin/nologin

operator,/sbin/nologin

games,/sbin/nologin

ftp,/sbin/nologin

nobody,/sbin/nologin

systemd-network,/sbin/nologin

dbus,/sbin/nologin

polkitd,/sbin/nologin

postfix,/sbin/nologin

sshd,/sbin/nologin

daihai,/zuishuai

注意:BEGIN 在所有数据读取行之前执行;END 在所有数据执行之后执行。

5)将passwd文件中的用户ID增加数值1并输出

[root@localhost data]# awk -v i=1 -F: '{print $3+i}' passwd

1

2

3

4

5

6

7

8

9

12

13

15

100

193

82

1000

90

75

备注:-v i=1 赋予一个变量i,值为1

6)循环读取csv文件,并已双引号进行分隔,输出第二列的内容并且已;结尾,并把截取的内容存储到一个新的文件内

for i in `ls *.csv` ; #已“进行分隔,输出第二列和分号,并存储到.log文件内 do cat $i | awk -F '"' '{ print $2 ";"}' > log_$dir_name.log done

3、awk的内置变量

|

变量 |

说明 |

|

FILENAME |

文件名 |

|

NR |

已读的记录数 (切割后,行的个数) |

|

NF |

浏览记录的域的个数(切割后,列的个数) |

举例1:

1)统计passwd文件名,每行的行号,每行的列数

[root@localhost data]# awk -F: '{print FILENAME "," NR "," NF}' passwd

passwd,1,7

passwd,2,7

passwd,3,7

passwd,4,7

passwd,5,7

passwd,6,7

passwd,7,7

passwd,8,7

passwd,9,7

passwd,10,7

passwd,11,7

passwd,12,7

passwd,13,7

passwd,14,7

passwd,15,7

passwd,16,7

passwd,17,7

passwd,18,7 --> 文件名:passwd 18行 7列

2)查询sed.txt中空行所在的行号

[root@localhost data]# awk '/^$/ {print NR}' sed.txt

5

sort

sort命令是将文件进行排序,并将排序结果标准输出

1、基本语法

sort(选项)(参数)

|

选项 |

说明 |

|

-n |

依照数值的大小排序 |

|

-r |

以相反的顺序来排序 |

|

-t |

设置排序时所用的分隔字符 |

|

-k |

指定需要排序的列 |

举例:

1)按照“:”分隔后的第三列倒序排序

[root@localhost data]# sort -t : -nrk 2 sort.sh xz:50:2.3 bb:40:5.4 ss:30:1.6 bd:20:4.2 cls:10:3.5 #!/bin/bash

备注:“-t :” 以:进行分隔,“-nrk” n以数字排序,r倒序,k指定第二列排序

split

可以将一个大文件分割成很多个小文件

选项 -b:值为每一输出档案的大小,单位为 byte。 -C:每一输出档中,单行的最大 byte 数。 -d:使用数字作为后缀。 -l:值为每一输出档的列数大小。

#案例:把date.file文件按照10k进行分隔,分隔后新的文件命名规则为split_file并且后缀已数字结尾,长度为3

[root@localhost split]# split -b 10k date.file -d -a 3 split_file

[root@localhost split]# ls

date.file split_file000 split_file001 split_file002 split_file003 split_file004 split_file005 split_file006 split_file007 split_file008 split_file009

#案例:把把log_$dir_name.log按照100000行进行分割,分隔后新的文件命名规则为log_$dir_name并且后缀已数字结尾,长度为4

# 把log_$dir_name.log按照100000行进行分割,分隔后的文件已数字结尾(-d参数控制),同时可以使用-a length来指定后缀的长度(-a 4长度为4)

split -100000 log_$dir_name.log -d -a 4 log_$dir_name.log

二、真实题

1、使用linux命令查询files中空行所在的行号 --->比如:从数据库中导出数据,然后数据中间有空格/null等,这时候就可以用这条命令来处理

awk '/^$/ {print NR}' sed.txt

2、使用linux命令计算第二列的和并输出

sum.txt文件内容如下:

张三 40

李四 50

王五 60

cat sum.txt |awk -F" " '{sum+=$2} END {print sum}'

150