[机器学习实战] 决策树ID3算法

1. 决策树特点:

1)优点:计算复杂度不高,输出结果易于理解,对中间值的缺失不敏感,可以处理不相关特征数据。

2)缺点:可能会产生过度匹配问题。

3)适用数据类型:数值型和标称型。

2. 一般流程:

1)收集数据:可以使用任何方法;

2)准备数据:构造树算法只适用于标称型数据,因此数值型数据必须离散化;

3)分析数据:可以使用任何方法,构造树完成后,我们应该坚持图形是否符合预期;

4)训练算法:构造树的数据结构;

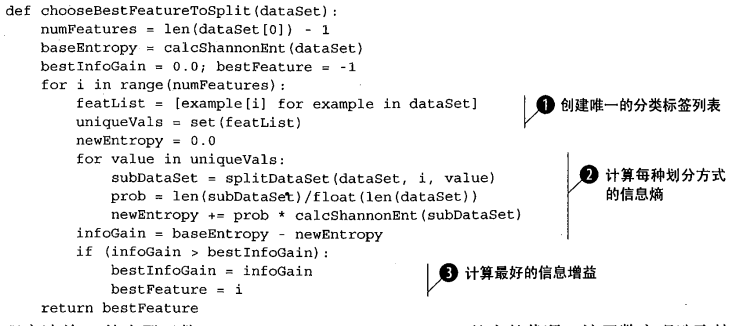

a. 在划分数据集之前之后信息发生的变化称为信息增益。

熵定义为信息的期望值,可用于分类,计算公式:

H = -Σ ni=1 p(xi)log2p(xi)

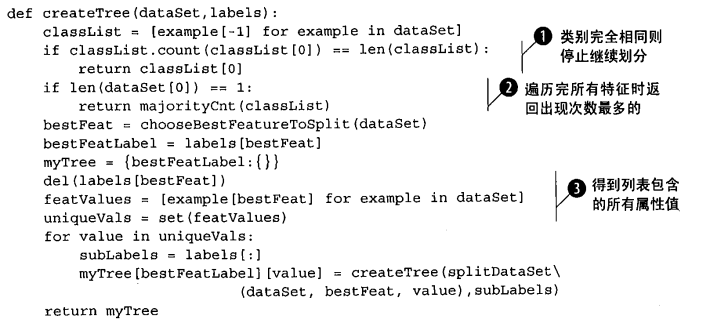

b. 创建决策树原理:

得到原始数据集,然后基于最好的属性值划分数据集,由于特征值可能多于两个,因此可能存在大于两个分支的数据集划分。

第一次划分之后,数据将被向下传递到树分支的下一个节点,在这个节点上,我们再次划分数据。

决策树存储方法:

5)测试算法:使用经验树计算错误率;

6)使用算法:此步骤可以适用于任何监督学习算法,而使用决策树可以更好地理解数据的内在含义。

3. 应用:

预测隐形眼镜类型;

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】博客园携手 AI 驱动开发工具商 Chat2DB 推出联合终身会员

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步