https://www.cnblogs.com/wj-1314/p/9754072.html

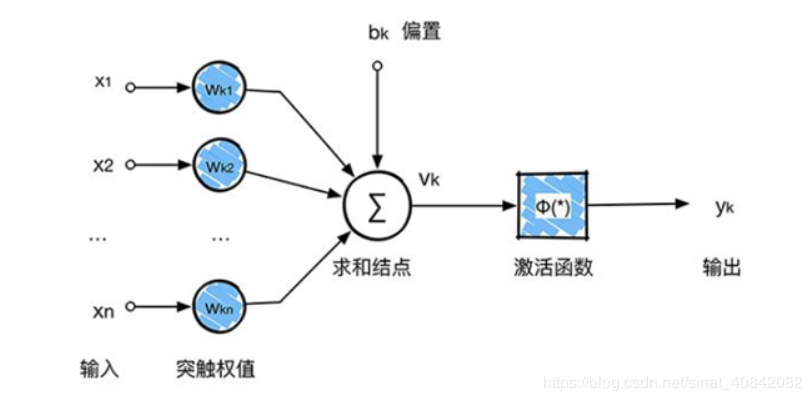

激活函数:常用的激活函数有sigmoid、tanh、relu等等,前两者sigmoid/tanh比较常见于全连接层,后者ReLU常见于卷积层

在卷积神经网络中,激活函数一般用ReLU(The Rectified Linear Unit,修正线性单元)

收敛快,求梯度简单。

计max(0,T),就是如果这个数是正的就原样输出,如果这个数是负数,就输出0

深度神经网络:

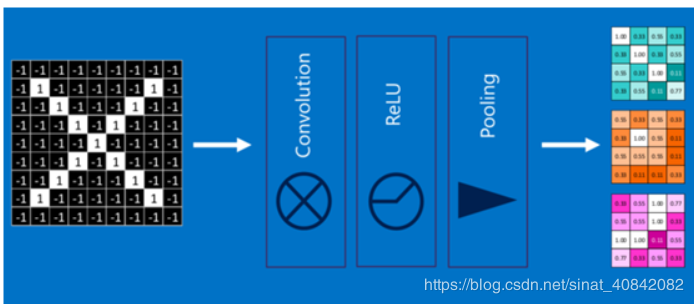

卷积、激活函数、池化组合在一起,是下面这样:

然后多经过几次这个过程就是深度神经网络

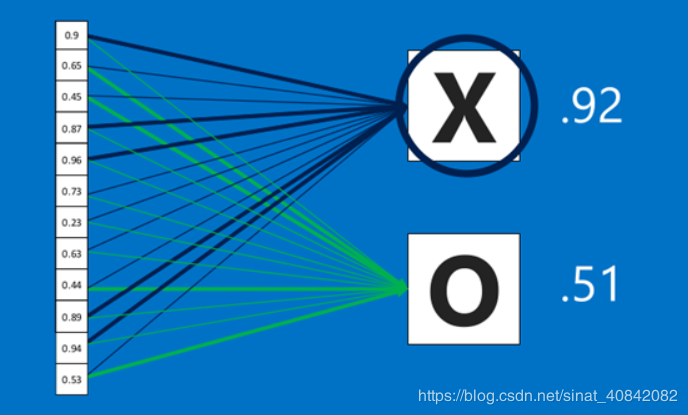

全连接层(Fully connected layers):

全连接层在整个卷积神经网络中是个分类器,在通过卷积、激活函数、池化等深度网络后,再经过全连接层对结果进行识别分类。

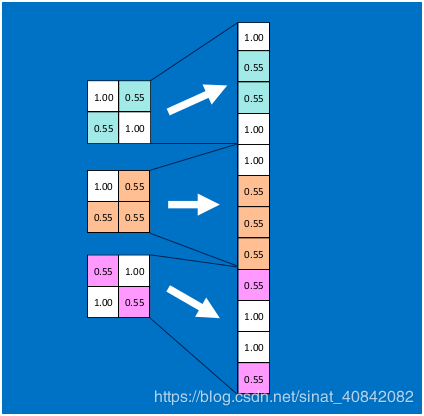

首先将经过卷积、激活函数、池化的深度网络后的结果串起来,如下图所示:

在利用该模型进行结果识别时,根据刚才提到的模型训练得出来的权重,以及经过前面的卷积、激活函数、池化等深度网络计算出来的结果,进行加权求和,得到各个结果的预测值,然后取值最大的作为识别的结果(如下图,最后计算出来字母X的识别值为0.92,字母O的识别值为0.51,则结果判定为X)

卷积神经网络主要由两部分组成,一部分是特征提取(卷积、激活函数、池化),另一部分是分类识别(全连接层),下图便是著名的手写文字识别卷积神经网络结构图: