AotucCrawler 快速爬取图片

2021-11-25 22:33 虫师 阅读(1757) 评论(2) 编辑 收藏 举报AotucCrawler 快速爬取图片

今天介绍一款自动化爬取图片项目。

GitHub: https://github.com/YoongiKim/AutoCrawler

Google, Naver multiprocess image web crawler (Selenium)

关键字

- 爬虫网站:Google、Naver (美、韩两大搜索引擎)

- 运行方式:Multiprocess(多进程)

- 爬取格式:image (图片)

- 基于自动化工具:Selenium (不解释)

如何使用

-

Git克隆

AutoCrawler项目到本地 -

自行安装

Chrome浏览器 -

安装依赖

> pip -r requirements.txt

certifi: 包含了很多可信任知名公司的证书/公钥。chardet:提供自动检测字符编码的功能。idna: 提供"对于RFC5891中定义的IDNA协议(Internationalised Domain Names in Applications)的支持"。requests: 依赖于上面三个基础库,他主要用于根据图片链接下载图片。selenium: 用于启动浏览器,爬取图片链接。webdriver-manager: 用来管理selenium浏览器驱动的项目。

仔细分析别人项目,不管是源码还是依赖库都会有收获。

webdriver-manager就是我发现的一个宝藏项目,它简化的浏览器驱动的管理。

- 打开

keywords.txt文件,编写爬取的关键字。

cat

dog

- 运行

main.py文件

> python main.py

参数说明:

--skip true:如果下载的关键字已经存在,是否跳过关键字,重新下载时需要设置。

--threads 4: 下载使用线程数量

--google true: 从google.com 下载。

--naver true: 从naver.com 下载。

--full false: 下载全分辨率图像而不是缩略图 (慢)。

--face false: Face search mode。

--no_gui auto: 使用 GUI 模式. (headless模式) 全分辨率模式可以加速, 但是缩略图模式不稳定。 默认auto模式,如果full=false 默认使用使用GUI,如果full=true默认Headless模式。(可用于docker linux系统)。

--limit 0: 设置最大图片下载范围。 (0: 无限制)

--proxy-list: 逗号分隔的代理列表,如: socks://127.0.0.1:1080, http://127.0.0.1:1081,每个线程从列表中随即选择一个。

例如:

> python main.py --threads 2 --google true --naver false --full false --limit 50

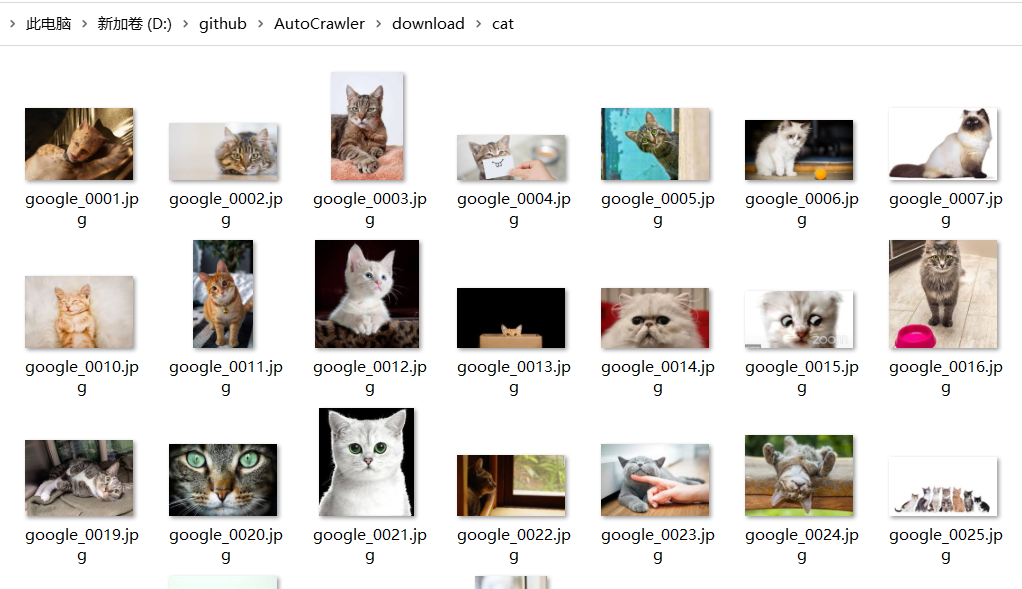

- 爬取的图片保存于

downloads/目录。

小结

-

因为使用的是Google网站,没有梯子的同学有点郁闷。项目本身并不复杂,两个python文件加一起不到1000行代码,我们完全可以花点时间替换为国内可访问的搜索引擎。

-

下载图片只是为了欣赏猫猫狗狗吗?当然不是,我们可用下载的图片训练 AI。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· AI与.NET技术实操系列(二):开始使用ML.NET

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报

· Manus爆火,是硬核还是营销?

· 终于写完轮子一部分:tcp代理 了,记录一下

· 【杭电多校比赛记录】2025“钉耙编程”中国大学生算法设计春季联赛(1)

2012-11-25 Apache中KeepAlive 配置