04-Elasticsearch-ES集成IK分词器

分词器

分词器汇总

|

分词器 |

拆分方式 |

|

standard |

空格 |

|

simple |

非字母 |

|

whitespace |

空格 |

|

stop |

去除英文的助词(a the is) |

|

keyword |

不拆分(关键词) |

|

ik_max_word |

最大词汇拆分 |

|

ik_smart |

最小词汇拆分 |

默认分词器

POST /_analyze { "analyzer": "standard", "text": ["I study in imooc.com!"] }

默认分词器, 英文按照空格拆分, 中文直接拆成单个汉字, 大写自动转小写

在指定索引中分析指定字段

POST /my_doc/_analyze { "analyzer": "standard", "field": "desc", "text": ["study in imooc"] }

ES集成IK

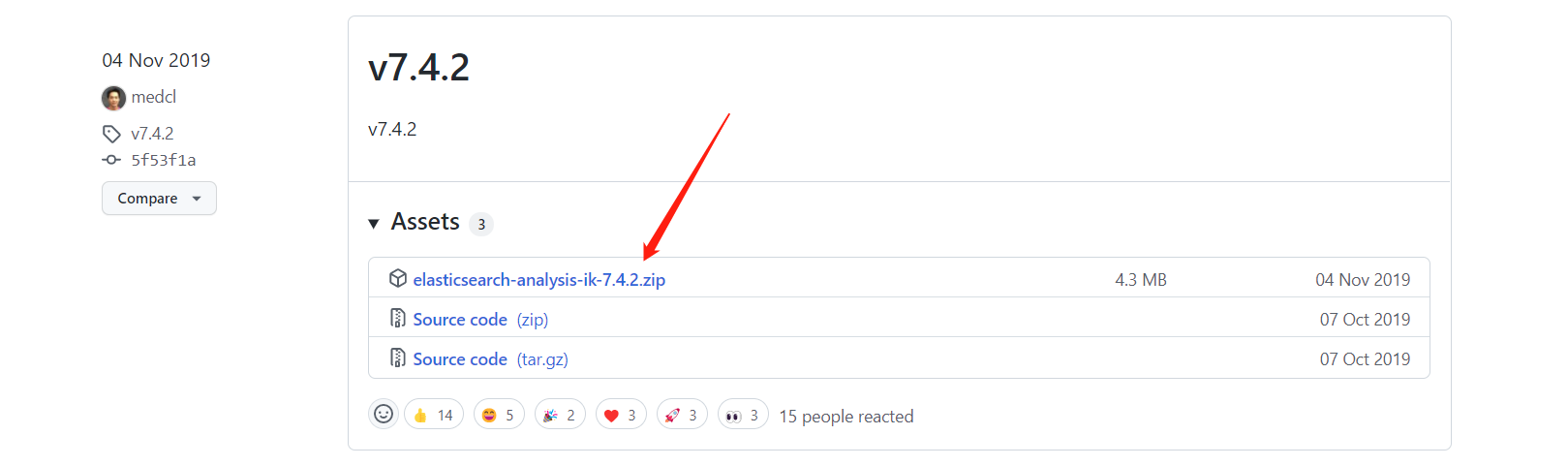

下载

https://github.com/medcl/elasticsearch-analysis-ik/releases?page=7

安装

上传到Linux

# 解压到插件库下

unzip elasticsearch-analysis-ik-7.4.2.zip -d /usr/local/es/plugins/ik

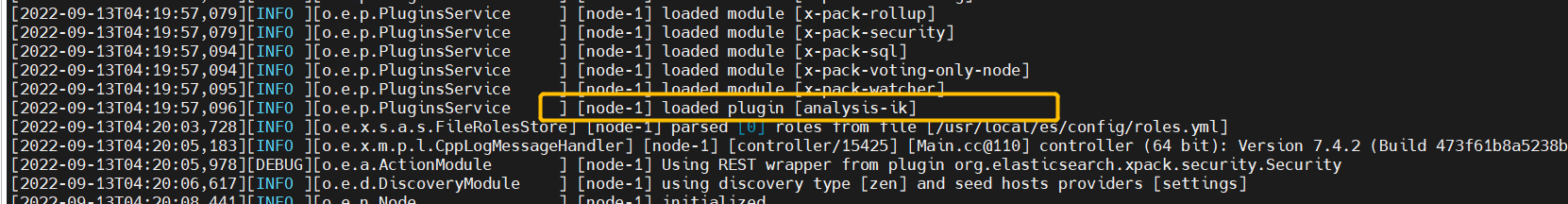

重启es

ik集成完成

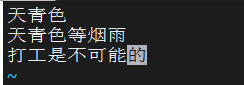

配置自定义字库

修改ik/config/IKAnalyzer.cfg.xml

vi IKAnalyzer.cfg.xml

vi cust.dic

再次执行分词

okk

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· Docker 太简单,K8s 太复杂?w7panel 让容器管理更轻松!