用requests库的get()函数访问搜狗网站20次,打印返回状态,text()内容,计算text()属性和content属性所返回网页内容的长度。

调用request库的get()方法可以进行网页的获取

调用bs4库的BeautifulSoup可以从网页抓取信息

下面是案例:

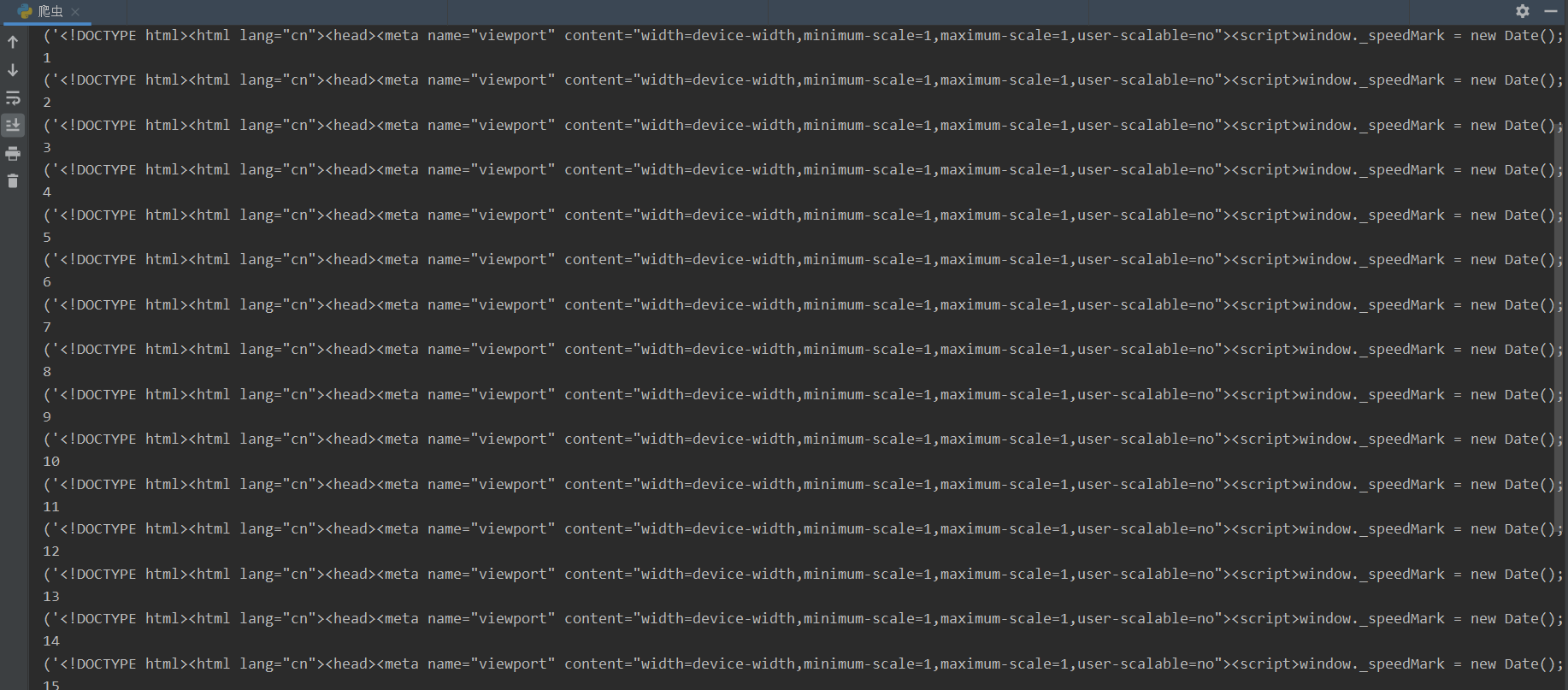

用requests库的get()函数访问搜狗网站20次,打印返回状态,text()内容,计算text()属性和content属性所返回网页内容的长度。

# 导入库 import requests from bs4 import BeautifulSoup def getUrlText(url): try: web = requests.get(url) soup = BeautifulSoup(web.text) web.raise_for_status() # 查看网页的状态 web.encoding = 'utf-8' # 设置编码 return web.text, web.status_code, len(web.text), web.encoding, len(soup.text) except: return url = "https://www.sogou.com" for i in range(20): print(i) print(getUrlText(url))

浙公网安备 33010602011771号

浙公网安备 33010602011771号