中文词频统计

import jieba f=open('novel.txt','r',encoding='utf-8') content=f.read() f.close() symbol='''。,“”!?\n();''' for i in symbol: content=content.replace(i,' ') # 使用jieba进行中文分词 contentList=list(jieba.cut(content)) # 生成词频统计 contentDict={} for i in contentList: contentDict[i]=contentList.count(i) # 排除语法型词汇,代词、冠词、连词 exclude={' ','的','她','是','了','—','他','在','说','我','你','不','都','也', '和','有','着','就'} for i in exclude: del contentDict[i] # 排序 contentDict=sorted(contentDict.items(),key=lambda e:e[1],reverse=True) # 输出词频最大TOP20 for i in range(20): print(contentDict[i])

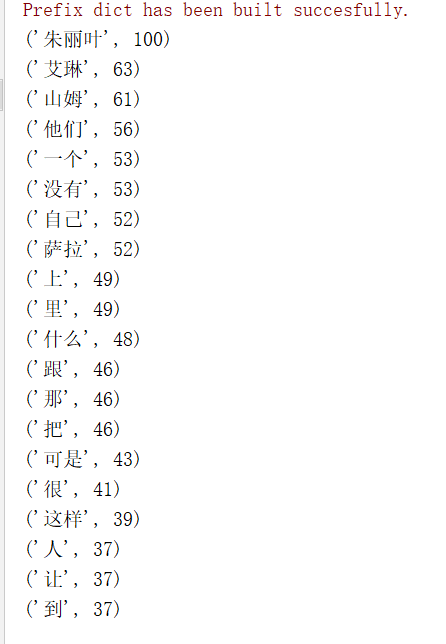

运行结果:

浙公网安备 33010602011771号

浙公网安备 33010602011771号