概率图:HMM:decoding问题(Viterbi算法)及HMM小结

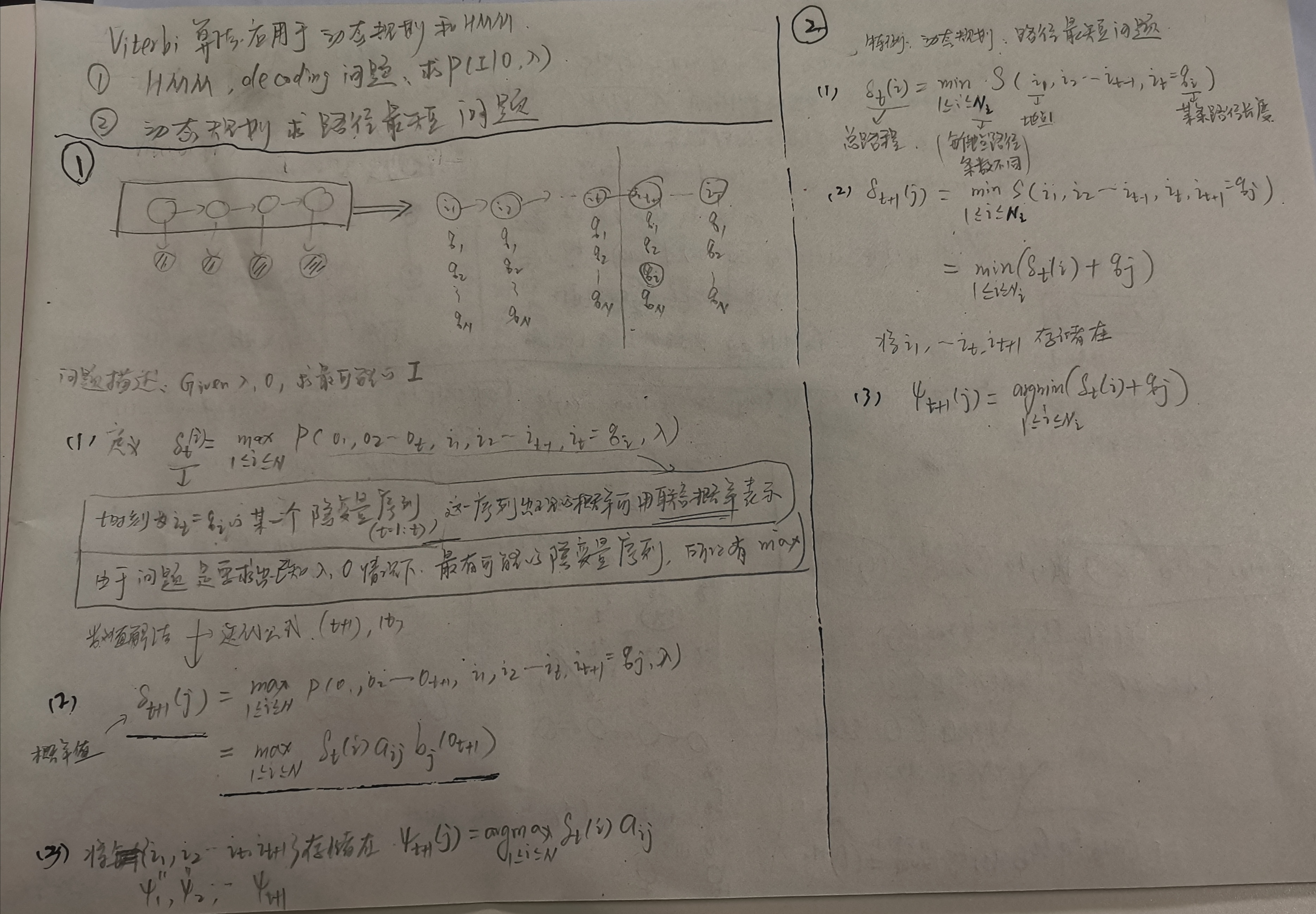

Viterbi算法用于解决HMM的decoding问题和用动态规划求解最短路径的共通点【个人理解】

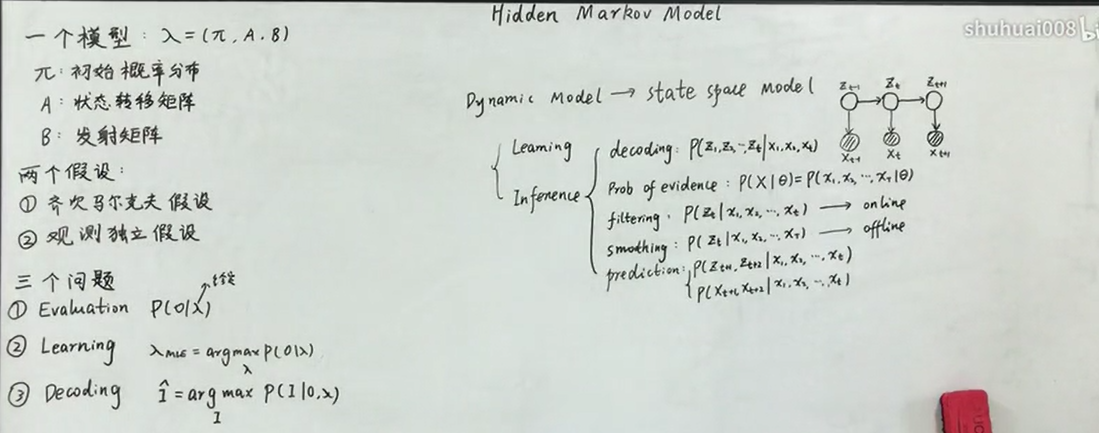

HMM小结:

(来源:B站up主:shuhuai008,板书)

注意:

①likelihood=probability of evidence :都可以表示似然。

②Inference包括求后验(decoding)、求似然(prob of evidence),滤波(filtering),平滑(smoothing),预测(prediction)问题。

备注:最大似然估计可以理解为”最大“(argmax)”似然“(P(O|λ))”估计“(λ:参数估计)。

filtering(online);smoothing(offline);predicting(online?)

③prediction问题可以求t+1,t+2,....的未来时刻的状态变量。

④【个人理解】HMM模型属于动态模型(Dynamic Model),“动态”是从时间角度解读的动态。动态模型也叫做状态空间模型(state space model),可以从模型的变量角度解读“状态空间”,因为模型中的变量为状态变量,有隐状态,有观测变量,并且这些变量有若干个,由此形成了状态空间模型。在这个状态空间中,各个状态{x1,x2,...xN,z1,z2,...zN}两两之间具有关联性(可能是时间角度的关联性(比如HMM的it+1与it之间有aij关系;bt与it之间有bj(k)关系)),状态变量之间并不满足独立同分布(iid)。【在这个状态空间中一个状态变量是一个维度,这个和特征空间可以做区分】

⑤【个人理解】统计机器学习中,特征空间的若干个维度是特征,每个样本xi是特征空间中的一个点。

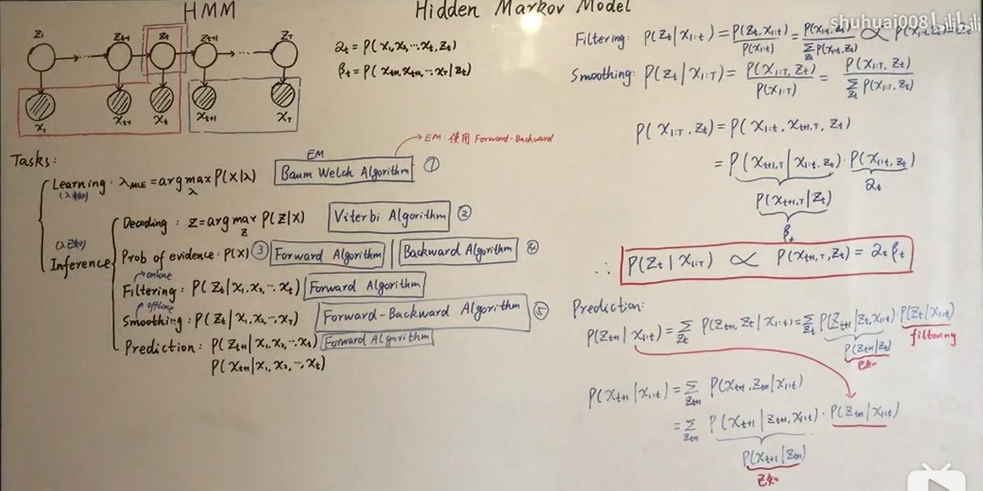

HMM相关算法小结:

( 来源:B站up主:shuhuai008,板书)

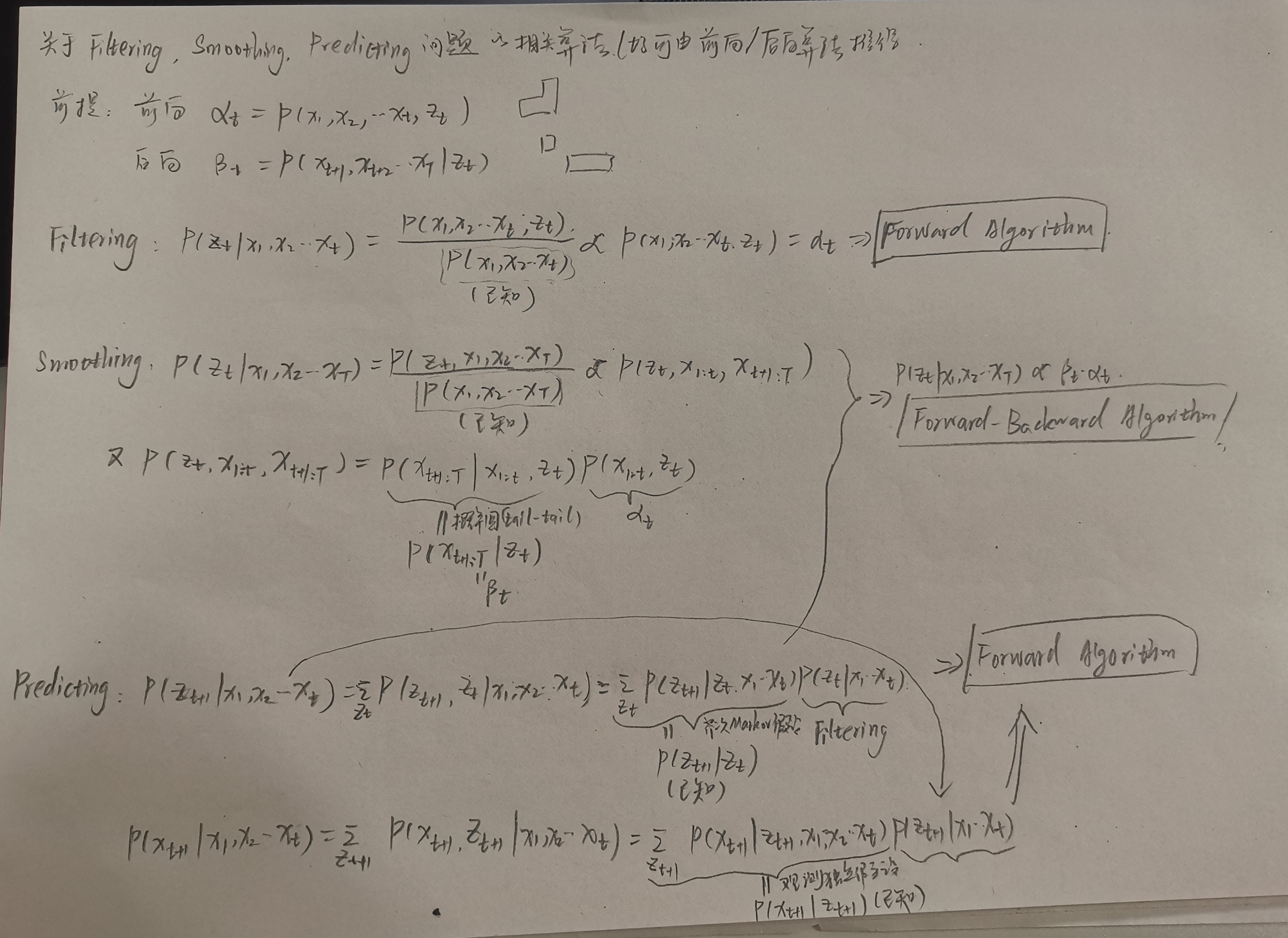

公式推导

浙公网安备 33010602011771号

浙公网安备 33010602011771号