Spark环境搭建

Windows下Spark环境搭建

环境准备:

- JDK环境配置

- Scala环境配置

- Spark环境配置

- Hadoop环境配置

各个软件的版本:

- JDK1.8

- Scala2.11.8

- Spark 2.2.0

- Hadoop 2.6.0

Java环境配置

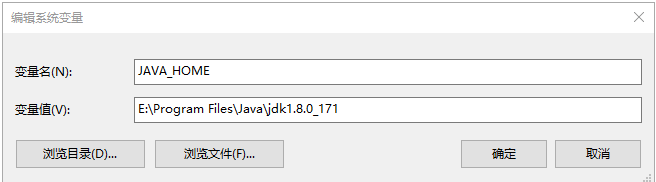

去JDK官网下载JDK1.8,然后配置JAVA_HOME和PATH。

JAVA_HOME:

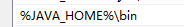

PATH:

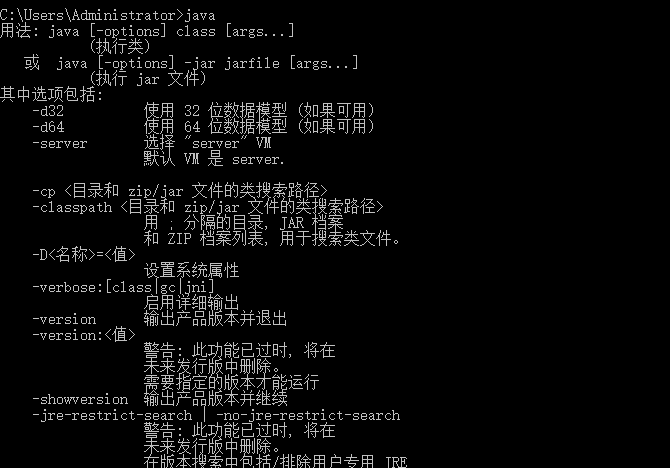

测试:

Scala环境配置

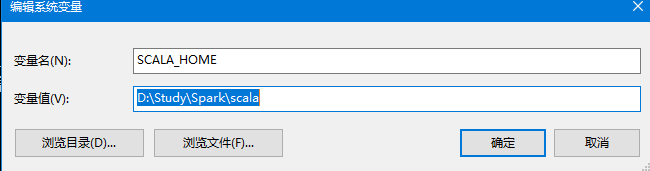

去官网下载Scala,不过官网都是最新版本,可以选择旧版下载,下载完成后进行安装,和JAVA一样配置环境变量

SCALA_HOME:

SCALA_PATH:

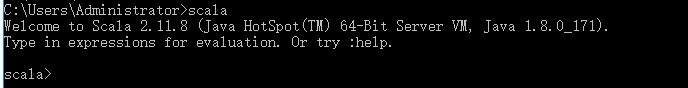

SCALA_TEST:

Spark环境配置

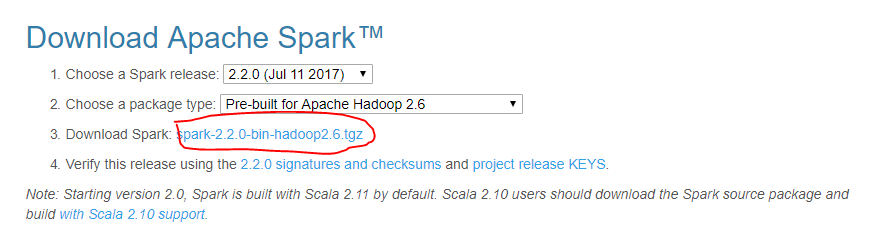

去官网下载Spark,要选择对应的版本

然后解压到一个指定的目录,和上面的一样创建SPARK_HOME和配置path环境变量,接着测试一下

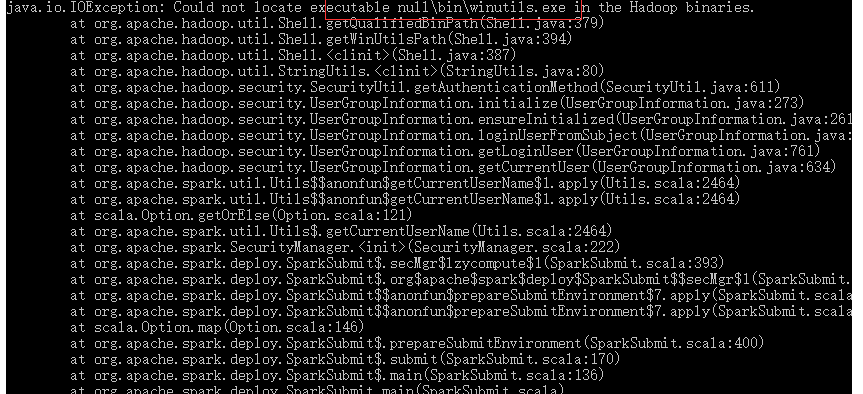

因为我配置好了Hadoop,所以Spark看起来没有错,如果没有配置Hadoop,会出现如下错误:

Hadoop环境配置

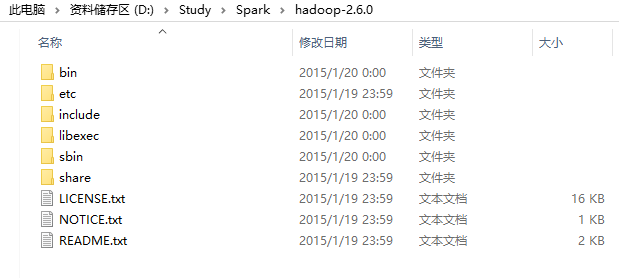

去CDH5找到hadoop-2.6.0-cdh5.9.3解压到特定的文件夹,然后配种HADOOP_HOME,解压后的目录如下

接着需要下载winutils,下载后吧Hadoop的bin目录里的文件已换成winutils的bin目录里的文件,这样整个环境就搭建成功了

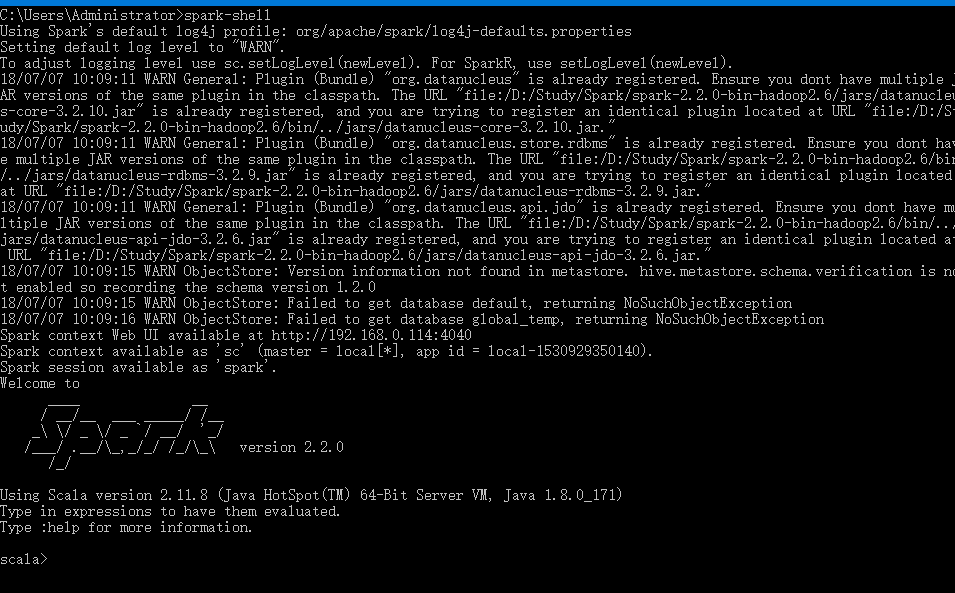

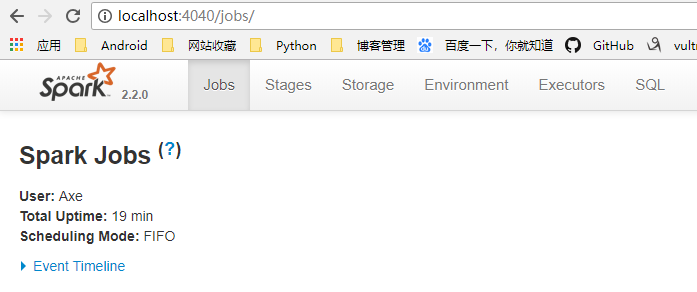

Spark环境测试

在终端执行spark-shell命令,然后访问网址localhost:4040,出现如下画面就算成功了,我们就可以进行Spark编程了。

浙公网安备 33010602011771号

浙公网安备 33010602011771号