logistic regression recap

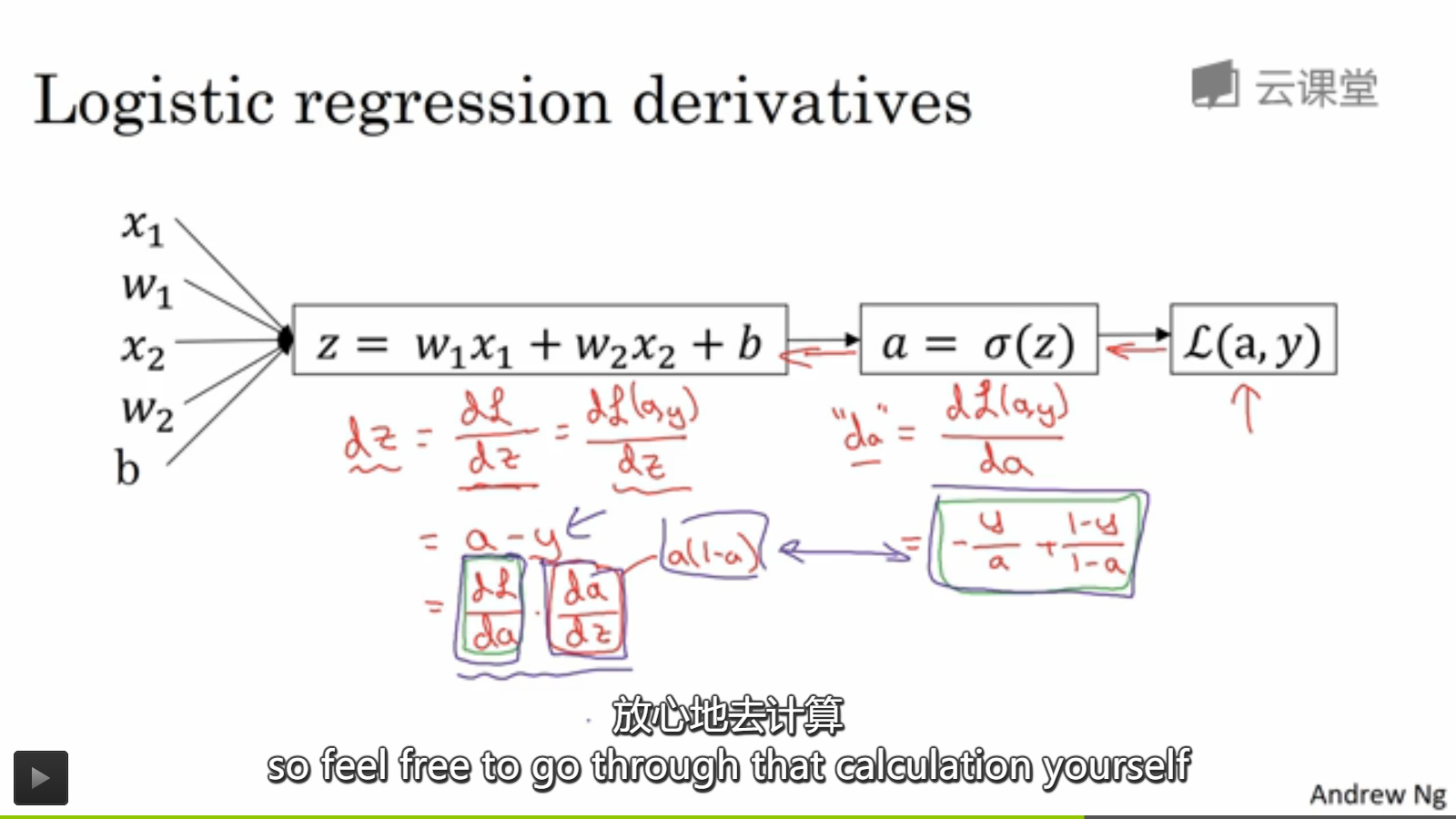

dz=dL/dz=dL/da*da/dz-----》链式法则求导,求微分

da=dL/da=-y/a+(1-y)/(1-a)=(a-y)/a*(1-a)---->求导公式

dw1=dl/dz*dz/dw1=(a-y)*

dJ/dw1=1/m(训练集中求和dw1 )---->训练集求和的平均值作为cost 函数的dw1来使用,update w1的值。

dw1 = dL/dw1=(dL/dz)*(dz/dw1)

由于这其中 吴恩达使用dz=dl/dz所以dw1=dz/dw1*dz=x1*dz---->z=w1*x1+w2*x2+b如上图;

dJ/dw1=1/m(sum of dL/dw1)---->用这个来更新w:=w-a*dw1----》a为学习率

更新b----》J(w,b)的值,最后求到最小的J对应的(w,b)因为为凸的所以是有唯一的最优解的。

没有任何一个梦想是傻逼的

posted on 2017-09-02 22:57 flyingwaters 阅读(323) 评论(0) 编辑 收藏 举报