大三寒假学习 spark学习 spark集群环境搭建

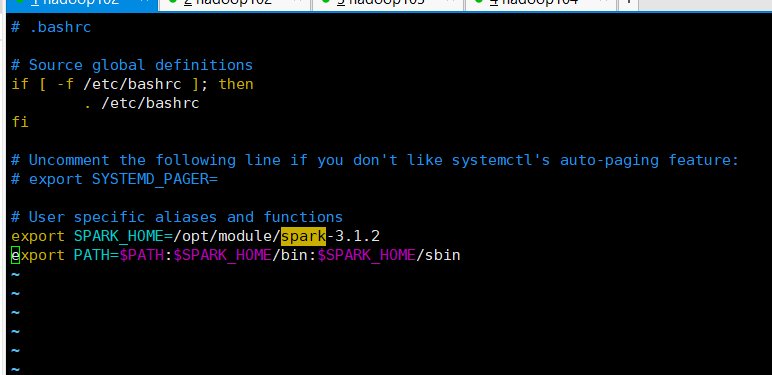

配置环境变量:

在master节点的终端中执行:vim ~/.bashrc

添加如下配置:export SPARK_HOME=/opt/module/spark-3.1.2 export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

运行source命令使配置立即生效:source ~/.bashrc

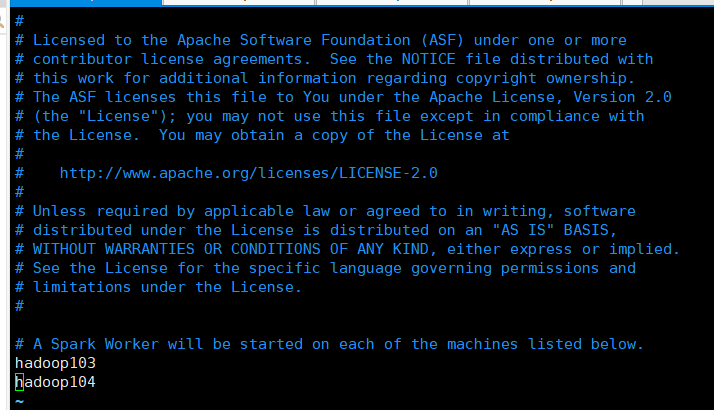

配置workers文件:

编辑workers文件将localhost替换为节点主机名,一个主机名占一行

配置spark-env.sh文件:

添加如下内容:

最后一个为master的ip,前两个要替换为你自己的本地路径

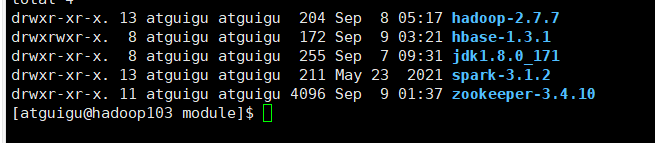

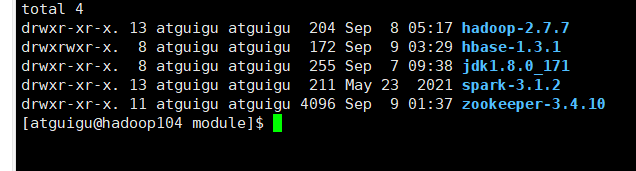

分发spark文件到各个节点:

利用了之前写好的脚本xsync分发,https://www.bilibili.com/video/BV1Qp4y1n7EN?p=28里面有脚本的编写详情

启动并关闭集群:

spark集群:

启动:

1.hadoop集群:start-all.sh

2.启动master节点 sbin/start-master.sh

3.启动slave节点: sbin/start-slaver.sh

关闭:

在spark文件下

1.关闭master节点 sbin/stop-master.sh

2.关闭worker节点 sbin/stop-slaves.sh

3.关闭hadoop集群 stop-all.sh

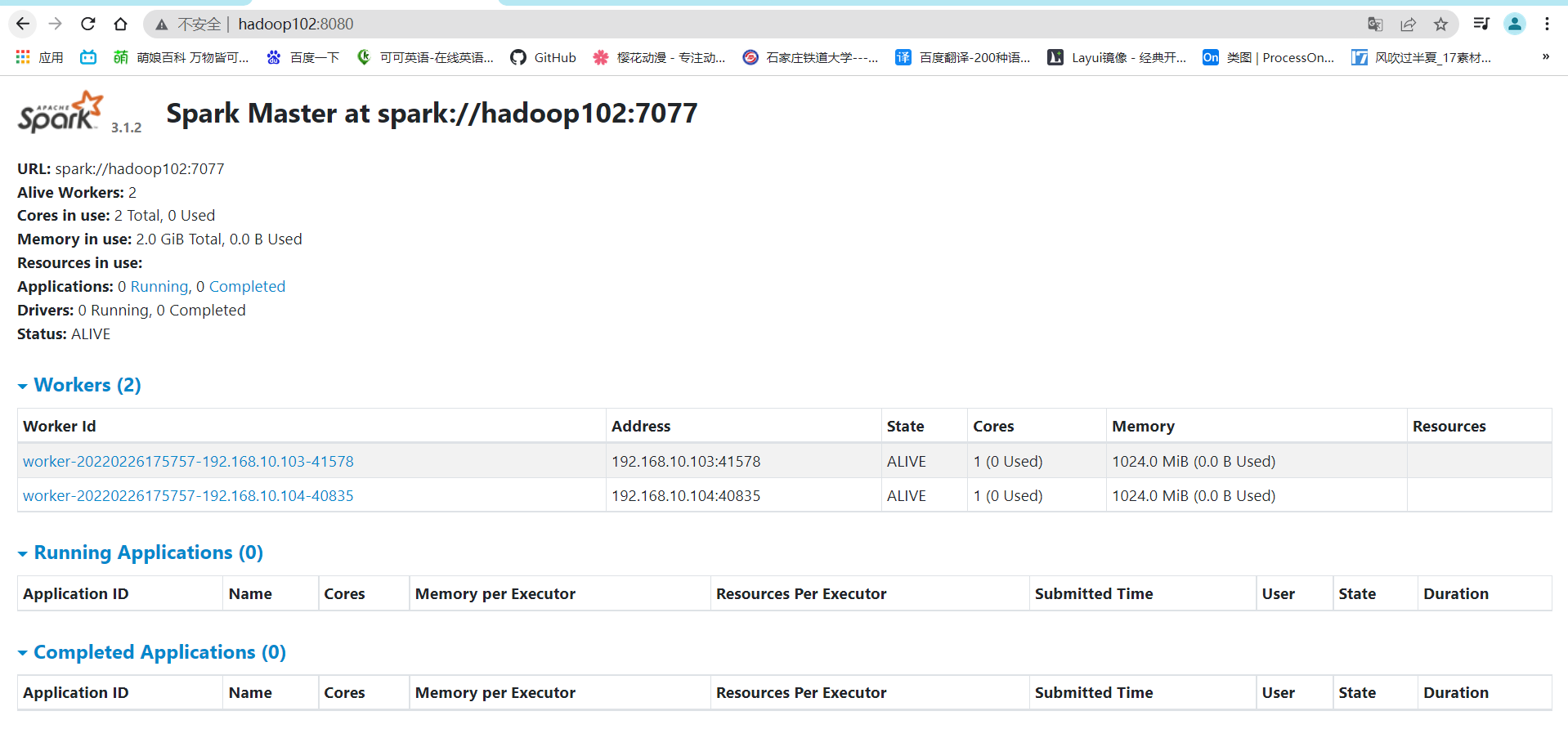

启动后在网址输入http://hadoop102:8080会出现如下界面证明成功: