大三寒假学习 spark学习 spark安装

1.下载安装文件:

Spark安装包下载地址: http://spark.apache.org

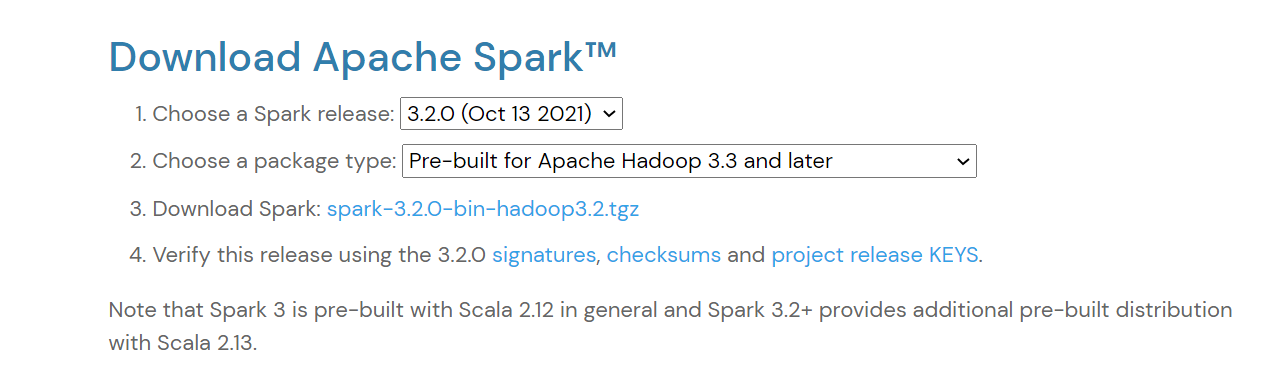

进入下载页面后,点击主页右侧的“Download Spark”按钮进入下载页面,下载页面中提供了几个下载选项,主要是Spark release及Package type的选择,如下图所示。第1项Spark release一般默认选择最新的发行版本,第2项package type则选择“Pre-build with user-provided Hadoop [can use with most Hadoop distributions]”,可适用于多数Hadoop版本。选择好之后,再点击第3项给出的链接就可以下载Spark了。

2.传到虚拟机并解压缩:

打开虚拟机使用xshell远程连接结果发现hadoop104虚拟机连接不上。

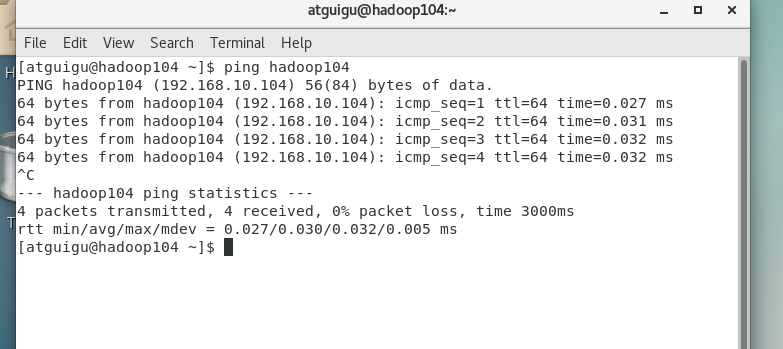

在hadoop104本机上ping hadoop104 结果发现能ping通

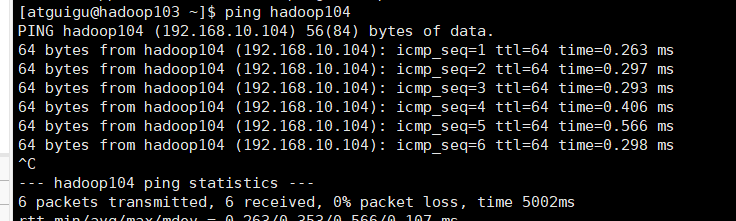

在其他虚拟机上ping 发现也可以ping通

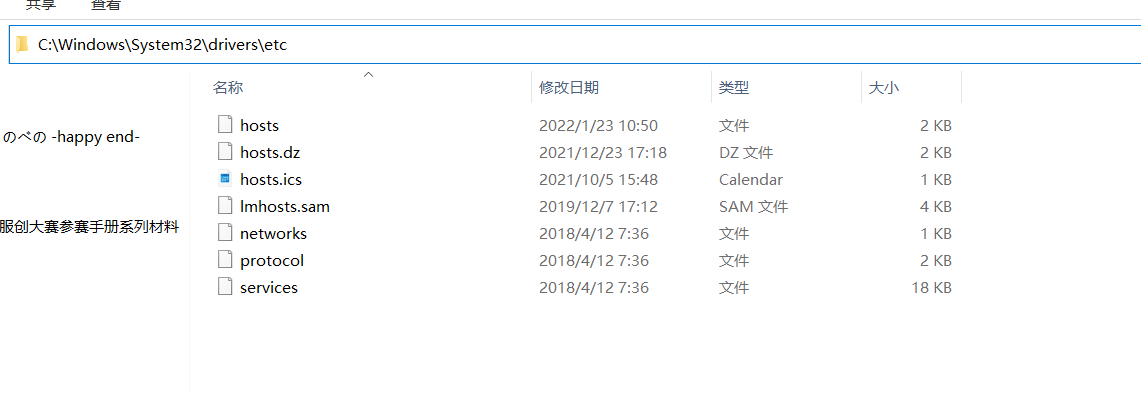

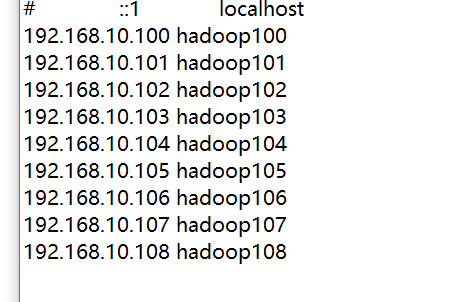

所以猜测是windows的host文件被修改了

找到host文件并修改

发现下面的host不知为何被注释了,解除注释即可

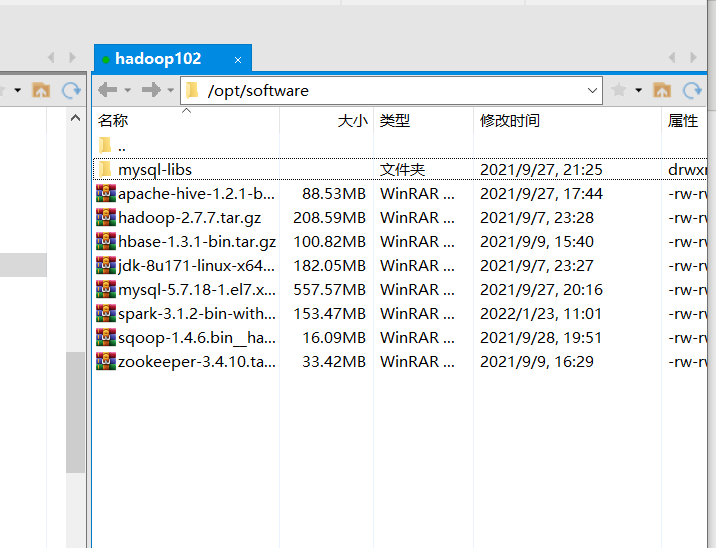

上传到虚拟机利用xftp

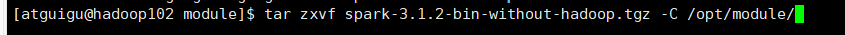

解压缩到指定文件夹,这里要解压到指定文件夹下,命令如下:tar zxvf test.tgz -C 指定目录

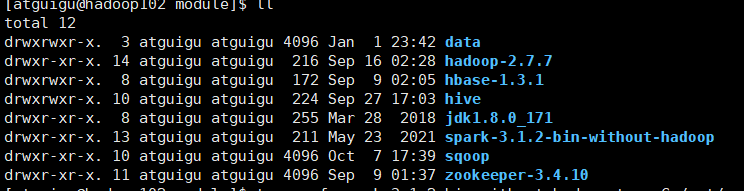

查看module目录,发现解压成功

3.配置Classspath:

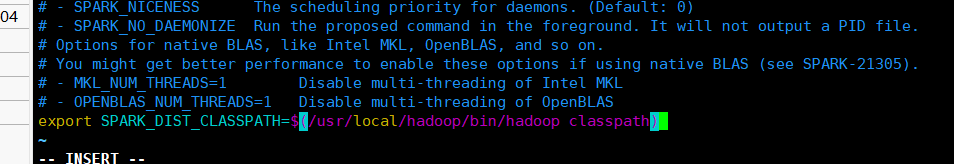

进入到spark文件中,在进入conf,编辑spark-env.sh.template,在末尾添加:export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath)

注意这里的hadoop地址一定要正确/hadoop classpath不用修改,但是handoop的bin目录地址要写你自己机子上的地址

然后将配置文件拷贝:cp ./conf/spark-env.sh.template ./conf/spark-env.sh #拷贝配置文件

4.启动spark:

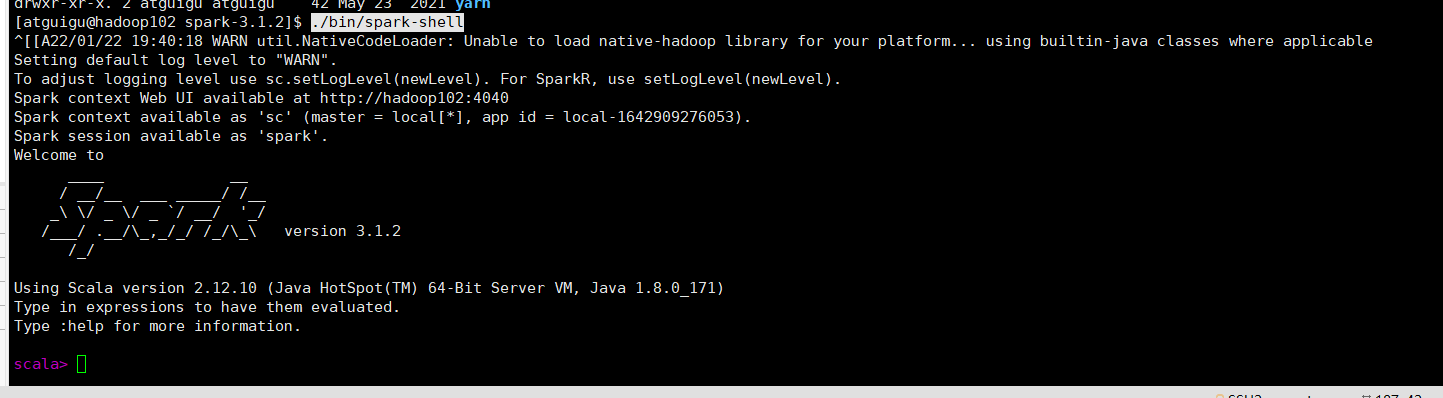

./bin/spark-shell

启动成功