Spark RDD编程

1.

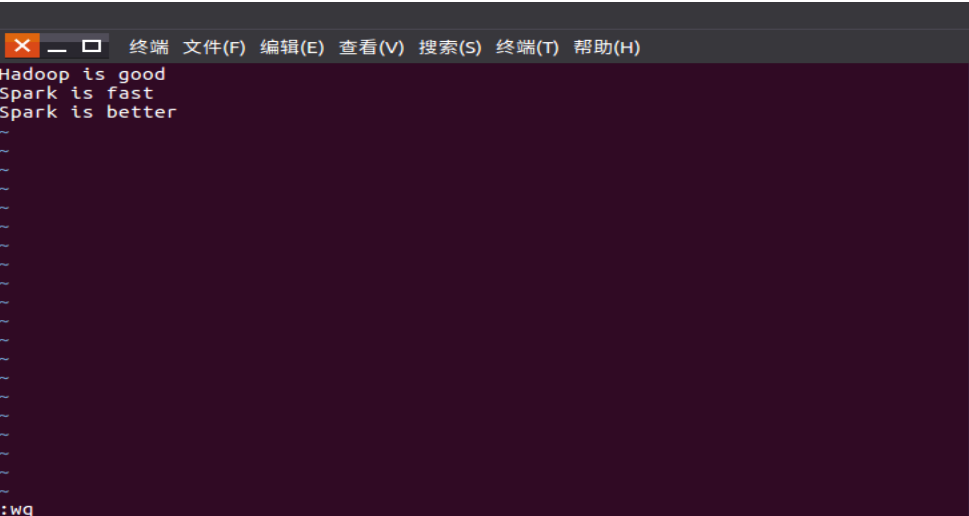

准备文本文件

vim /usr/local/spark/mycode/rdd/word.txt

从文件创建RDD lines=sc.textFile()

筛选出含某个单词的行 lines.filter()

lambda 参数:条件表达式

2.

生成单词的列表

从列表创建RDD words=sc.parallelize()

筛选出长度大于2 的单词 words.filter()

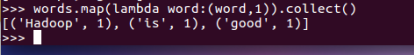

3.

筛选出的单词RDD,映射为(单词,1)键值对。 words.map()

*建议文本或单词中出现自己的学号或名字作标记。

浙公网安备 33010602011771号

浙公网安备 33010602011771号