【淘汰9成NLP面试者的高频面题】LSTM中的tanh和sigmoid分别用在什么地方?为什么?

【淘汰9成NLP面试者的高频面题】LSTM中的tanh和sigmoid分别用在什么地方?为什么?

重要性:★★★ 💯

本题主要考察面试者对以下问题的理解:

- ① 数据特征和模型权重的区别

- ② 门控机制的软性特征筛选特点

这是我常用的一个面试题。看似简单的基础题,但在面试中能准确回答的不足10% ,常识题的错误反而会让人印象深刻。

【NLP 大模型百面百过】系列文章:

- 【淘汰9成NLP工程师的常识题】BPE 分词器是如何训练的?

- 【淘汰9成NLP工程师的常识题】LSTM 如何缓解 RNN 梯度消失的问题?

- 【淘汰9成NLP工程师的常识题】LSTM的前向计算如何进行加速?

- 【淘汰9成NLP工程师的常识题】多头注意力相对于单头注意力有什么优势?

- ......

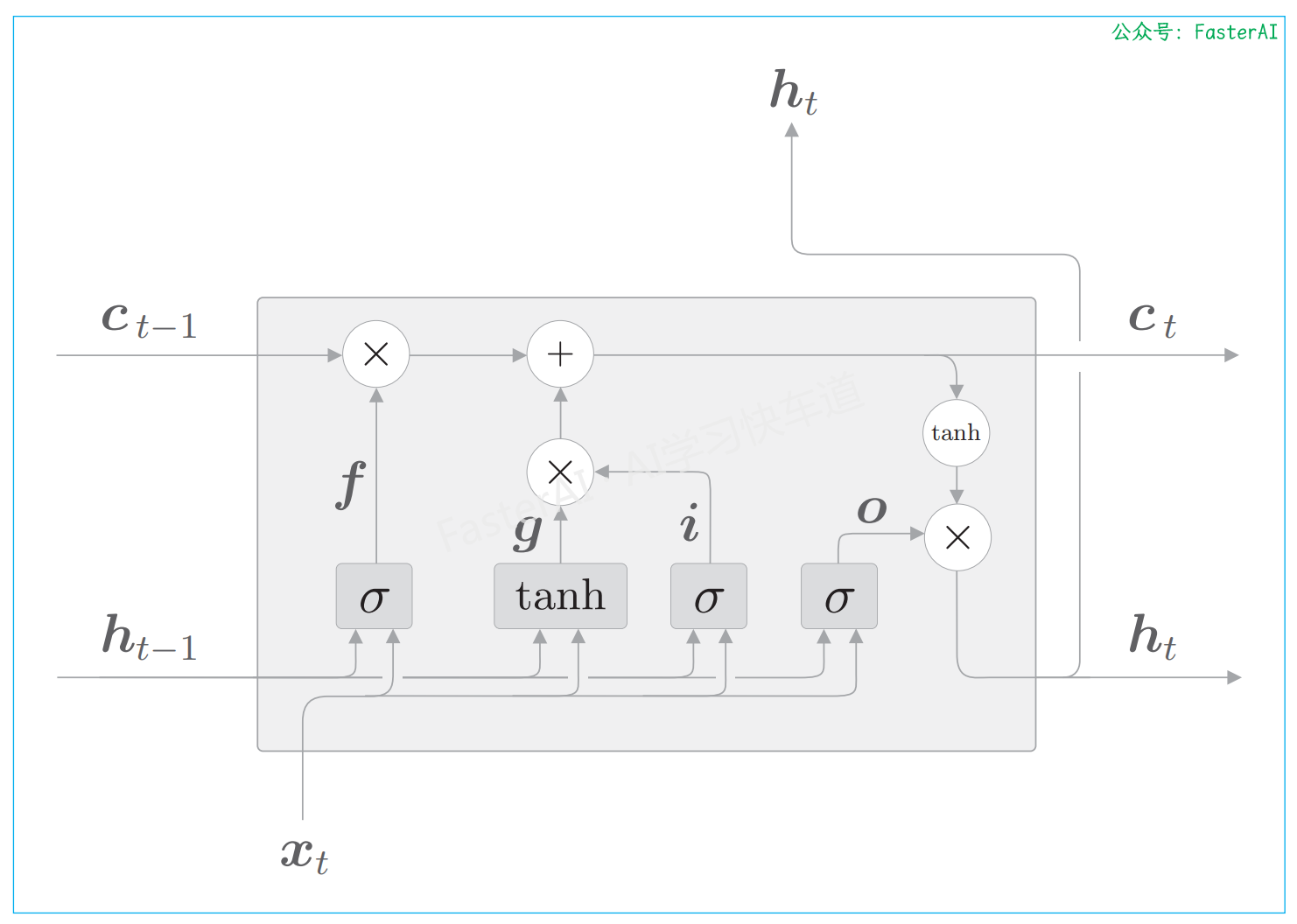

LSTM 单元的计算图:

在大多数情况下,门使用sigmoid函数作为激活函数,而包含实质信息的数据则使用tanh函数作为激活函数。

- 因为tanh的输出是−1.0 ~ 1.0的实数。我们可以认为这个−1.0 ~ 1.0的数值表示某种被编码的“信息”的强弱(程度)。

- 而sigmoid 函数的输出是0.0~1.0的实数,表示数据流出的比例。

拔高(举一反三):深刻理解门控机制,并且知晓门控机制在LSTM、IA3、SwiGLU等中都有应用。

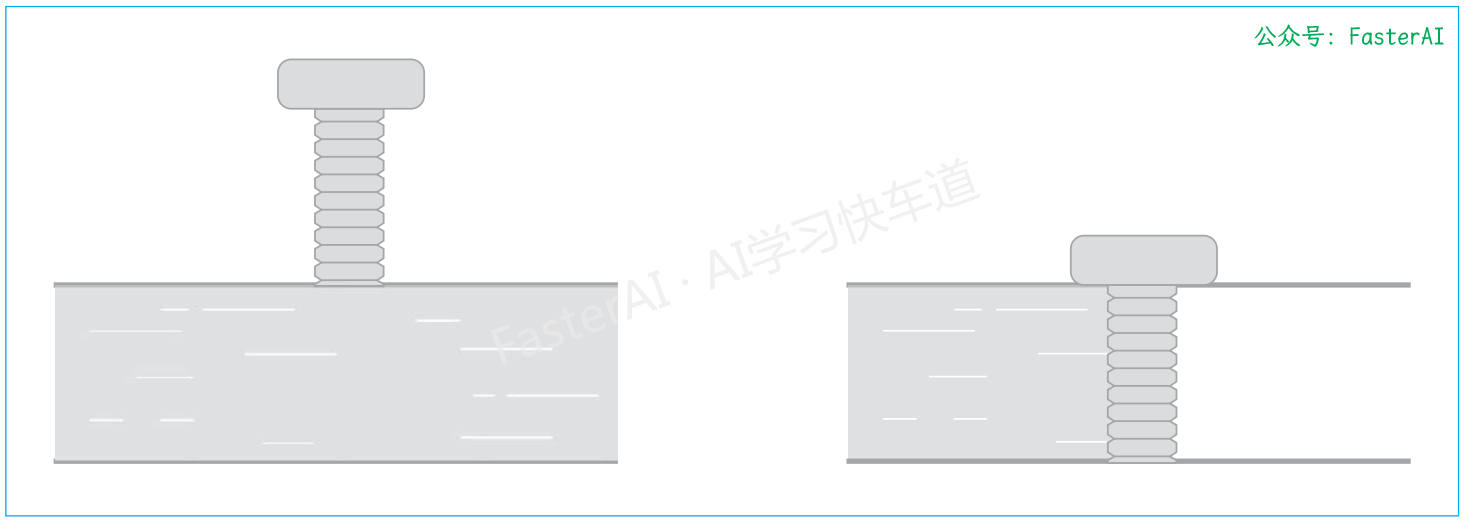

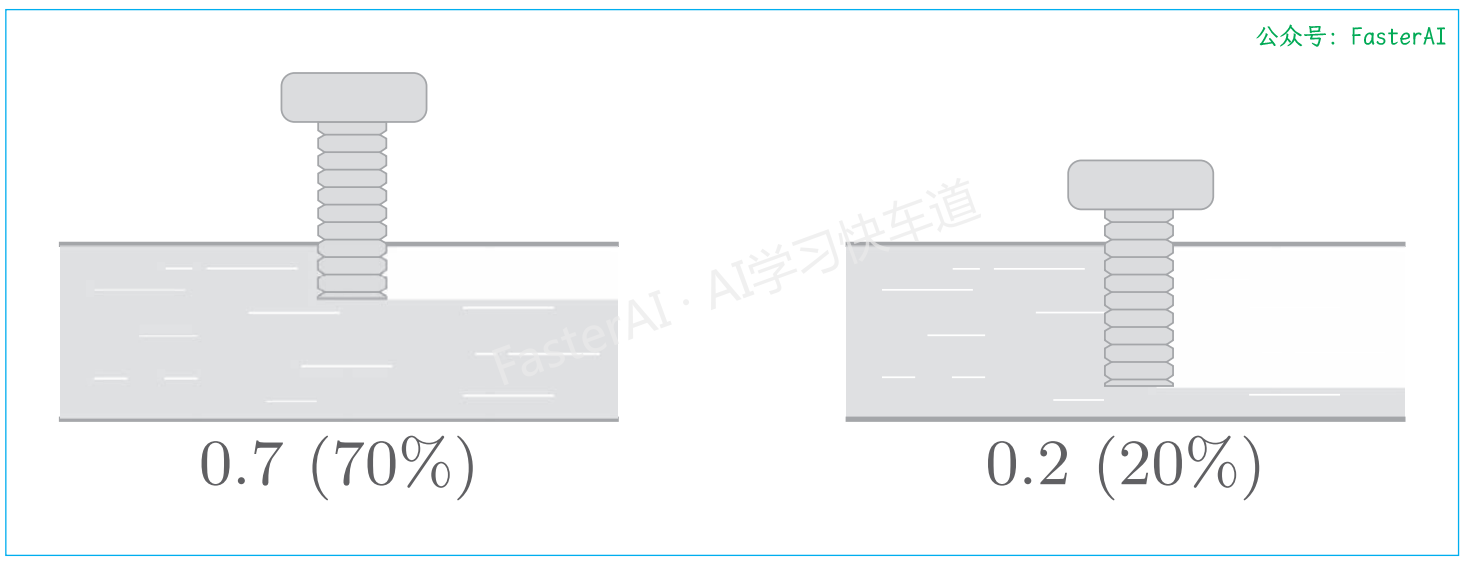

门机制:控制水闸的门就能阻止或者释放水流。类似的,门机制的作用是控制数据的流动。

如上图所示,门的开合程度由 0.0 ~1.0 的实数表示,通过这个数值控制流出的水量,sigmoid 函数用于求门的开合程度(sigmoid 函数的输出范围在 0.0 ~ 1.0)。

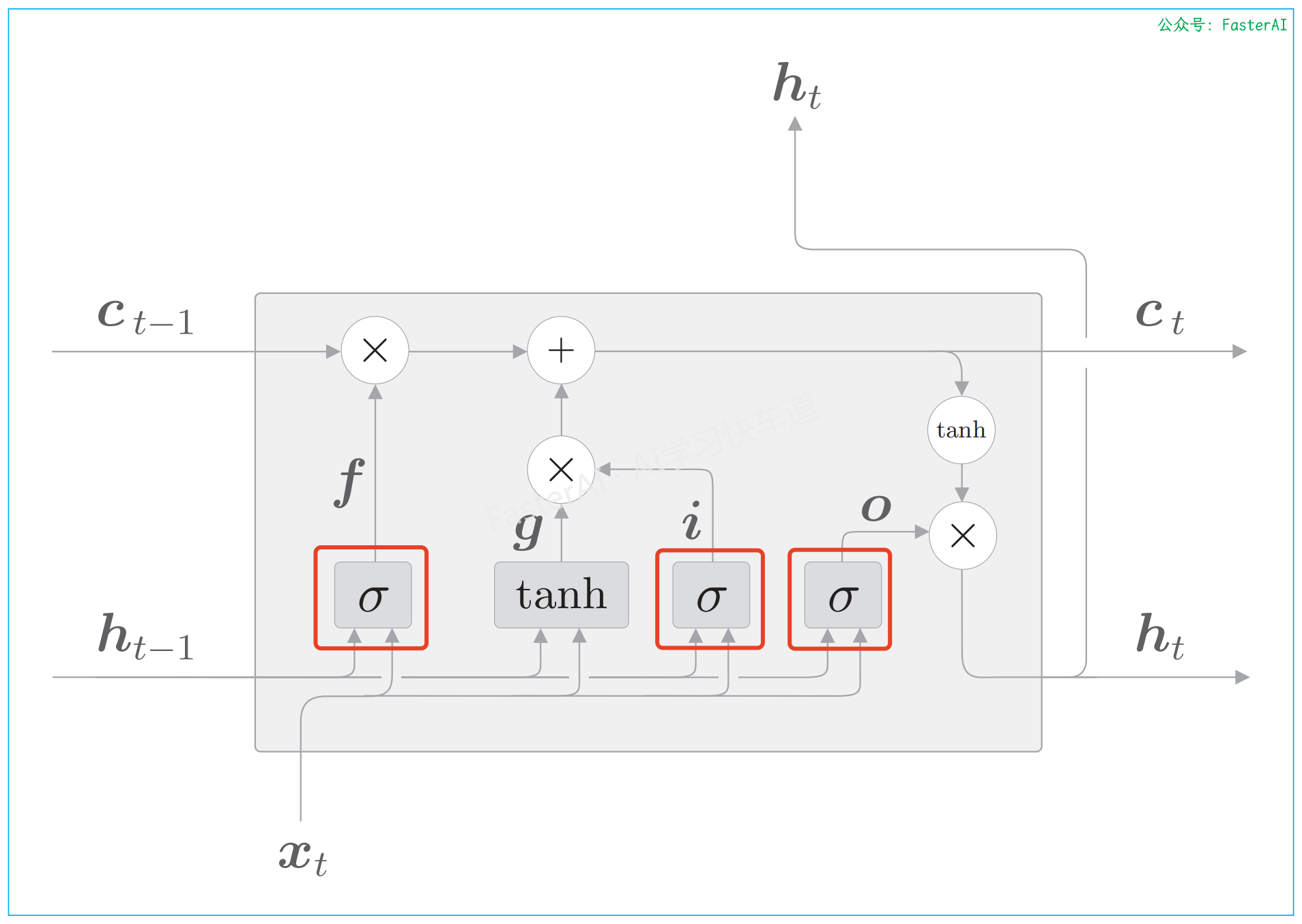

① LSTM 中门控机制的应用:

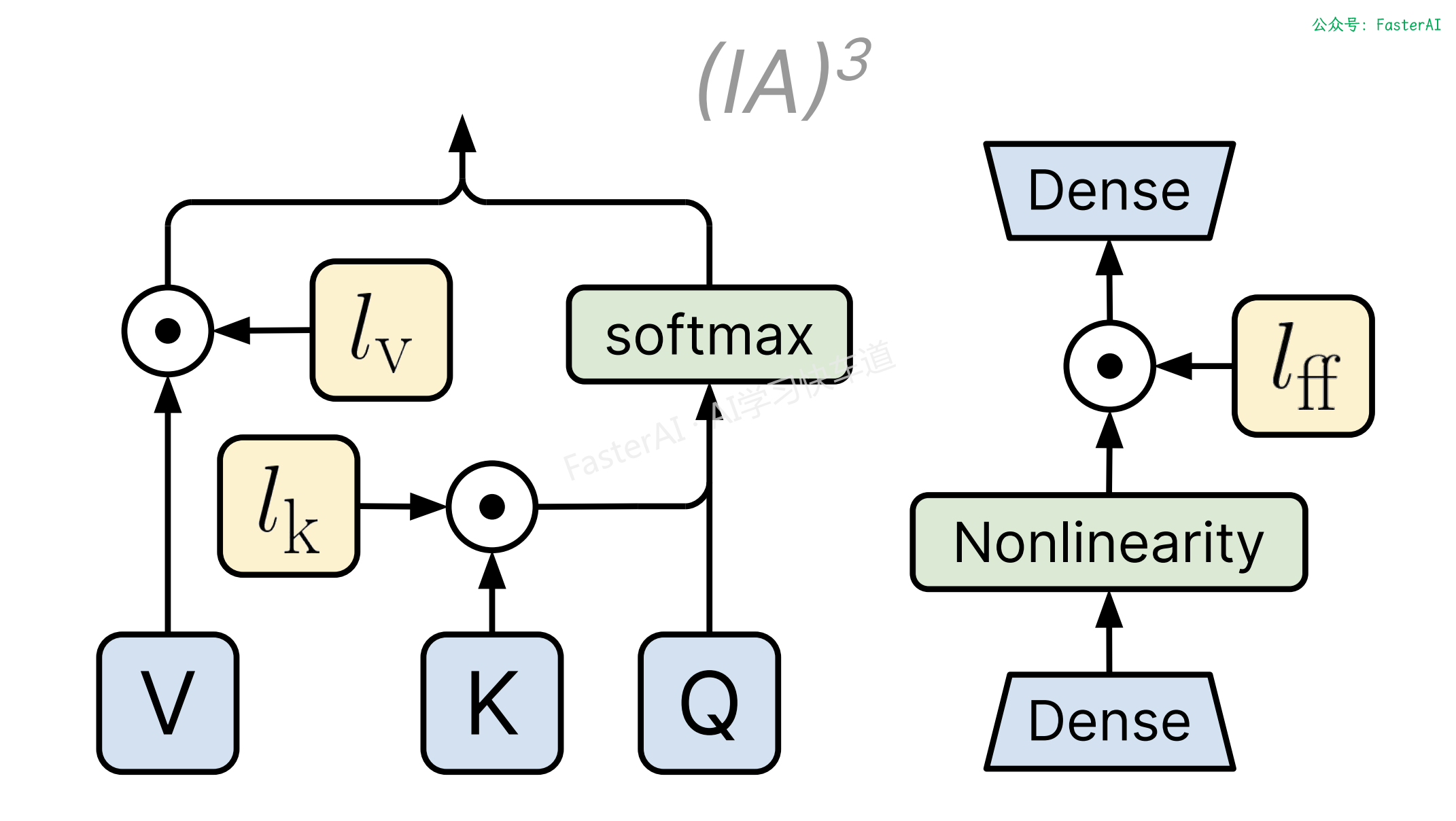

② PEFT的IA3方法中门控机制的应用:

IA3的思想:抑制和放大内部激活,通过可学习的向量对激活值进行抑制或放大。具体来说,会对K、V、FFN三部分的值进行调整,训练过程中同样冻结原始模型的权重,只更新可学习的部分向量部分。训练完成后,与Lora类似,也可以将学习部分的参数与原始权重合并,没有额外推理开销。

③ LLM的IA3方法中门控机制的应用:

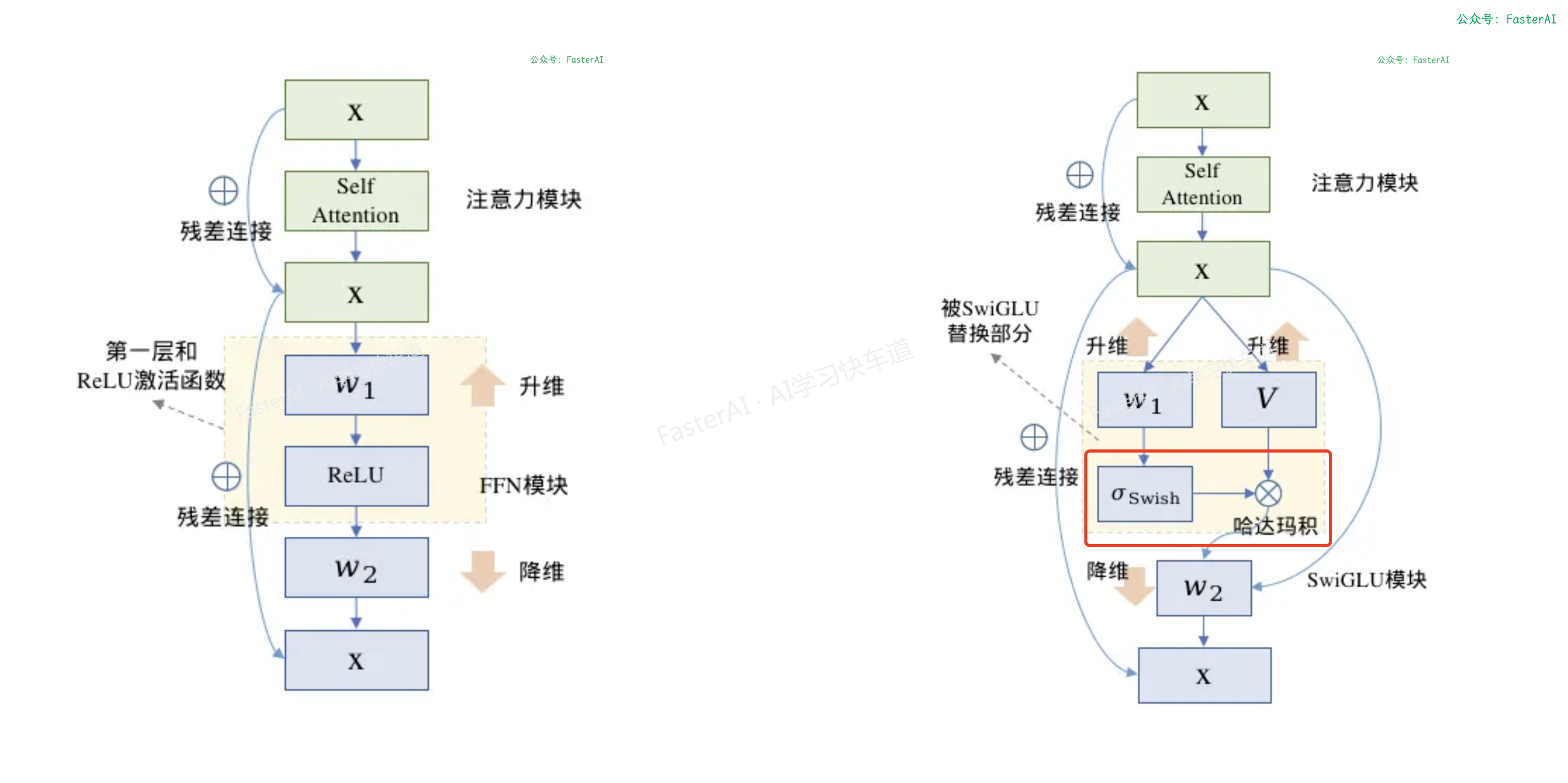

SwiGLU在计算中引入了门控机制,门控机制可以使用更软性的权重筛选有用的信息,并且梯度更平滑。ReLU和SwiGLU的可视化对比:

NLP Github 项目:

-

NLP 项目实践:fasterai/nlp-project-practice

介绍:该仓库围绕着 NLP 任务模型的设计、训练、优化、部署和应用,分享大模型算法工程师的日常工作和实战经验

-

AI 藏经阁:https://gitee.com/fasterai/ai-e-book

介绍:该仓库主要分享了数百本 AI 领域电子书

-

AI 算法面经:fasterai/nlp-interview-handbook#面经

介绍:该仓库一网打尽互联网大厂NLP算法面经,算法求职必备神器

-

NLP 剑指Offer:https://gitee.com/fasterai/nlp-interview-handbook

介绍:该仓库汇总了 NLP 算法工程师高频面题

本文由mdnice多平台发布

浙公网安备 33010602011771号

浙公网安备 33010602011771号