[Paper Reading] Decoding Surface Touch Typing from Hand-Tracking

Decoding Surface Touch Typing from Hand-Tracking

link

时间:20.10

主页:https://research.facebook.com/publications/decoding-surface-touch-typing-from-hand-tracking/

TL;DR

一种XR场景下,在任意平面(flat surface)上通过追踪的裸手26DoF序列来打字的方法。算法方案是使用TCN(时序卷积网络) + 语言模型与beam search来修正结果。实验证明方法输入效率接近于物理键盘(本文方法:73 WPM, 2.38% UER VS 物理键盘:74 WPM, 1.72% UER)。本文研究使用高精Marker获取的HandTracking结果作为suface touch typing的输入,用来研究虚拟键盘打字方式的上限。

Method

推理流程是:HT Skeleton Sequence -> Text -> Text Decoding(beam search)

HT Skeleton Sequence -> Text

模型结构:TCN网络,时间窗口是46帧(约0.75s)

模型输入:wrist position and rotation along with 3D fingertip positions.

模型输出: T × (K + 1) heat map,其中 + 1是blank表示有时手指未type任意一个按键

模型Loss:CTC Loss

TEXT DECODING

两种方案:

greedy:将所有frames结果拿来,除去blanks

beam search decoding(更优):每一步都保留B种结果,并加入语言模型的概率分布,最终整体来判断一个单词的概率。

![]()

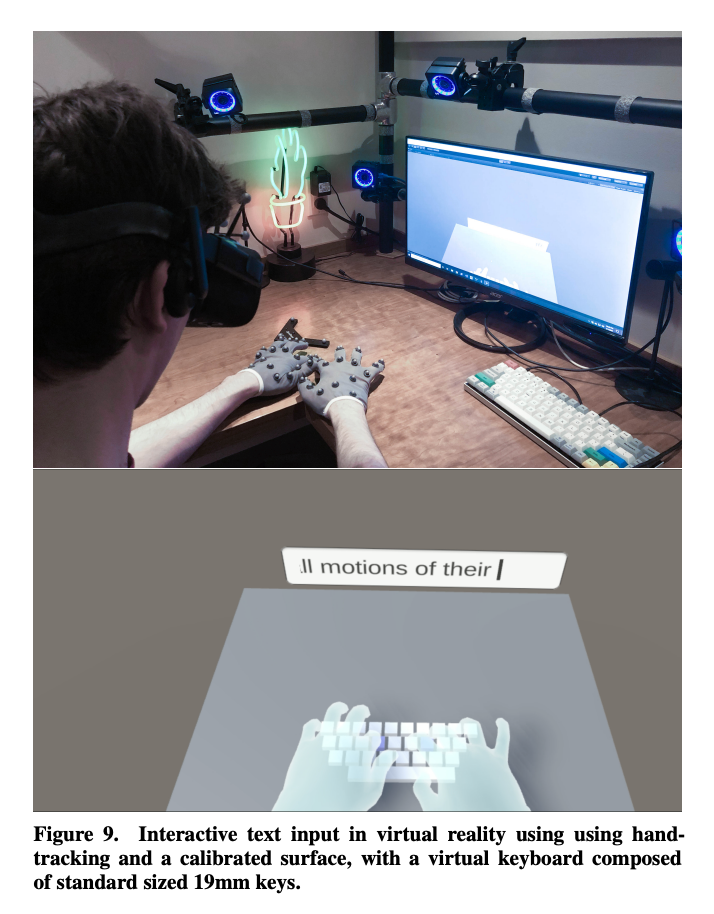

DATA COLLECTION

工装:高精度Marker + TourchPad

The resulting touchpad training dataset consists of samples where we have 1) a sequence of length N of keys that were typed, 2) a sequence of length N of 2D contact events from the touchpad, and 3) a sequence of length T of skeletal hand poses while those keys were typed, recorded at 60Hz.

Q&A

这篇文章中的beam search与contact-based分别指得是什么?

在这篇文章中,"beam search"和"contact-based"是两种不同的文本解码方法,用于将手部追踪数据转换为文本输入。下面分别解释这两个术语:Beam Search(束搜索):

Beam search是一种解码算法,通常用于自然语言处理任务,如机器翻译、语音识别和本文中的手势打字。它是一种启发式的图搜索算法,用于从一系列可能的候选中找到最优解。在这篇文章中,beam search用于结合手部运动模型(motion model)和语言模型(language model),以高效地从手部运动中解码文本。具体来说,它会维护一个候选序列的集合(称为beam),并在每个步骤中扩展这些候选,选择最有可能的序列作为最终输出。这种方法可以有效地结合手部运动信息和语言统计信息,以提高解码的准确性。

Contact-Based(基于接触的):

Contact-based方法是指依赖于物理接触点信息的文本输入方法。在这篇文章的研究中,它被用作对比实验的基线。这种方法通常需要用户在触摸屏幕上的实际接触点来输入文本。在手部追踪的背景下,contact-based方法可能涉及到检测手指与虚拟键盘的接触点,并根据这些接触点的位置来确定按下的键。这种方法可能不如beam search灵活,因为它依赖于精确的接触点检测,而不是手部运动的连续轨迹信息。

文章中提到,相比于contact-based方法,beam search方法能够更准确地解码文本,因为它可以利用手指运动的连续轨迹信息,而不仅仅是接触点。这使得beam search方法在处理手指漂移或模糊接触时更加鲁棒。

Experiment

物理键盘与虚拟键盘对比

整体来看速度略慢一点,精度略高一点,差距不大。

速度:physical keyboards (median: 75 WPM, mean: 74 WPM) as well as on surfaces (median: 69 WPM, mean: 73 WPM).

精度:Participants typed on physical keyboards with a mean UER of 1.72% (median: 1.19%) compared to a mean UER of 2.38% (median: 1.77%) when they typed on flat surfaces with our decoder.

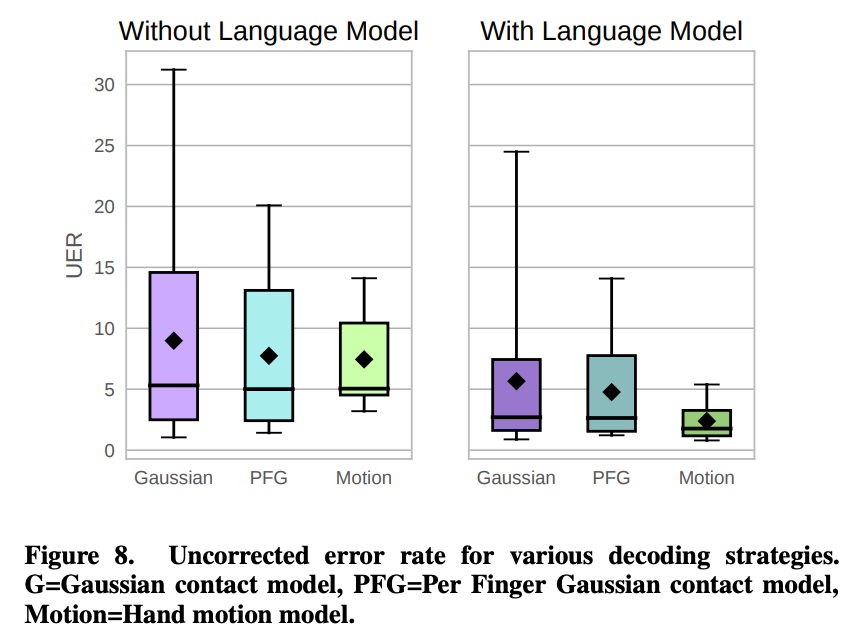

对比不同Motion Model

效果可视化

https://research.facebook.com/publications/decoding-surface-touch-typing-from-hand-tracking/

总结与发散

暂无

相关链接

引用的第三方的链接

资料查询

折叠Title

FromChatGPT(提示词:XXX)本文来自博客园,作者:fariver,转载请注明原文链接:https://www.cnblogs.com/fariver/p/18469908

浙公网安备 33010602011771号

浙公网安备 33010602011771号