[Paper Reading] MOTR: End-to-End Multiple-Object Tracking with Transformer

MOTR: End-to-End Multiple-Object Tracking with Transformer

link

时间:22.07

机构:Megvii

TL;DR

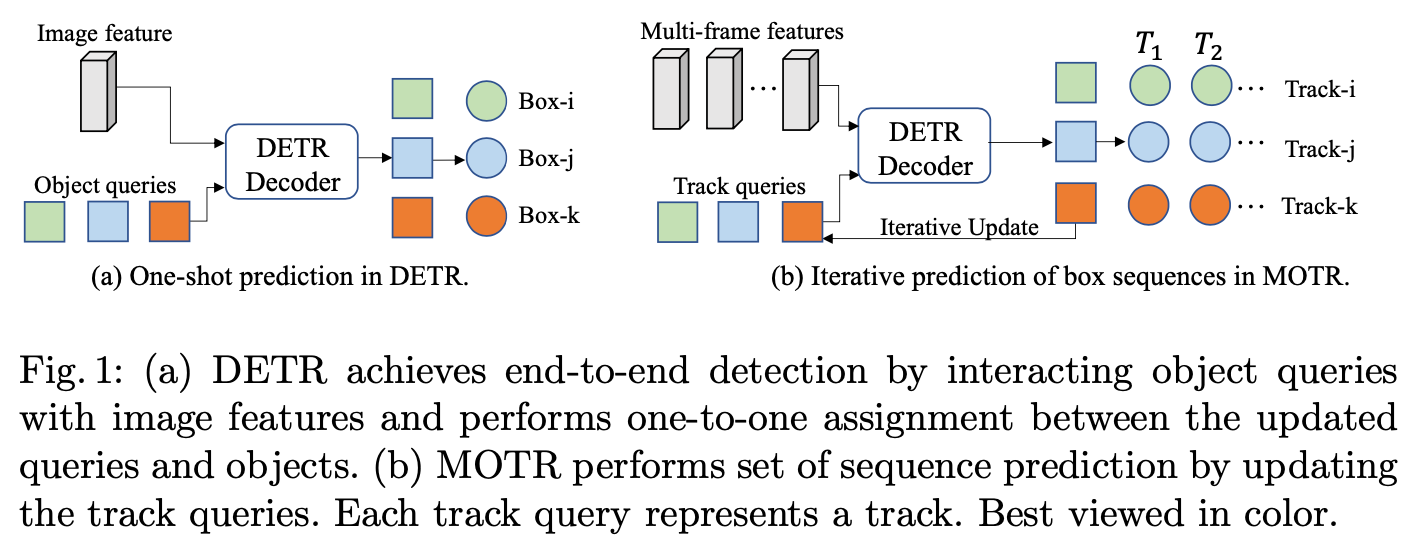

传统MOT通过motion与appearance来建模,有复杂的后处理难以E2E。本文基于DETR设计出MOTR算法,通过引入track query来建模被追踪物体。效果上超过同期方法,TrackFormer/TransTrack。

Method

MOTR与DETR的关系

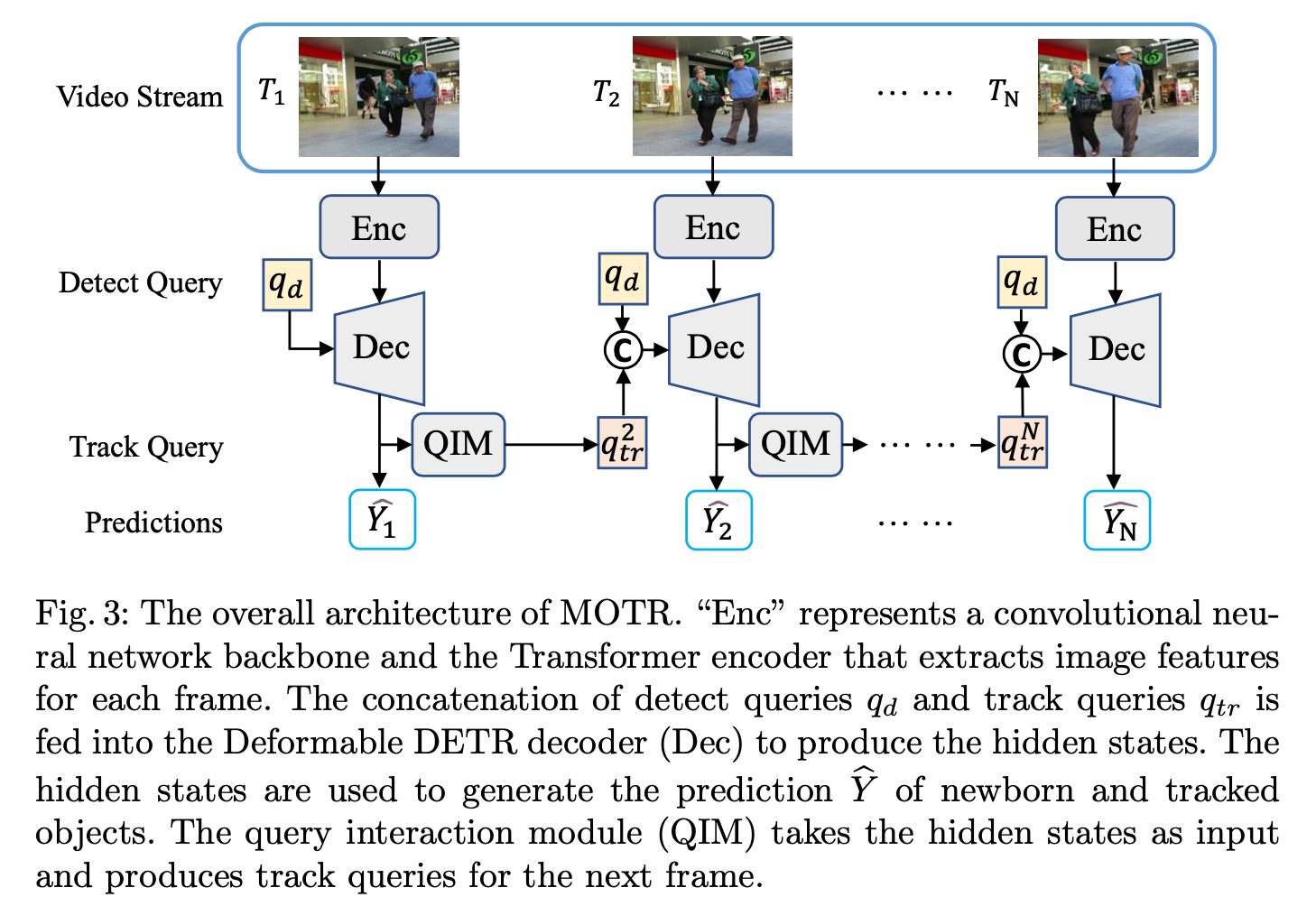

整体算法Pipeline

其中QIM(query interaction module),以及Training Loss会在下面部分展示介绍。

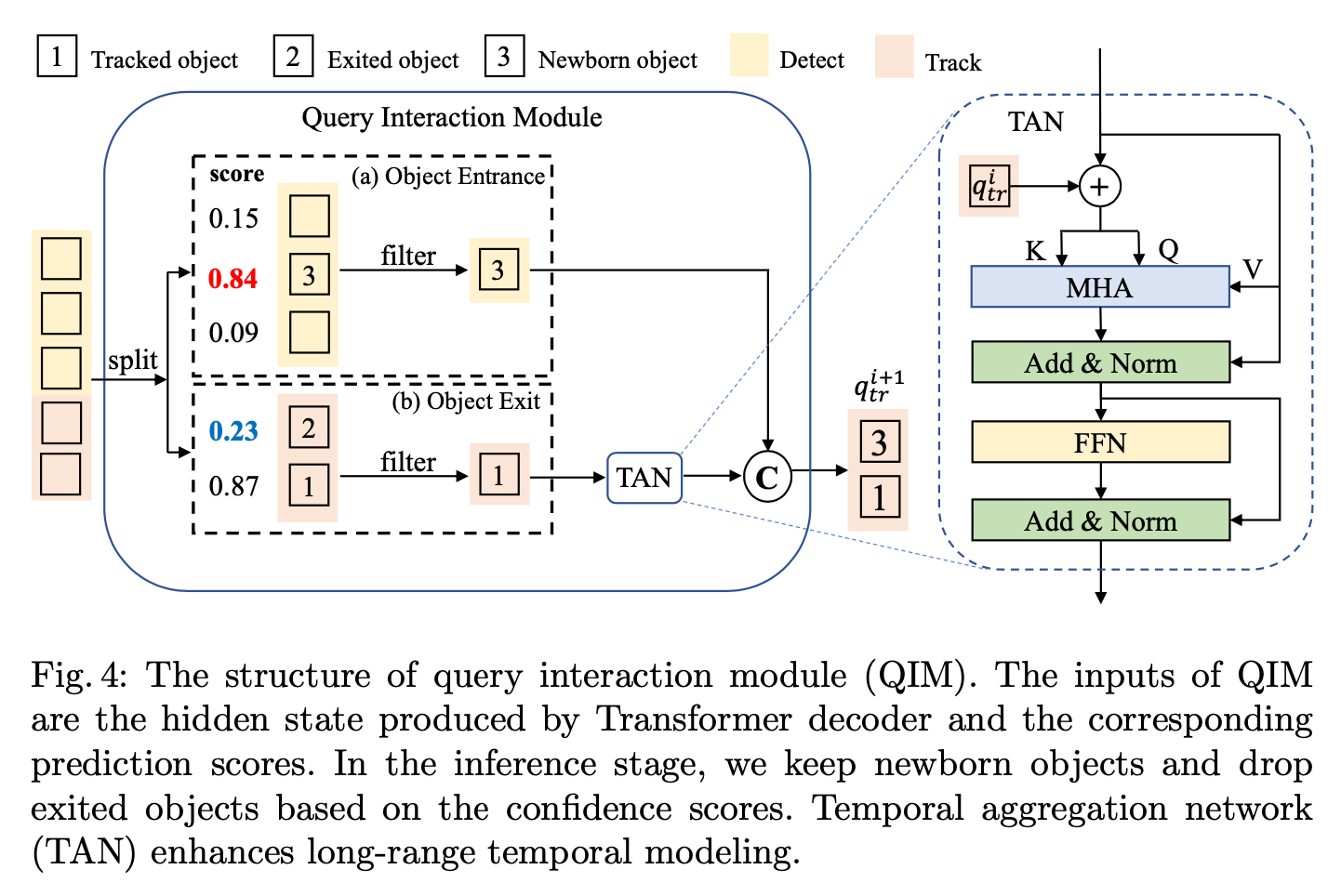

QIM(query interaction module)

一个后处里Module,用来增加新Track,以及杀掉断连的老Track。最左边是Transformer Decoder输出的hidden state(以det + track为query seq),根据通过FFN得到object score来判断det object是否转为track query,以及track query是否该移除seq。TAN是用来update query特征的模块,如果某个track query对应的hidden stage继续跟踪成功,那么使用该hidden stage来更新query \(q^{i}_{tr}\)得到下一帧track query \(q^{i+1}_{tr}\)。

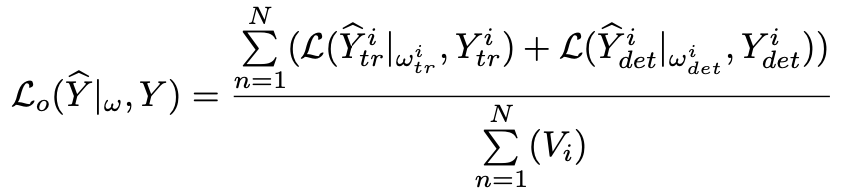

Collective Average Loss

不同于一般的前后帧时序训练,本文是以Clip为单位,一次性训练整个视频,Loss也按照整个Clip来计算。

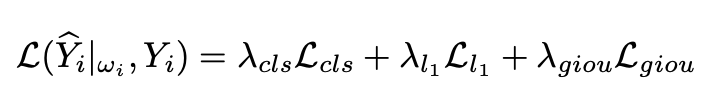

单帧的Loss(参考DETR,只不过有些Det query换成了Track query)

多帧的Loss平均作为最终Loss

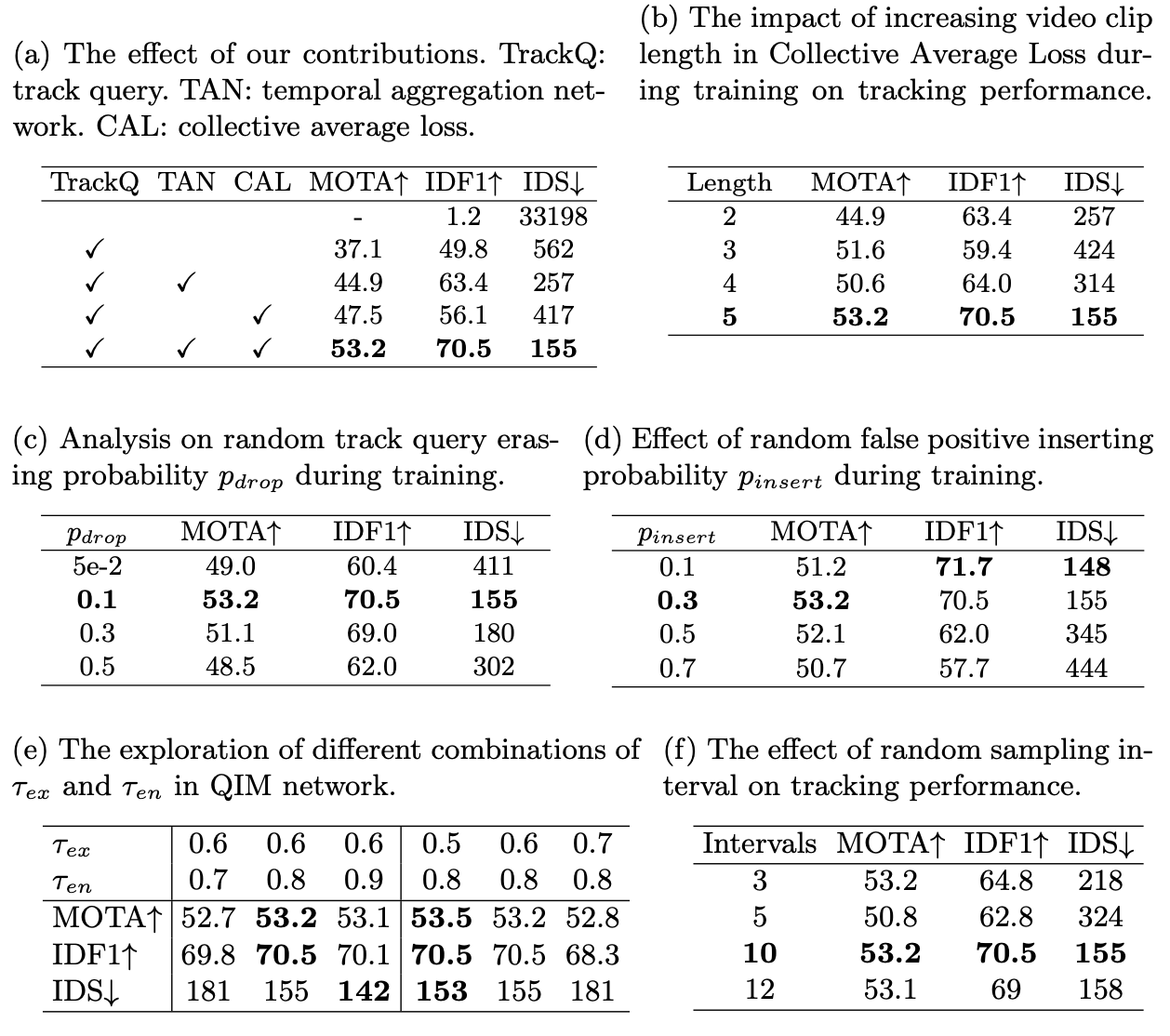

Ablation Study

Experiment

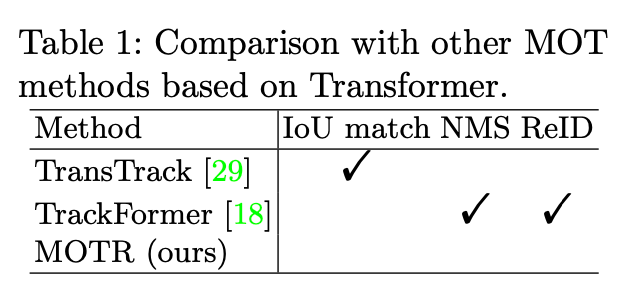

10min, 效果怎么样?哪些分析实验有启发意义?

相比于TrackFormer与TransTrack而言,MOTR更加E2E。

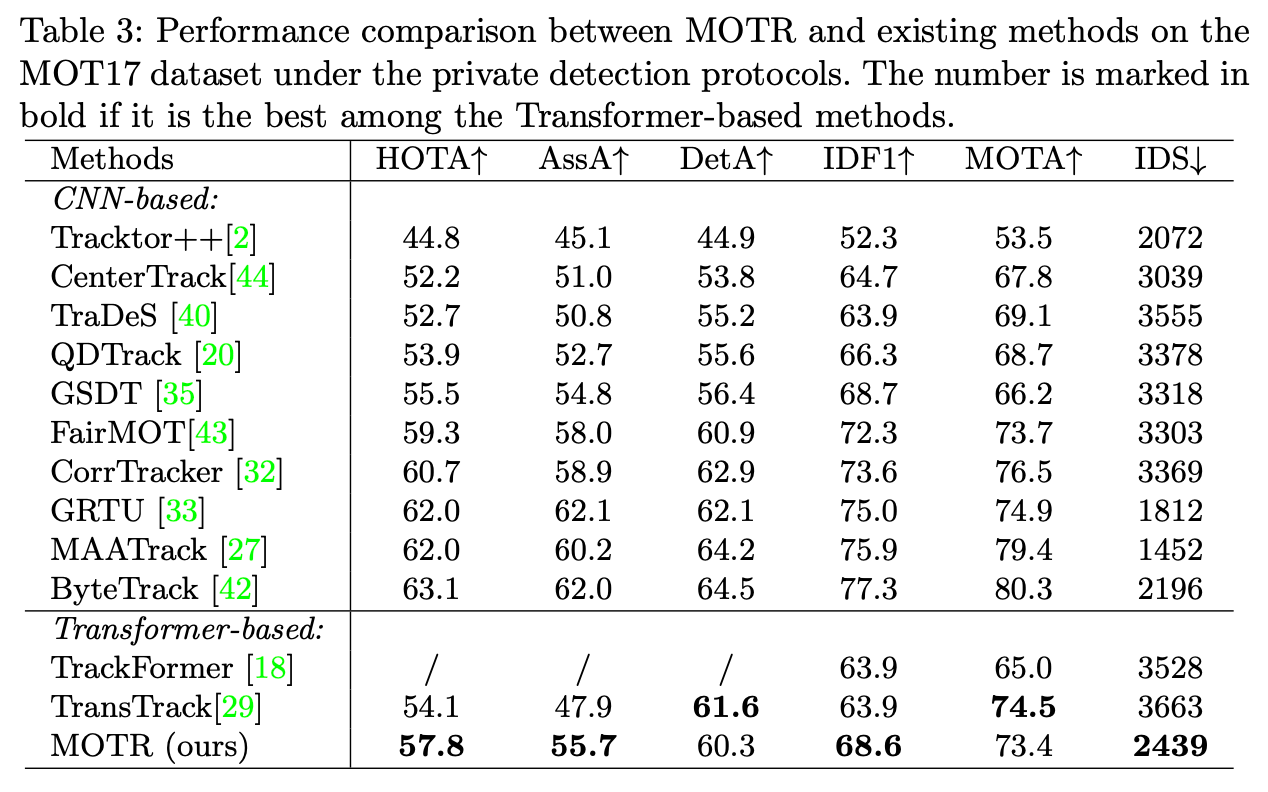

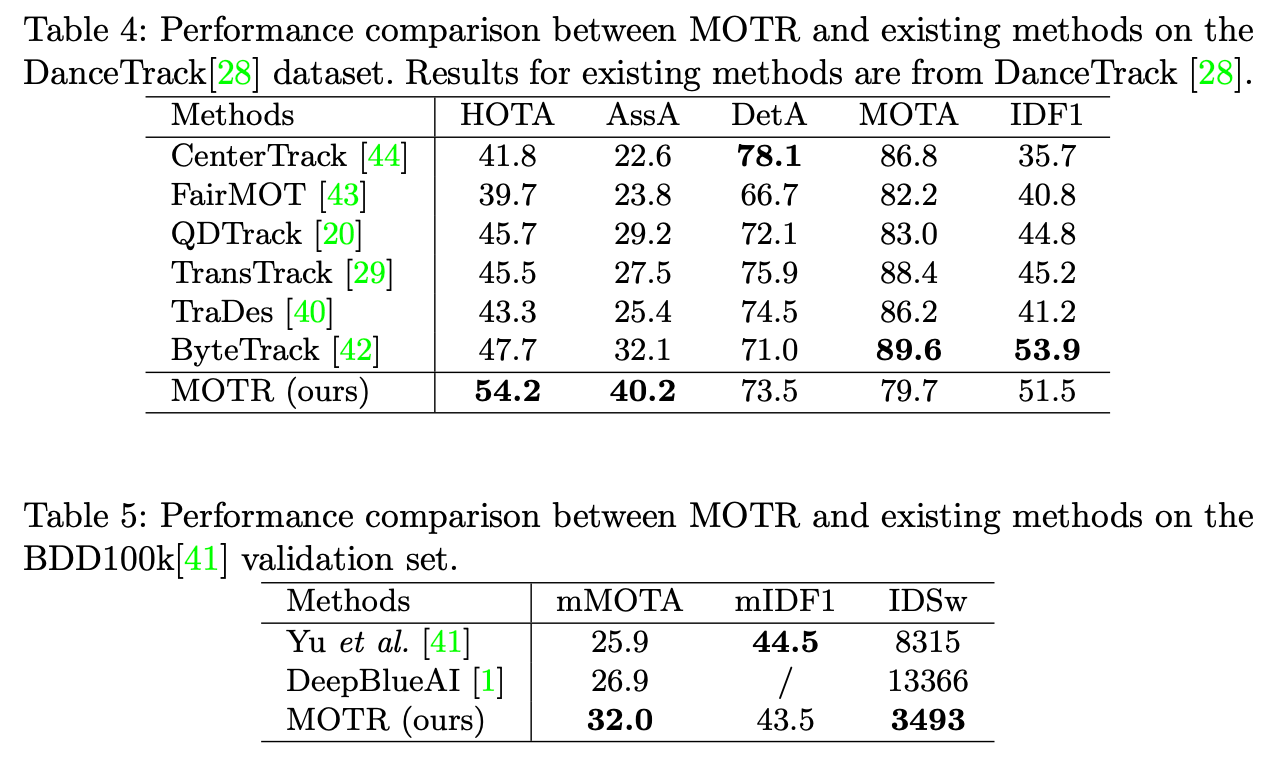

精度虽然没有SOTA,但在Transformer-Based类方法效果最佳。

在另外两个测试集上达到SOTA

总结与发散

相关链接

资料查询

折叠Title

FromChatGPT(提示词:XXX)本文来自博客园,作者:fariver,转载请注明原文链接:https://www.cnblogs.com/fariver/p/18223135

浙公网安备 33010602011771号

浙公网安备 33010602011771号