[基础] DETR:End-to-End Object Detection with Transformers

名称

End-to-End Object Detection with Transformers

时间:20.05

机构:Facebook AI

TL;DR

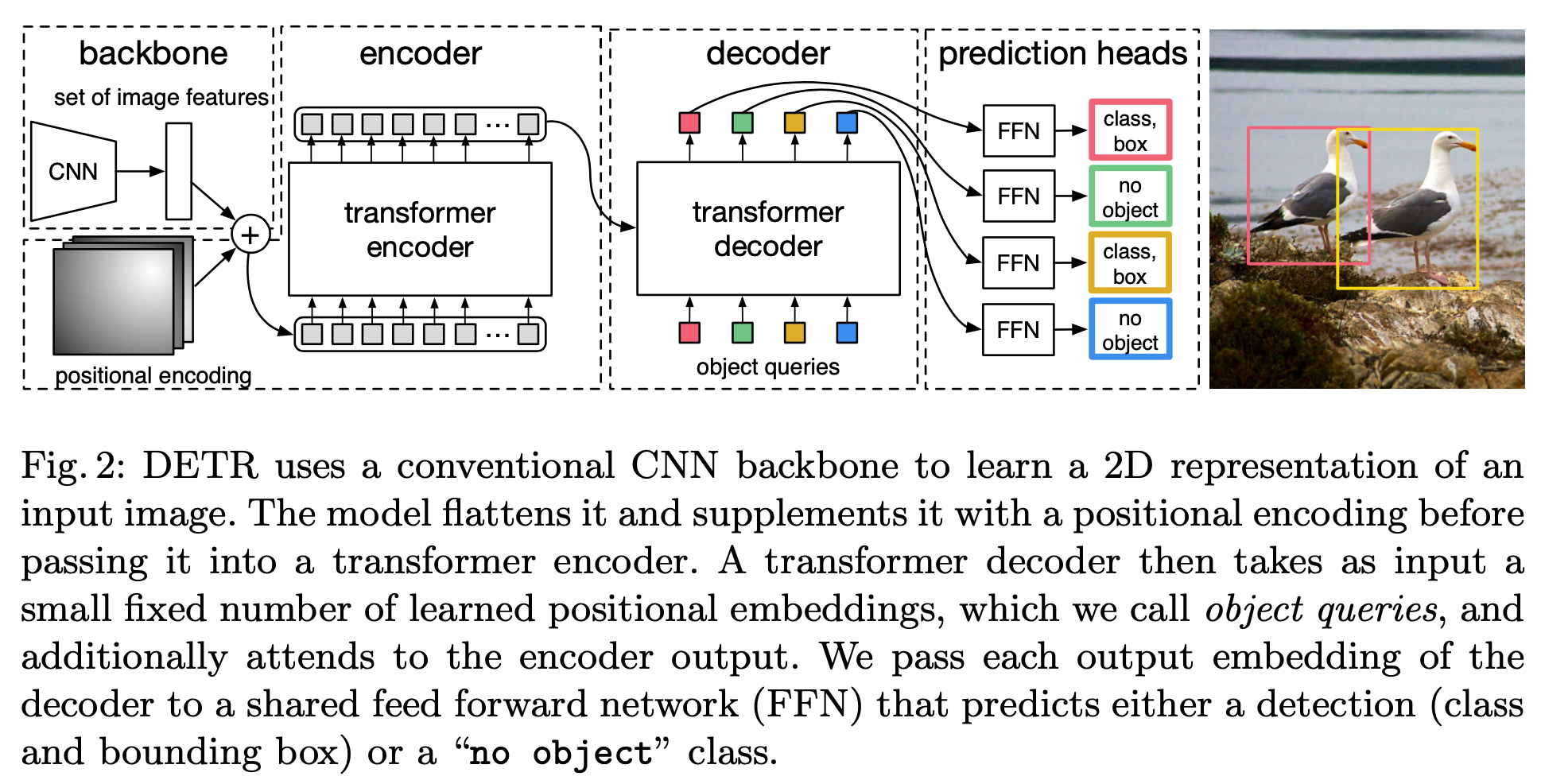

文章提出一种称为DETR(Detection Transformer)的基于Transformer的检测器,相比于传统检测器不需要NMS以及anchor,仅需要少量object queries就可以同时推理出所有预测结果。

Method

Inference

参考下图,其中class预测(C + 1)个类别,多出来那个表示no object。box分量是直接预测框norm之后的中心点与宽高,没有anchor作为初始值。

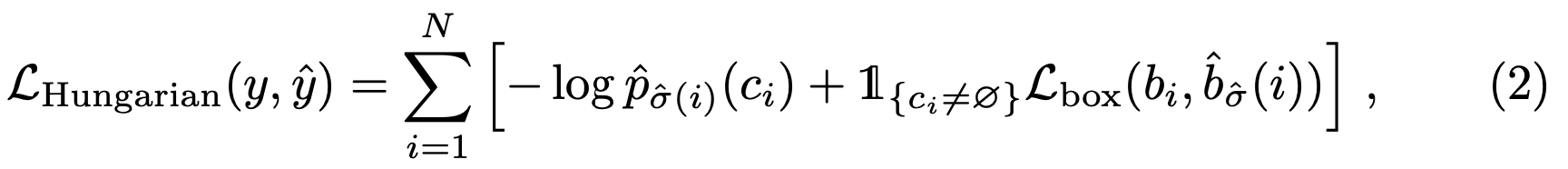

Training Loss

类似于常规Detection任务训练,求N个Set Prediction的分类与box回归的Loss之和,其中匹配到no class的prediction loss权重设置的比较低。

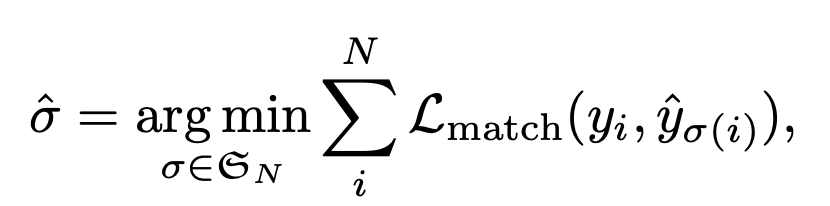

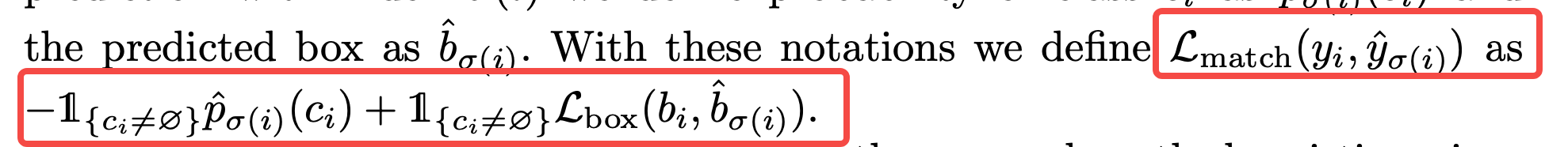

关键在于如何知道每个prediction对应的GT,即如何求公式中的\(\sigma(i)\)。这里用的方法比较暴力,直接针对每一次forward出的N个set prediction使用匈牙利匹配来计算与每个prediction对应的GT。而匈牙利匹配建立cost matrix时,每个位置的权值是参考class score以及与gt box iou共同决定。

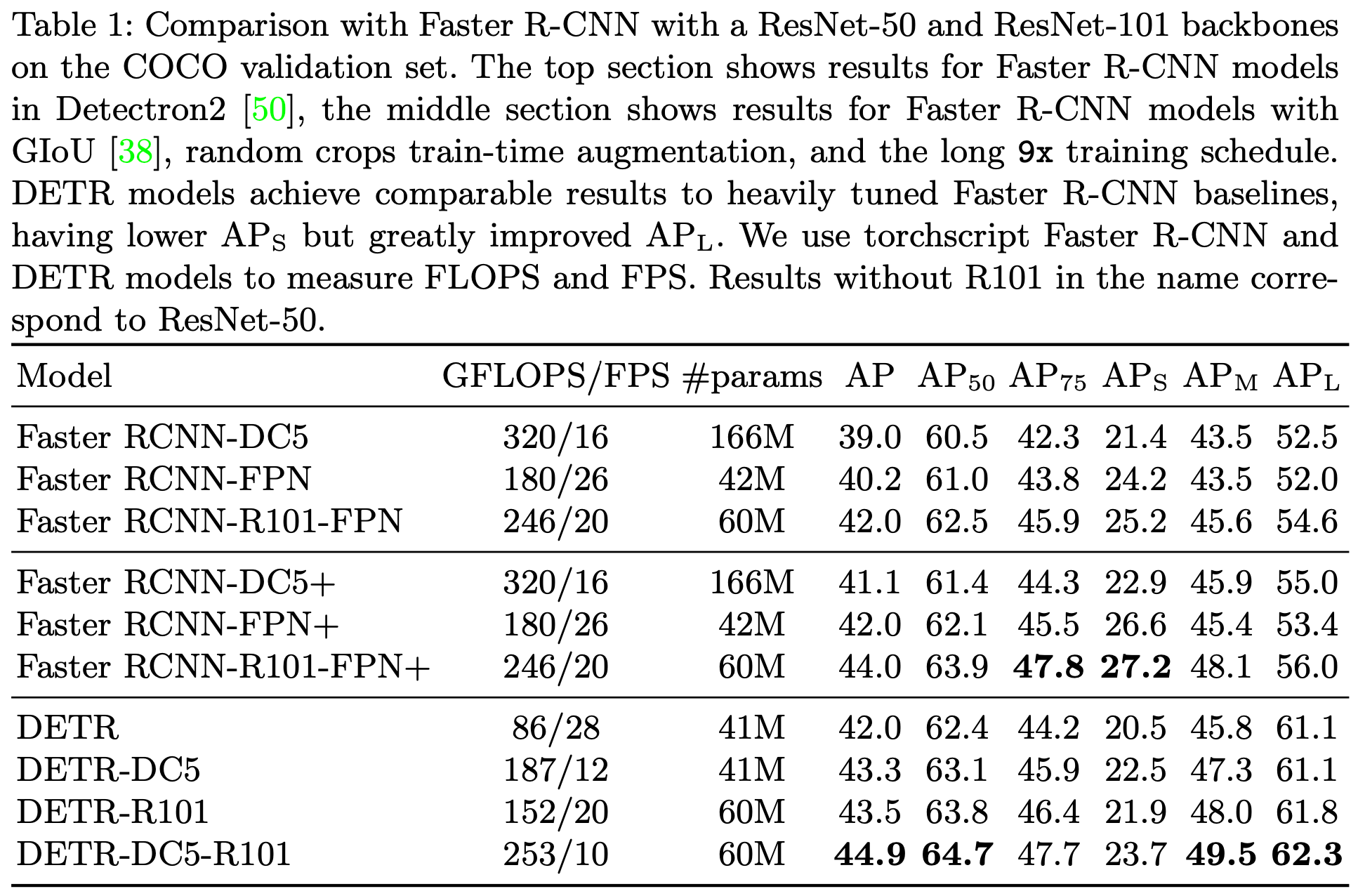

Experiment

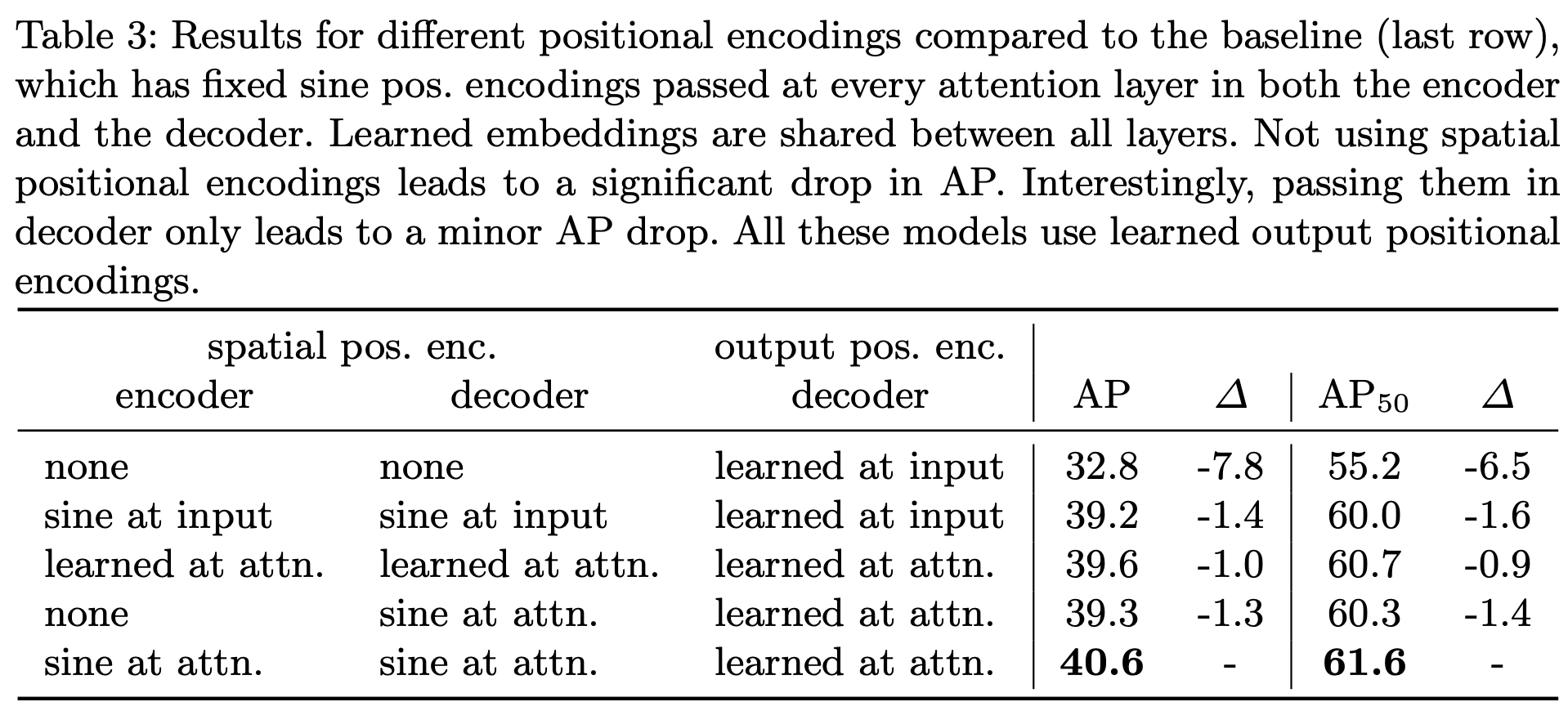

sine at attn表示输入一个预设的positional encoding map,learned at attn表示输入一个可学习的attention map。

总结与发散

首个使用Transformer将detection做到E2E的工作,整体思路比较简单,Loss部分设计比较暴力。

相关链接

官方代码:https://github.com/facebookresearch/detr

资料查询

折叠Title

FromChatGPT(提示词:XXX)本文来自博客园,作者:fariver,转载请注明原文链接:https://www.cnblogs.com/fariver/p/18151680

浙公网安备 33010602011771号

浙公网安备 33010602011771号