Spark 集群安装

2.1 集群角色

从物理部署层面上来看,Spark 主要分为两种类型的节点,Master 节点和 Worker 节点,Master 节点主要运行集群管理器的中心化部分,所承载的作用是分配 Application 到 Worker 节点,维护 Worker 节点 的 Driver、Application 的状态。Worker 节点负责具体的业务运行。

从 Spark 程序运行的层面来看,Spark 主要分为驱动器节点和执行器节点。

2.2 机器准备

准备两台以上 Linux 服务器,安装好 JDK1.8。

2.3 下载 Spark 安装包

Step0、使用下载命令

wget 下载地址

Step1、上传 spark-2.1.1-bin-hadoop2.7.tgz 安装包到 Linux 对应的目录上,本人是上传至 /opt/software 目录下

Step2、解压安装包到指定位置

tar -zxf /opt/software/spark-2.1.1-bin-hadoop2.7.tgz -C /opt/module

如下图所示:

2.4 配置 Spark Standalone 模式

Spark 的部署模式有Local、Local-Cluster、Standalone、Yarn、Mesos,我们选择最具代表性的 Standalone 集群部署模式。

Step1、进入到 Spark 安装目录中的配置目录 conf

cd /opt/module/spark-2.1.1-bin-hadoop2.7/conf

如下图所示:

Step2、将 slaves.template 复制为 slaves

Step3、将 spark-env.sh.template 复制为 spark-env.sh

Step4、修改 slaves 文件,将 Worker 的 hostname 输入:

Step5、修改 spark-env.sh 文件,添加如下配置:

SPARK_MASTER_HOST=hadoop102

SPARK_MASTER_PORT=7077

Step6、将配置好的 Spark 文件拷贝到其他节点上 或者 使用配置分发的脚本

scp -r /opt/module/spark-2.1.1-bin-hadoop2.7/ atguigu@hadoop103:/opt/module/

scp -r /opt/module/spark-2.1.1-bin-hadoop2.7/ atguigu@hadoop104:/opt/module/

或者

xsync /opt/module/spark-2.1.1-bin-hadoop2.7/

Step7、Spark 集群配置完毕,目前是 1 个 Master,2 个 Work,hadoop102 上启动 Spark 集群

$ /opt/module/spark-2.1.1-bin-hadoop2.7/sbin/start-all.sh

如下图所示:

启动后执行 jps 命令,主节点上有 Master 进程,其他子节点上有 Worker 进行

登录 Spark 管理界面查看集群状态(主节点):http://hadoop102:8080/ 或者 http://192.168.25.102:8080/

到此为止,Spark 集群安装完毕。

问题1:如果遇到 “JAVA_HOME not set” 异常,如下图所示:

解决方案:可以在 sbin 目录下的 spark-config.sh 文件中加入如下配置,然后配置分发到其他机器:

export JAVA_HOME=/opt/module/jdk1.8.0_144

如下图所示:

问题2:如果遇到 Hadoop HDFS 的写入权限异常:

org.apache.hadoop.security.AccessControlException

解决方案: 在 hdfs-site.xml 中添加如下配置,关闭权限验证,然后配置分发到其他机器:

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

2.5 配置 Spark History Server

Step1、进入到 Spark 安装目录

cd /opt/module/spark-2.1.1-bin-hadoop2.7/conf

Step2、将 spark-default.conf.template 复制为 spark-default.conf

$ cp spark-defaults.conf.template spark-defaults.conf

Step3、修改 spark-default.conf 文件,开启 Log:

spark.master spark://hadoop102:7077

spark.eventLog.enabled true

spark.eventLog.dir hdfs://hadoop102:9000/directory

如下图所示:

Step4、修改 spark-env.sh 文件,添加如下配置:

export SPARK_HISTORY_OPTS="-Dspark.history.ui.port=4000

-Dspark.history.retainedApplications=3

-Dspark.history.fs.logDirectory=hdfs://hadoop102:9000/directory"

如下图所示:

Step5、启动 HDFS 集群,在 HDFS 上创建好你所指定的 eventLog 日志目录。

$ /opt/module/hadoop-2.7.2/bin/hdfs dfs -mkdir -p /directory

参数描述:

spark.eventLog.dir Application 在运行过程中所有的信息均记录在该属性指定的路径下

spark.history.ui.port=4000 调整 WEBUI 访问的端口号为 4000

spark.history.retainedApplications=3 指定保存 Application 历史记录的个数,如果超过这个值,旧的应用程序信息将被删除,这个是内存中的应用数,而不是页面上显示的应用数

spark.history.fs.logDirectory=hdfs://hadoop102:9000/directory 配置了该属性后,在 start-history-server.sh 时就无需再显式的指定路径,Spark History Server 页面只展示该指定路径下的信息

Step6、将配置好的 Spark 文件拷贝到其他节点上或者配置分发。

Step7、重启 Spark 集群。

$ /opt/module/spark-2.1.1-bin-hadoop2.7/sbin/start-all.sh

Step8、启动后执行历史服务器。

$ /opt/module/spark-2.1.1-bin-hadoop2.7/sbin/start-history-server.sh

网页上查看

到此为止,Spark History Server 安装完毕。

2.6 配置 Spark HA

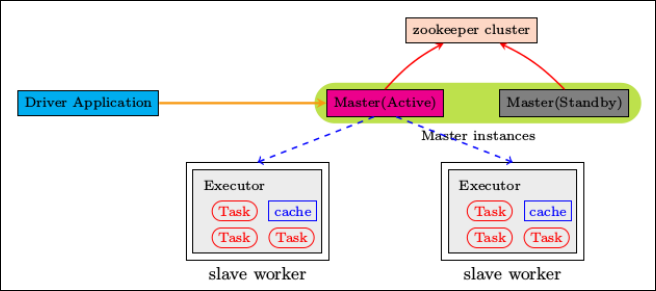

集群部署完了,但是有一个很大的问题,那就是 Master 节点存在单点故障,要解决此问题,就要借助 zookeeper,并且启动至少两个 Master 节点来实现高可靠,配置方式比较简单:

Step1、Spark 集群规划:hadoop102,hadoop103 是 Master;hadoop103,hadoop104 是 Worker。

Step2、安装配置 Zookeeper 集群,并启动 Zookeeper 集群。

Step3、停止 spark 所有服务,在 hadoop102 节点上修改配置文件 spark-env.sh,在该配置文件中删掉 SPARK_MASTER_IP(即 SPARK_MASTER_HOST) 并添加如下配置:

export SPARK_DAEMON_JAVA_OPTS="

-Dspark.deploy.recoveryMode=ZOOKEEPER

-Dspark.deploy.zookeeper.url=hadoop102:2181,hadoop103:2181,hadoop104:2181

-Dspark.deploy.zookeeper.dir=/spark"

如下图所示:

Step4、在 hadoop102 节点上修改 slaves 配置文件内容指定 worker 节点。

hadoop103

hadoop104

Step5、将配置文件同步到所有节点。

Step6、在 hadoop102 上执行 sbin/start-all.sh 脚本,启动集群并启动第一个 master 节点,然后在 hadoop103 上执行 sbin/start-master.sh 启动第二个 master 节点。

Step7、程序中 spark 集群的访问地址需要改成:

--master spark://hadoop102:7077,hadoop103:7077

我们干掉 hadoop102 上的 Master 进程,然后再次执行 WordCount 程序,看是否能够执行成功:

由上图可知,程序依旧可以运行。

同理:我们再干掉 hadoop103 上的 Master 进程,然后再次执行 WordCount 程序,看是否能够执行成功,经过测试,程序依旧可以执行成功,到此为止,Spark 的高可用完成!

Step8、我们想知道 Zookeeper 中保存了什么?

[atguigu@hadoop102 zookeeper-3.4.10]$ pwd

/opt/module/zookeeper-3.4.10

[atguigu@hadoop102 zookeeper-3.4.10]$ bin/zkCli.sh -server hadoop102:2181,hadoop103:2181,hadoop104:2181

Connecting to hadoop102:2181,hadoop103:2181,hadoop104:2181

......

......

[zk: hadoop102:2181,hadoop103:2181,hadoop104:2181(CONNECTED) 0] ls /spark

[leader_election, master_status]

[zk: hadoop102:2181,hadoop103:2181,hadoop104:2181(CONNECTED) 1] get /spark/master_status

192.168.25.102

cZxid = 0x4000000059

ctime = Mon Apr 22 10:10:11 CST 2019

mZxid = 0x4000000059

mtime = Mon Apr 22 10:10:11 CST 2019

pZxid = 0x4000000063

cversion = 3

dataVersion = 0

aclVersion = 0

ephemeralOwner = 0x0

dataLength = 14

numChildren = 3

[zk: hadoop102:2181,hadoop103:2181,hadoop104:2181(CONNECTED) 2]

2.7 配置 Spark Yarn 模式

Step1、修改 hadoop 配置下的 /opt/module/hadoop-2.7.2/etc/hadoop/yarn-site.xml 文件,然后分发到其他节点。

yarn-site.xml

<?xml version="1.0"?>

<configuration>

<!-- Reducer获取数据的方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 指定YARN的ResourceManager的地址 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop103</value>

</property>

<!-- 日志聚集功能使能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 日志保留时间设置7天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

<!-- 任务历史服务器 -->

<property>

<name>yarn.log.server.url</name>

<value>http://hadoop102:19888/jobhistory/logs/</value>

</property>

<!-- 指定yarn在启动的时候的内存大小 -->

<property>

<name>yarn.scheduler.maximum-allocation-mb</name>

<value>2048</value>

</property>

<property>

<name>yarn.scheduler.minimum-allocation-mb</name>

<value>2048</value>

</property>

<property>

<name>yarn.nodemanager.vmem-pmem-ratio</name>

<value>2.1</value>

</property>

<property>

<name>mapred.child.java.opts</name>

<value>-Xmx1024m</value>

</property>

<!--是否启动一个线程检查每个任务正使用的物理内存量,如果任务超出分配值,则直接将其杀掉,默认是 true,实际开发中设置成 true,学习阶段设置成 false -->

<property>

<name>yarn.nodemanager.pmem-check-enabled</name>

<value>false</value>

</property>

<!--是否启动一个线程检查每个任务正使用的虚拟内存量,如果任务超出分配值,则直接将其杀掉,默认是 true,实际开发中设置成 true,学习阶段设置成 false -->

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

</configuration>

Step2、修改 /opt/module/spark-2.1.1-bin-hadoop2.7/conf/spark-env.sh,添加以下内容,然后分发到其他节点。

spark-env.sh

# 让 spark 能够发现 hadoop 的配置文件

HADOOP_CONF_DIR=/opt/module/hadoop-2.7.2/etc/hadoop

YARN_CONF_DIR=/opt/module/hadoop-2.7.2/etc/hadoop

如下图所示:

Step3、提交应用进行测即可

$ /opt/module/spark-2.1.1-bin-hadoop2.7/bin/spark-submit \

--class com.atguigu.sparkdemo.WordCountDemo \

--master yarn \

--deploy-mode client \

--executor-memory 1G \

--total-executor-cores 2 \

/opt/software/sparkdemo-1.0-SNAPSHOT-jar-with-dependencies.jar \

hdfs://hadoop102:9000/RELEASE \

hdfs://hadoop102:9000/out

或者

$ /opt/module/spark-2.1.1-bin-hadoop2.7/bin/spark-submit \

--class com.atguigu.sparkdemo.WordCountDemo \

--master yarn-client \

--executor-memory 1G \

--total-executor-cores 2 \

/opt/software/sparkdemo-1.0-SNAPSHOT-jar-with-dependencies.jar \

hdfs://hadoop102:9000/RELEASE \

hdfs://hadoop102:9000/out

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY