熟悉常用的HDFS操作

实验2

熟悉常用的HDFS操作

1.实验目的

(1)理解HDFS在Hadoop体系结构中的角色;

(2)熟练使用HDFS操作常用的Shell命令;

(3)熟悉HDFS操作常用的Java API。

2. 实验平台

(1)操作系统:Linux(建议Ubuntu16.04或Ubuntu18.04);

(2)Hadoop版本:3.1.3;

(3)JDK版本:1.8;

(4)Java IDE:Eclipse。

3. 实验步骤

(一)编程实现以下功能,并利用Hadoop提供的Shell命令完成相同任务:

向HDFS中上传任意文本文件,如果指定的文件在HDFS中已经存在,则由用户来指定是追加到原有文件末尾还是覆盖原有的文件;

从HDFS中下载指定文件,如果本地文件与要下载的文件名称相同,则自动对下载的文件重命名;

将HDFS中指定文件的内容输出到终端中;

显示HDFS中指定的文件的读写权限、大小、创建时间、路径等信息;

给定HDFS中某一个目录,输出该目录下的所有文件的读写权限、大小、创建时间、路径等信息,如果该文件是目录,则递归输出该目录下所有文件相关信息;

提供一个HDFS内的文件的路径,对该文件进行创建和删除操作。如果文件所在目录不存在,则自动创建目录;

提供一个HDFS的目录的路径,对该目录进行创建和删除操作。创建目录时,如果目录文件所在目录不存在,则自动创建相应目录;删除目录时,由用户指定当该目录不为空时是否还删除该目录;

向HDFS中指定的文件追加内容,由用户指定内容追加到原有文件的开头或结尾;

删除HDFS中指定的文件;

在HDFS中,将文件从源路径移动到目的路径。

(二)编程实现一个类“MyFSDataInputStream”,该类继承“org.apache.hadoop.fs.FSDataInputStream”,要求如下:实现按行读取HDFS中指定文件的方法“readLine()”,如果读到文件末尾,则返回空,否则返回文件一行的文本。

(三)查看Java帮助手册或其它资料,用“java.net.URL”和“org.apache.hadoop.fs.FsURLStreamHandlerFactory”编程完成输出HDFS中指定文件的文本到终端中。

4.实验报告

|

题目: |

实验2 熟悉常用的HDFS操作

|

姓名 |

王洪兵 |

日期: 2023.11.14 |

|

实验环境: (1)操作系统:Linux; (2)Hadoop版本:3.1.0。 (3)虚拟机:VMware。 (4)工具:xshell。 (5)JDK版本:1.8; (6)Java IDE:IDEA。

|

||||

|

实验内容与完成情况:

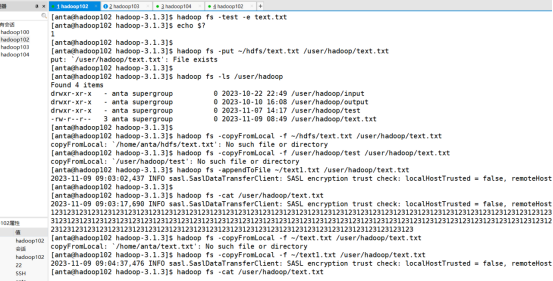

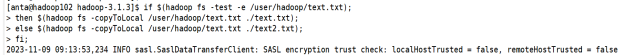

(1) 向HDFS中上传任意文本文件,如果指定的文件在HDFS中已经存在,则由用户来指定是追加到原有文件末尾还是覆盖原有的文件;

(2) 从HDFS中下载指定文件,如果本地文件与要下载的文件名称相同,则自动对下载的文件重命名;

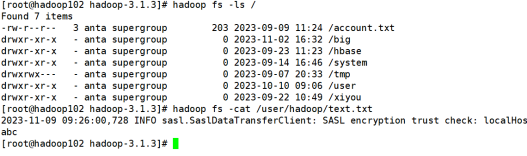

(3) 将HDFS中指定文件的内容输出到终端中;

(4) 显示HDFS中指定的文件的读写权限、大小、创建时间、路径等信息;

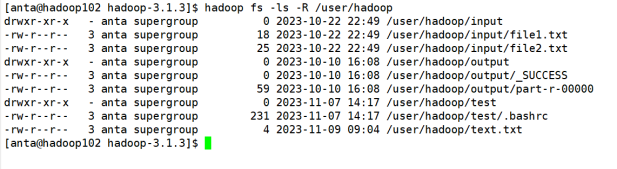

(5) 给定HDFS中某一个目录,输出该目录下的所有文件的读写权限、大小、创建时间、路径等信息,如果该文件是目录,则递归输出该目录下所有文件相关信息;

(6) 提供一个HDFS内的文件的路径,对该文件进行创建和删除操作。如果文件所在目录不存在,则自动创建目录;

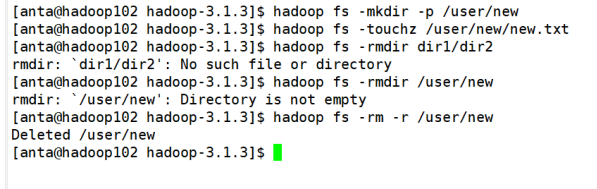

(7) 提供一个HDFS的目录的路径,对该目录进行创建和删除操作。创建目录时,如果目录文件所在目录不存在,则自动创建相应目录;删除目录时,由用户指定当该目录不为空时是否还删除该目录;

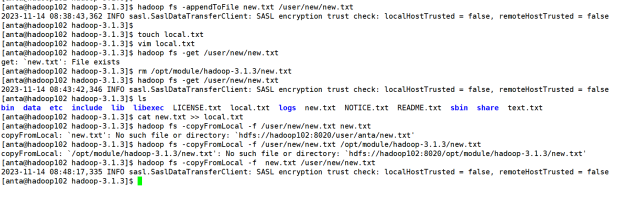

(8) 向HDFS中指定的文件追加内容,由用户指定内容追加到原有文件的开头或结尾;

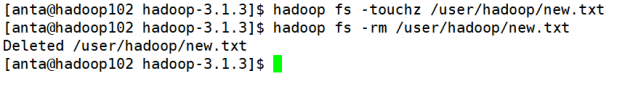

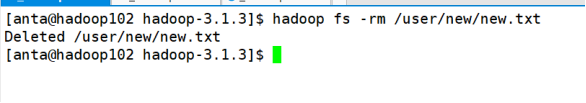

(9) 删除HDFS中指定的文件;

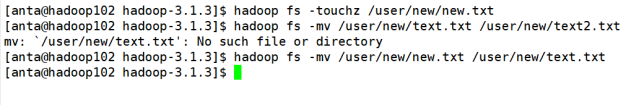

(10) 在HDFS中,将文件从源路径移动到目的路径。

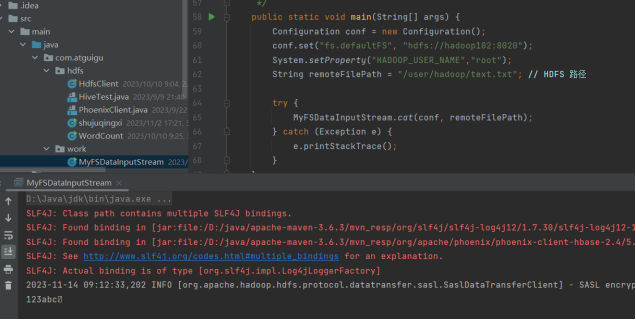

(二)编程实现一个类“MyFSDataInputStream”,该类继承“org.apache.hadoop.fs.FSDataInputStream”,要求如下: 实现按行读取HDFS中指定文件的方法“readLine()”,如果读到文件末尾,则返回空,否则返回文件一行的文本。

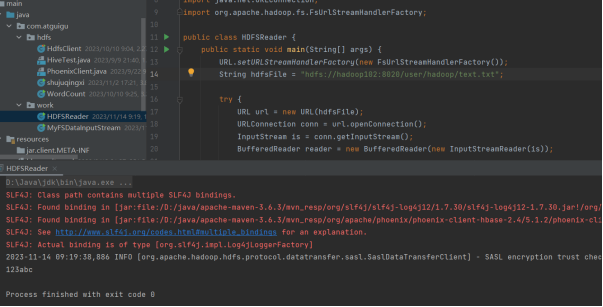

(三)查看Java帮助手册或其它资料,用“java.net.URL”和“org.apache.hadoop.fs.FsURLStreamHandlerFactory”编程完成输出HDFS中指定文件的文本到终端中。

|

||||

|

出现的问题: (1)appendToFile: /opt/module/hadoop-3.1.3/user/new/new.txt (没有那个文件或目录) (2)copyFromLocal: `new.txt': No such file or directory: `hdfs://hadoop102:8020/user/anta/new.txt' (3)readLine()输出的数据后有空格符号 (4)java.io.IOException: Incomplete HDFS URI, no host: hdfs:hdfs://hadoop102:8020/user/hadoop/text.txt |

||||

|

解决方案(列出遇到的问题和解决办法,列出没有解决的问题): (1) 命令文件地址写反hadoop fs -appendToFile 本地文件 hdfs上的文件 (2) 命令文件地址写反hadoop fs -copyFromLocal -f 本地文件 hdfs文件 (3) 因为定义的char[]空间过大,转换为字符串时候没有数据的部分会变为空格符号,未解决 (4) 路径格式不正确应该为: String hdfsFile = "hdfs://hadoop102:8020/user/hadoop/text.txt";

|

||||

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报

· Manus爆火,是硬核还是营销?

· 一文读懂知识蒸馏

· 终于写完轮子一部分:tcp代理 了,记录一下