hadoop学习(2)

(1)本周学习HDFS总结:

本周我花了15小时学习HDFS相关知识。

在学习阶段,我用了8小时来阅读HDFS的文档,了解其基本概念、架构和工作原理。

我还花了4小时编写和测试与HDFS相关的代码,主要是用Java编写一些HDFS操作的示例程序。

在解决问题方面,我花了3小时来处理在学习和编码过程中遇到的一些问题,包括文件权限、数据复制等方面的学习。

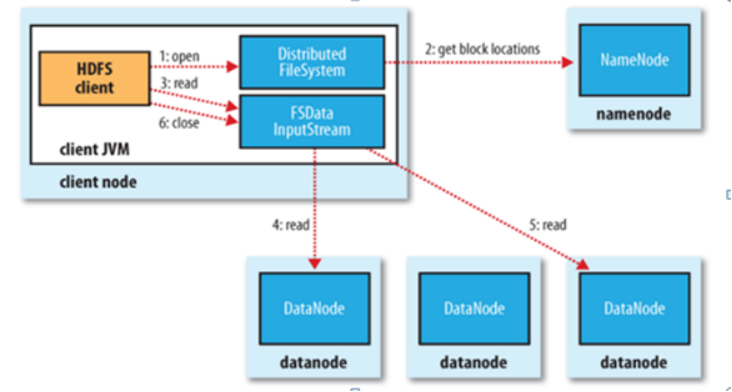

①读操作

客户端要访问一个文件,首先,客户端从NameNode中获得组成该文件数据块位置列表,即知道数据块被存储在哪几个DataNode上;然后,客户端直接从DataNode上读取文件数据。在此过程中,NameNode不参与文件的传输。

②写操作

(2)下周计划:

下周我计划深入学习HDFS的高级主题,如块大小、数据复制、故障恢复等。

我还打算继续学习在HDFS上进行数据的上传、下载和管理,并了解如何监控和维护HDFS集群。

如果可能的话,我也会开始学习Hadoop生态系统中其他组件,如MapReduce、YARN等。

(3)本周遇到的问题:

在学习HDFS时,我遇到了一些有关文件权限和ACL(访问控制列表)的问题,需要更深入地了解如何管理HDFS中的权限。

在编写HDFS相关的代码时,我遇到了一些Java编程方面的问题,需要花时间来查找解决方案并进行调试。

另外,我还遇到了一些关于HDFS配置和集群设置的问题,这些问题需要仔细研究和调整。

浙公网安备 33010602011771号

浙公网安备 33010602011771号