Learning Attention-based Embeddings for Relation Prediction in Knowledge Graphs

Abstract

背景:近年来知识图(KGs)以实体间缺失关系(链接)的形式与不完整或部分信息相结合的扩散,引发了大量关于知识库补全(也称为关系预测)的研究。最近研究表明,基于CNN的模型能够生成更丰富、更有表现力的特征嵌入,在关系预测方面也有很好的表现。

问题:然而,我们观察到这些KG嵌入独立地处理三元组,因此不能覆盖在三元组周围的本地邻居中固有的隐含的复杂和隐藏的信息。

本文:提出了一种新的基于注意的特征嵌入方法,该方法能同时捕获任意给定实体邻域内的实体特征和关系特征。此外,我们还在模型中封装了关系集群和多跳关系。

Introduction

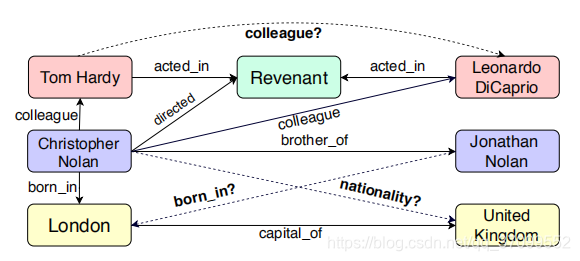

知识图(KGs)将知识库(KBs)表示为一个有向图,其节点和边分别表示实体和实体之间的关系。例如,在图1中,triple (London, capital of, United Kingdom)表示为两个实体:London和United Kingdom,以及连接它们的关系(capital of)。

KGs被广泛应用于语义搜索等领域,对话生成和问题回答等等。

问题:然而,KGs通常会丢失关系。这个问题引发了知识库补全的任务(也称为关系预测),它需要预测给定的三元组是否有效。

目前最先进的关系预测方法主要是基于知识嵌入的模型。它们被广泛地归类为翻译模型和基于CNN的模型。虽然翻译模型使用简单的操作和有限的参数来学习嵌入,但是它们产生的嵌入质量很低。相比之下,基于CNN的模型由于其参数效率和对复杂关系的考虑,学习到更具表达性的嵌入。

问题:然而,翻译和基于CNN的模型都独立地处理每个三元组,因此未能封装给定实体附近固有的和丰富和潜在的语义关系到知识图谱中。

基于上述观察结果,我们提出了一种基于广义注意的关系预测图嵌入方法。对于节点分类,图注意力网络(graph attention networks, GATs) (Velickovi c et al., 2018)被证明关注于图中最相关的部分,即1跳邻域内的节点特征。

在给定一个KG和关系预测任务的情况下,我们的模型通过对给定实体/节点的多跳邻域中的实体(节点)和关系(边缘)特征进行引导,对注意机制进行了概括和扩展。

我们的想法是:

- 捕获围绕给定节点的多跳关系

- 封装实体在各种关系中所扮演角色的多样性

- 巩固现有的知识在语义上相似的关系集群

我们的模型通过给邻居中的节点分配不同的权重质量(注意力),并通过分层迭代的方式传播注意力来实现这些目标。

然而,随着模型深度的增加,远处实体的贡献呈指数递减。为了解决这个问题,我们使用了(Lin et al., 2015)提出的关系组合来引入n-hop邻居之间的辅助边,这样就实现了实体之间的知识流动。

我们的架构是一个编码器-解码器模型,其中我们的广义图注意模型和ConvKB (Nguyen et al., 2018)分别扮演编码器和解码器的角色。

此外,该方法可以扩展为学习文本嵌入图的有效嵌入(KOTLERMAN et al., 2015),其中全局学习在过去已经被(Berant et al., 2015)和(Berant et al., 2010)证明是有效的。

Related Work

近年来,人们提出了几种不同的KG嵌入量来进行关系预测。大致可以分为:(i)基于成分的,(ii)基于翻译的,(iii)基于CNN的,(iv)基于图的模型。

RESCAL 、NTN和全息嵌入模型(HOLE)是基于成分模型的例子。RESCAL和NTN都使用张量积来捕获丰富的相互作用,但是需要大量的参数来建模关系,因此计算起来很麻烦。为了克服这些缺点,HOLE使用实体嵌入的循环关联来创建更高效和可伸缩的组合表示。相比之下,TransE 、DISTMULT和ComplEx等翻译模型提出了可能更简单的模型。TransE将头尾实体之间的转换操作视为关系。DISTMULT使用双线性对角模型学习嵌入,这是NTN和TransE中使用双线性目标的一个特例。DISTMULT使用加权元素点积来建模实体关系。ComplEx通过使用复杂的嵌入和厄米点积来概括DISTMULT。这些翻译模型速度更快,需要的参数更少,而且相对容易训练,但导致表达性较差的KG嵌入。

最近,提出了两种基于CNN的关系预测模型,分别是ConvE和ConvKB。ConvE使用了嵌入上的二维卷积来预测链接。它由卷积层、全连接投影层和内积层组成,用于最终的预测。使用多个filter生成不同的特征图来提取全局关系。这些特征映射的连接表示一个输入三元组。这些模型是参数有效的,但是独立地考虑每个三元组,而不考虑三元组之间的关系。

基于图的神经网络模型R-GCN是将图卷积网络(GCNs)应用于关系数据的扩展。它对每个实体的邻域进行卷积运算,并赋予它们相等的权重。这个基于图的模型并不优于基于CNN的模型。现有的方法要么只关注实体特征来学习KG嵌入,要么不相交地考虑实体特征和关系。相反,我们提出的图注意模型整体地捕获了KG中任意给定实体的n-hop邻居中的多跳和语义上类似的关系。