串讲

COMP9417

1. machine learning分为supervised learning与unsupervised learning

supervised learning基于input以及output做出判断,算法分为classification(得到分类)与regression(数值预测)

unsupervised learning只基于input,算法为clustering

2. regression可以理解为基于所给出的点得到的尽可能多的包含这些点的线(functions),因为有的时候我们得到的是规则而不是特定的某一条直线,这种情况称为hypotheses

对这条直线的查找最常用的model是least squares,也被称作OLS,即所有点距离这条线的距离的平方和最小,用J(θ)表示

如何求解J(θ)可以用gradient descent,即给θ一个初始值,然后按照梯度进行移动;具体做法需要对J(θ)求导,然后定义一个学习率a(可理解为步长,人为决定),根据二者对θ不断更新

3. gradient descent可以分为两种,第一种为batch gradient descent,第二种为stochastic gradient descent,两者区别为第一种是对所有的点累加求和后再进行更新,而在第二种方法中,每做一个点就更新一下,所以第二种方法收敛速度更快,而第一种方法致力于整体的趋势

4. Probability一定准确,from populations to samples; statistics是from samples to populations,不一定准确(sampling的误差)

对于estimate来讲,如果sample的某一特性与整体的该特性相同,则称为statistically unbiased,如sample的平均值与整体的平均值相同,不符合的例子有如最高值或最低值

5. 对covariance而言,从公式中我们可以知道,如果Xi,Yi均大于或小于平均值,即结果大于0,一大一小反之,故而如果cov很大我们可以得到x,y呈正相关,从而判断关联性;correlation基本类似,只是把值压缩在-1到1之间

这里只是表现相关性,其他的如大小比较都不能参考这个

已知当J(θ)的导数为0时,J(θ)最小;我们可以用上述cov, var求θ0(第二种方法)

故而得到结论残差值为0,即比预测高的值之和等于比预测低的值之和;或所求直线到两边点的距离相同

6. 对于curve shapes而言,可以把x2拟合成x1^2,故而依然可以用linear regression

7. regularization解决overfitting的问题,以期用最简单的方式表达线,同样用J(θ)表示,前一部分与cost function类似,后一部分主要为了保证系数足够简单,系数前面的λ是为了权衡系数与cost function的重要性

对于系数部分,如果用平方表示为ridge regression,用绝对值表示为lasso regression

8. 对不同模型进行对比,需要对data set进行划分,train data用来创建model,validation data进行model测试, test data不可见

9. Bias指model与数据点之间的误差,variance是由于sample不同造成的误差

一个模型越简单,bias越高,variance越低

COMP9331

1. DSL数字用户线路,对称的,即上传下载速度相同

ADSL:非对称数字用户电路

COMP9517

1. analog image(模拟影像) --sampling+quantization-->digital image

spatial resolution(高分辨率占空间,低分辨率失真)

对于digital image我们定义了colour space,分为四类(RGB, HSV, YCbCr, L*A*B),用于数字化存储图片

RGB(red, green, blue)

HSV(色相,饱和度,明度)

YCbCr(亮度,蓝色偏移,红色偏移)

2. digitization=sampling+quantization

sampling把图片画成grid形式;因为灰度有可能是连续值,但是我们存储的时候只能存储离散值,通常我们选取一个gray level(256为例,用不同的灰度表示不用的颜色),以此存储不同grid的颜色

3. spatial resolution; 分辨率,越高越清晰

4. image processing即图片的预处理,分为spatial domain与transform domain

spatial domain又分为intensity transformation(只针对一个像素)与spatial filtering

contrast stretching白色的部分全为纯白,黑色的全黑,突出中间部分

image thresholding找到中间的阈值,两边分别为全黑全白, 对于这个阈值的寻找方法有otsu's method, 使方差尽可能小;另一种方法为做出直方图,找出每个gray level对应像素点的数量,找到一个值使两边像素点相同,即阈值

对于multi-band thresholding,可能有多于两个的颜色

5. image negative将黑色变成白色,白色变成黑色,s=L-1-r

6. log transformations,s=c log(1+r),将黑色部分延长放大,忽略白色部分;inverse log则相反

7. power-law与log transformation相似,只是加入了参数更加方便进行对黑/白两部分的压缩

8. piecewise contrast stretching也是对中间部分进行拉伸,突出细节;利用了一个分段函数得以实现

#目前的处理只针对黑白照片

9. gray-level slicing:凸显某一个灰度的信息,不感兴趣的区间设为全黑,感兴趣的区间设为一个较大的数值;若一个转换函数为左下到右上的直线,则表示不做处理保持原样

10. bit-plane slicing,压缩图片且尽可能保持信息,存储时将n位的存储进行逐层存储,去掉冗余信息,只留下有用的,从而进行压缩

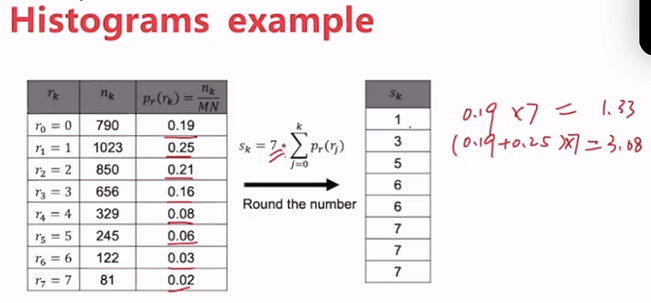

11. 直方图的处理方式分为histogram equalization与Histogram matching

histogram中,digital image灰色等级[0, L-1], 每一个等级对像素点进行统计,我们可以对不同等级的概率进行计算,比较好的图片,每个level的概率比较均衡

Histograms equalization中有一个函数T(r),在 [0, L-1]中单调递增,使得输入输出的灰色区间一致;转换方程见课件

matching根据上面函数的反函数,可理解为先转化成规则的,再转化成想要的

12. ROL reagion of interests, 用mask与原图结合得到感兴趣的区域

13. image averaging人为添加一下噪音,对类似的这些加有噪音的图片进行叠加,一定程度上error会抵消掉,对原始图片进行了优化

14. spatial filtering不单单用一个点,也要看邻居的点,利用卷积的计算方式,即对应位置相乘再相加

第一个转换为neighbourhood average,利用周围的点改善中间的点(求均值,可附加权重,如本身的值最重要)

或通过高斯函数,来确定不同的权重,边界锐化会损失掉,但是减少了噪音

另外,median filter在自己为中间的9个值里找到中间值

15. pooling,多格子变成少格子,取最大值最小值等,根据要求

16. derivation defination,分别进行一阶求导以及二阶求导,发现二阶导数可以更好的反应边界点(转折点),故而将这些边界点叠加到原始图片上,使边界更加突出

浙公网安备 33010602011771号

浙公网安备 33010602011771号