学习地址:https://www.bilibili.com/video/BV1ez4y1X7g2?spm_id_from=333.999.0.0

COCO Evaluation Result

怎样才算检测正确?

常见指标解释:

TP(True Positive): loU>0.5的检测框数量(同一Ground Truth只计算一次)

FP(False Positive): loU<=0.5的检测框(或者是检测到同一个GT的多余检测框的数量)

FN(False Negative): 没有检测到的GT的数量(漏检的)

Precision: TP/(TP + FP)模型预测的所有目标中,预测正确的比例 (查准率)

【假设一张有多个目标的图中只检测出一个目标,此时,TP=1,FP=0,Precision = 1,显然单用Precision是不能够正确评判模型好坏】

Recall: TP/(TP + FN)所有真实目标中,模型预测正确的目标比例 (查全率)

【同样如果TP=1,FP=100,FN=0Precision = 1,显然单用Recall是不能够正确评判模型好坏】

-->因此结合两个指标评判目标检测准确率

AP: P-R曲线下面积

P-R曲线: Precision-Recall曲线

mAP, mean Average Precision,即各类别AP的平均值(每一个类别有一个AP,多个目标取平均值)

存在:pascal voc和coco两个评价指标AP的值差别较大的问题,待解决

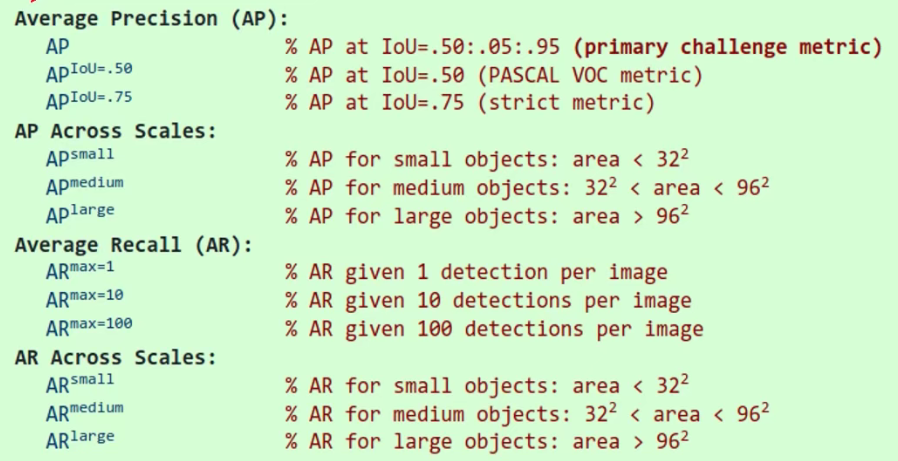

COCO数据集评价指标的含义

1、Average Precision(AP): 这里的AP就是上述的mAP

2、AP Across Scales: small、medium、large小中大目标的AP,能够得到模型对不同尺度物体的检测效果

3、Average Recall(AR): 每张图片最多提供 max = maxDets个目标检测框,此时对应的查全率

4、AR Across Scales: 对应不同目标尺度时,查全率(AR)的值

一般要看Iou metric : bbox中

1、第2行:Pascal Voc数据集的评价指标 AP的值

2、第1行:COCO数据集的评价指标 AP的值

存在问题:pascal voc和coco两个评价指标AP的值差别较大

浙公网安备 33010602011771号

浙公网安备 33010602011771号