模拟大模型返回帮你测试,掌握如何本地测试

fake 大模型本地化测试,条件不允许的情况下,再没有真实大模型做测试用。

from langchain_community.llms.fake import FakeListLLM # FakeListLLM 返回列表

from langchain.prompts import PromptTemplate

responses = [

"你好,",

"武大郎炊饼店欢迎您!!!!",

]

# 导入大模型

model = FakeListLLM(responses=responses) # 编辑好的 list格式 responses参数

# 提示词模板

prompt_template = PromptTemplate.from_template('干撒哈')

#实例化

prompt = prompt_template.format()

# 调用计算

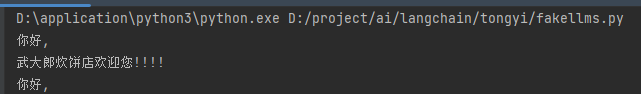

res = model.invoke(prompt) # 返回第一条内容,安照顺序来

res1 = model.invoke(prompt)

res2 = model.invoke(prompt)

print(res)

print(res1)

print(res2) # 循环到又返回第一条内容

本文来自博客园,作者:王竹笙,转载请注明原文链接:https://www.cnblogs.com/edeny/p/18650054

分类:

AI大模型

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 如何调用 DeepSeek 的自然语言处理 API 接口并集成到在线客服系统

· 【译】Visual Studio 中新的强大生产力特性

· 2025年我用 Compose 写了一个 Todo App