书生·浦语大模型趣味Demo课程笔记

第二节 书生·浦语大模型趣味Demo实践

环境准备

浦语大模型的开发机器支持了cuda11.7的基础环境和一些自动迁移conda配置脚本

- 迁移conda环境命令:

studio-conda -o internlm-base -t demo - 如果自己安装软件环境:

conda create -n demo python==3.10 -y

conda activate demo

conda install pytorch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2 pytorch-cuda=11.7 -c pytorch -c nvidia

这一步基本上完成了torch环境的安装。如果后续自己用平台开发的话,感觉这套环境可以做个docker镜像来反复使用。

实践内容

- 实战部署InternLM2-Chat-1.8B

- 进入虚拟环境:

conda activate demo - 安装项目所需软件环境:

pip install huggingface-hub==0.17.3 pip install transformers==4.34 pip install psutil==5.9.8 pip install accelerate==0.24.1 pip install streamlit==1.32.2 pip install matplotlib==3.8.3 pip install modelscope==1.9.5 pip install sentencepiece==0.1.99 - 使用魔塔社区下载模型:

魔塔社区模型下载使用指南:下载模型使用指南

- 使用huggingface下载模型:

使用 Hugging Face 官方提供的 huggingface-cli 命令行工具。安装依赖: pip install -U huggingface_hub resume-download:断点续下 local-dir:本地存储路径。 import os # 下载模型 os.system('huggingface-cli download --resume-download internlm/internlm2-chat-7b --local-dir your_path') - openXLab:

OpenXLab 可以通过指定模型仓库的地址,以及需要下载的文件的名称,文件所需下载的位置等,直接下载模型权重文件,使用 download 函数导入模型中心的模型。import torch import os from transformers import AutoModelForCausalLM, AutoTokenizer, AutoModel base_path = './local_files' os.system('apt install git') os.system('apt install git-lfs') os.system(f'git clone https://code.openxlab.org.cn/Usr_name/repo_name.git {base_path}') os.system(f'cd {base_path} && git lfs pull')

- 实战进阶运行Lagent智能体Demo

- Lagent介绍:

Lagent 是一个轻量级、开源的基于大语言模型的智能体(agent)框架,支持用户快速地将一个大语言模型转变为多种类型的智能体,并提供了一些典型工具为大语言模型赋能。它的整个框架图如下:

- Lagent 的特性总结如下:

- 流式输出:提供 stream_chat 接口作流式输出,本地就能演示酷炫的流式 Demo。

- 接口统一,设计全面升级,提升拓展性,包括:

- Model : 不论是 OpenAI API, Transformers 还是推理加速框架 LMDeploy 一网打尽,模型切换可以游刃有余;

- Action: 简单的继承和装饰,即可打造自己个人的工具集,不论 InternLM 还是 GPT 均可适配;

- Agent:与 Model 的输入接口保持一致,模型到智能体的蜕变只需一步,便捷各种 agent 的探索实现;文档全面升级,API 文档全覆盖。

- 实战进阶灵笔InternLM-XComposer2

- 介绍XComposer2:

浦语·灵笔2 是基于 书生·浦语2 大语言模型研发的突破性的图文多模态大模型,具有非凡的图文写作和图像理解能力,在多种应用场景表现出色,总结起来其具有:

自由指令输入的图文写作能力:

浦语·灵笔2 可以理解自由形式的图文指令输入,包括大纲、文章细节要求、参考图片等,为用户打造图文并貌的专属文章。生成的文章文采斐然,图文相得益彰,提供沉浸式的阅读体验。

准确的图文问题解答能力:

浦语·灵笔2 具有海量图文知识,可以准确的回复各种图文问答难题,在识别、感知、细节描述、视觉推理等能力上表现惊人。

杰出的综合能力:

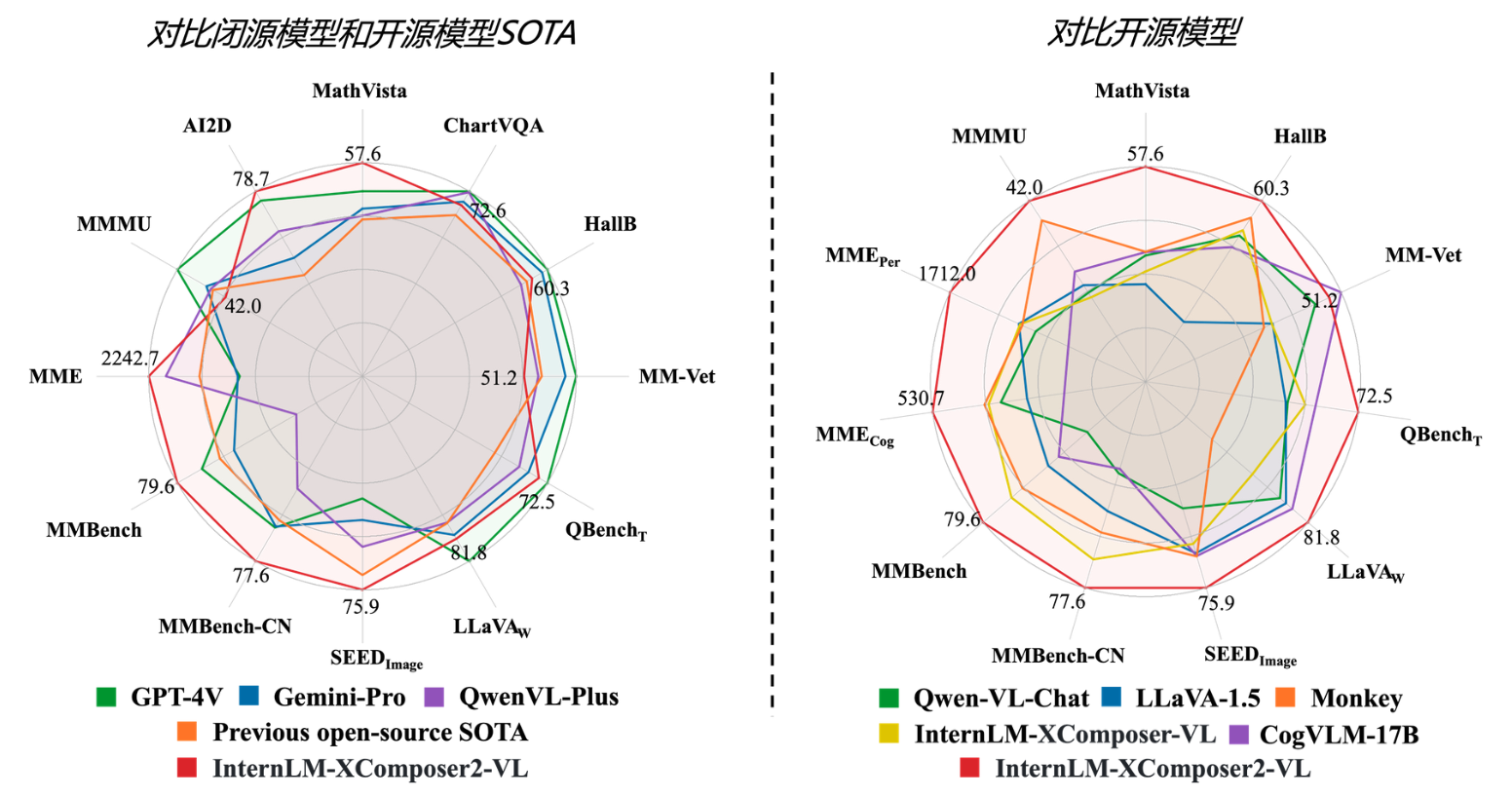

浦语·灵笔2-7B 基于 书生·浦语2-7B 模型,在13项多模态评测中大幅领先同量级多模态模型,在其中6项评测中超过 GPT-4V 和 Gemini Pro。 - 实践体验:

主要有图文生成和图文理解两大亮点,但是根据测试,多轮重复生成图文理解时,会触发一些奇怪的解释,看来还需要进一步的优化和改进,但总体来说,internlm-xcomposer2-7b和internlm-xcomposer2-v1-7b模型的表现力还是相当不错的。