深度学习之路三 将上一篇稍微通用的模型用sklearn代替

from sklearn.neural_network import MLPRegressor import numpy as np # 创建神经网络对象 # 使用adam优化器 adam是一种梯度下降算法 # 使用sgd优化器 adam是一种随机梯度下降算法 model = MLPRegressor(hidden_layer_sizes=(1), activation="tanh", solver='sgd', # admin max_iter=100, learning_rate_init=0.1) inputs = np.array([[1.0, 2.0]]) labels = np.array([[1.0]]) # 拟合模型 model.fit(inputs, labels) # 预测 y_pred = model.predict(inputs) # 评估模型 mse = np.mean((y_pred - labels)**2) print('均方误差:', mse)

通过这个实验我发现adam优化器并没有sgd好, 也就是说优化器对训练结果影响还是很大的

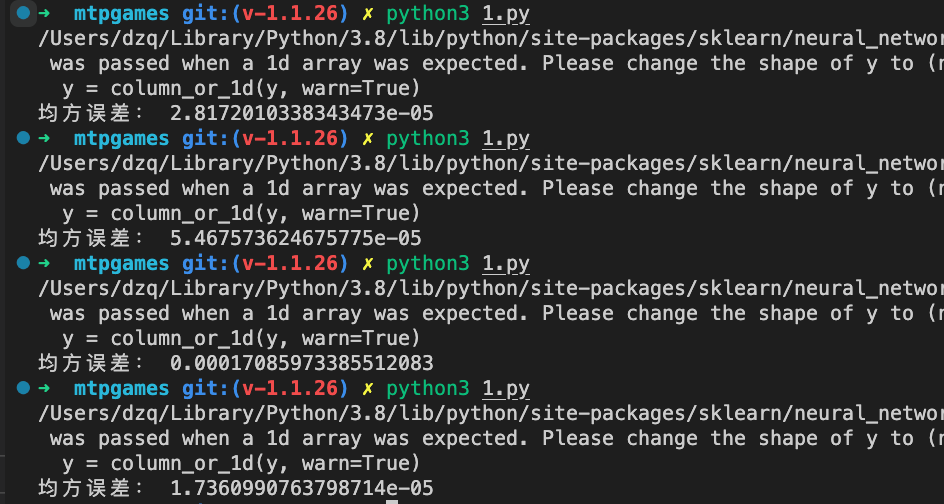

这是sgd优化器结果

已经非常接近0了