hadoop完全分布式集群的搭建

集群配置:

jdk1.8.0_161

hadoop-2.6.1

linux系统环境:Centos6.5

创建普通用户 dummy

准备三台虚拟机master,slave01,slave02

hadoop完全分布式集群的搭建:

设置静态IP地址

为普通用户添加sudo权限

服务器网络设置:NAT模式

域名设置

主机名设置

SSH免登录配置

关闭防火墙

红色步骤主每台主机都要执行,参照上一篇伪分布式集群的搭建

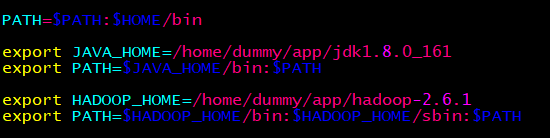

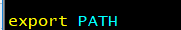

master主机修改环境变量:

vi ~/.bash_profile

最后

保存退出后要 source ~/.bash_profile 让配置文件生效

然后分发到另外两台机 scp -r ~/.bash_profile dummy@slave01:~/ scp -r ~/.bash_profile dummy@slave02:~/

然后另外两台主机也要 source ~/.bash_profile 让配置文件生效

master主机修改配置文件:

1、编辑etc/hadoop/core-site.xml

<property>

<!-- 指定HDFS中NameNode的地址 -->

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

</property>

<!-- 指定hadoop临时目录 -->

<property>

<name>hadoop.tmp.dir </name>

<value>/home/dummy/app/hadoop-2.6.1/hdpdata</value>

</property>

<configuration>

<!-- 指定HDFS副本的数量,默认为3 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

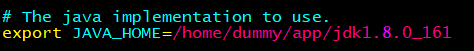

修改JAVA_HOME的路径

4、编辑etc/hadoop/slaves

#指定在哪几台机启动datanode

master

slave01

slave02

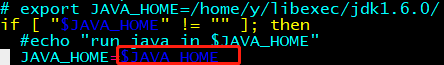

5、编辑etc/hadoop/yarn-env.sh

看红色框是否为 $JAVA_HOME 或 配置文件中$JAVA_HOME 的值

6、编辑etc/hadoop/mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

7、编辑etc/hadoop/yarn-site.xml

<name>yarn.resourcemanager.hostname</name>

<value>master</value>

</property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

hdfs namenode -format

scp -r hadoop-2.6.1/ dummy@slave02:/home/dummy/app/

在/sbin目录下启动集群

start-all.sh

用jps查看进程

master应有:

Namenode

SecondaryNamenod

Datanode

ResourceManager

NodeManager

Jps

slave01和slave02应有:

NodeManager

Datanode

Jps

通过浏览器:

http://master:50070/查看hdfs

http://master:8088/查看yarn

注意:在windows里面配置hosts映射,此域名才会有效(自行百度吧)

浙公网安备 33010602011771号

浙公网安备 33010602011771号