python人脸识别项目之学习笔记(三):矩阵的基本运算 + 张量的定义与分析理解

1. TensorFlow的矩阵操作

接下来你要学到的知识点有

- 如何创建一个矩阵

- 会学到张量的阶和形态是什么?

- 如何创建一个一维到四维的张量

- 如何读懂一个4维张量

- 矩阵的加法,减法

- 矩阵的乘法

- 可逆矩阵

- 转置矩阵

- 对角矩阵

1. 定义一个矩阵

# 这段代码的目的是导入tensorflow包

# 为了以后调用tensorflow包中的对象、成员变量和成员函数时更方便,我们在import tensorflow后面加上了as tf

# 也就是说tensorflow就相当于as

import tensorflow as tf

# 导入os的原因,我已经在上一篇文章中说了,就不做多少阐述了

import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2'

# constant 是一个常量,值是不能够改变的。

# matrix_A 可以把它看成一个节点,这个节点里面存放的是一个数组

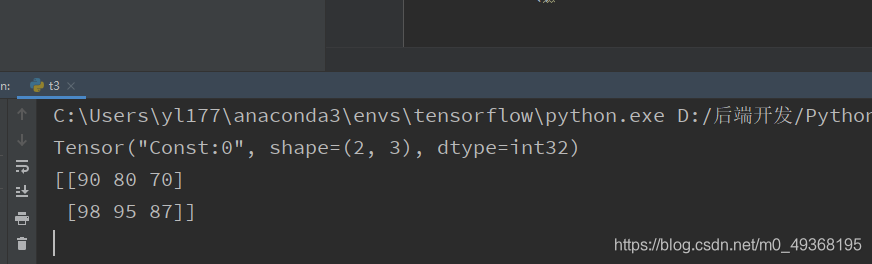

matrix_A = tf.constant([[90, 80, 70], [98, 95, 87]])

# 如果我们在这里打印matrix_A,结果如下

# Tensor("Const:0", shape=(2, 3), dtype=nt32)

# tensor(张量) shape-表示2*3的矩阵

# dtype == data type 数据类型

# 他返回了一个对象

# 这条语句定义了一个sess变量,它包含一个TensorFlow的会话(session)对象,我们现在不必深究会话是什么,可以简单地把会话理解为一个对象,有了这个对象,我们就可以将矩阵打印出来了

sess = tf.Session()

# sess.run 就是将matrix_A的数据运行出来,他返回一个矩阵

run_matrix = sess.run(matrix_A)

print(run_matrix)

sess.close()

执行结果

我们已经知道了如何创建了一个矩阵

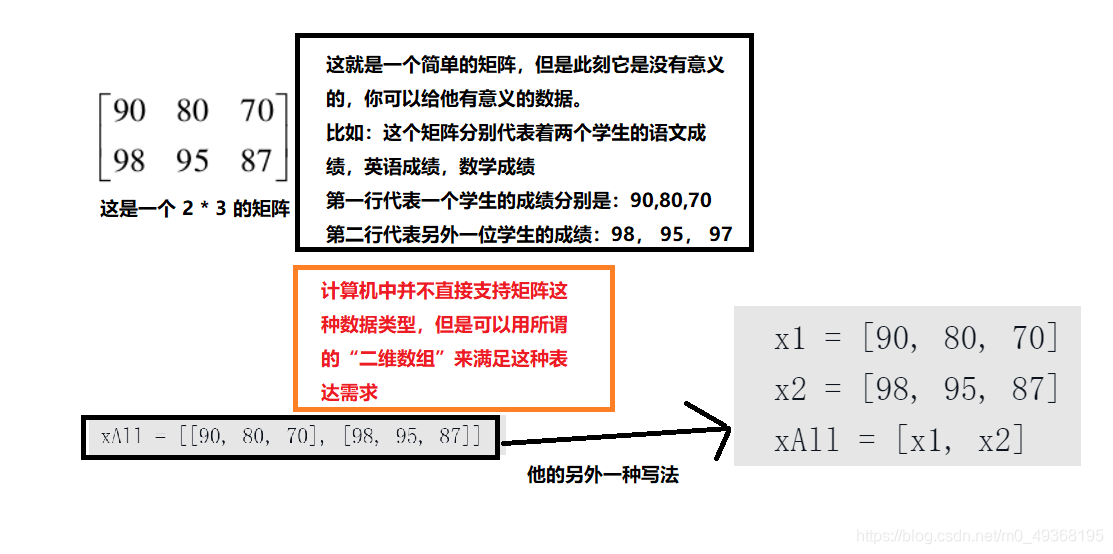

不妨停下来思考一下,我们用数组的方式来表示一个2维矩阵,思考一下,为什么要使用数组?他可以表达怎么的意义,如果二维矩阵不支持表达二维的意义怎么办?3维矩阵我们又应该怎么创建呢?他们表达的意义又会是什么呢?

相信你已经可以创建一个三维矩阵

多维数组可以用来表达数学上很难表达的多维数据。实际上,我们后面是会遇到多维的情况的,例如,一张彩色图片的数据,包含每行每列上的像素,每个像素又包含它的颜色值,颜色值一般用R、G、B(红、黄、蓝)3个“通道”来表达,那么这其中已经至少包含了“行”、“列”、“通道”3个维度。对于这种情况,我们就需要用三维数组来表示图片数据。

需要注意的是,不要把向量的维度和数组的维度这两个概念搞混了。向量中有几个数字,我们就把它叫作几维的向量,其中每一位数字(严格的说应该是数字所处的位置或顺序)叫作其中的一维。而多维数组中,除了最后一维是一个一维数组(也就是只包含数字项)外,其他每一维都是包含数组作为内容项的,并且维度越高,包含的内容项的维度也越高,例如,二维数组的第一维包含的内容项都是一维数组,而三维数组包含的内容项都是一个个二维数组

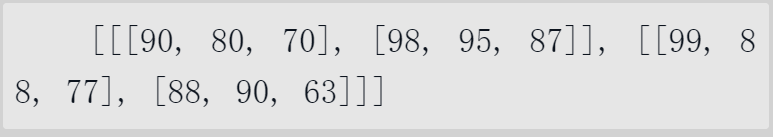

如图所示,这就是一个三维的数组

你可以这样记忆,左边有几个括号就是几维

这个三维数组可以用来表达两个班级的学生的总成绩(虽然学生人数少了一些),也就是说除了“人”、“分数类型”外,又引入了一个“班级”作为第一个维度。第一个维度包含了两个班级,第二个维度是两位学生,第三个维度中包含了3个数字,分别代表语文成绩,英语成绩,数学成绩3个分数;这个三维数组可以称为“2×2×3的三维数组

2. 张量的阶和形态

张量主要是用来存放节点的输出数据的,其中存放的数据可以是一个标量(也就是一个数),也可以是一个向量(一组数),还可以是一个矩阵(二维的数组),甚至可以是用多维数组来表达的数据

TensorFlow中用“形态”(shape)来表达在张量中存储的数据的形式。

在TensorFlow中,张量的形态用一个数组来表示,这个数组中有几个数字,我们就说这个张量是几“阶”(rank)的张量。那么可以很容易地看出,标量是0阶的,向量是1阶的,二维数组是2阶的,三维数组是3阶的,以此可以类推到更多维度的数组

就如同上面的代码

print(tf.constant([[90, 80, 70], [98, 95, 87]]))

他打印了Tensor("Const:0", shape=(2, 3), dtype=int32)

其中tensor–张量, shape–就是形态

张量中存储的是这个二维数组,它的形态是[2, 3],所以他是2阶的,可以看出,形态本身也是一个一维数组,其中的2和3分别代表这个矩阵两个维度(行和列)上的项数

2020年7月27日:更加的理解了张量和形态,如何定义一个1维到4维的张量

# 先定义一个 1 维的张量

x = tf.constant(

[1 , 2]

)

# 当我们通过查看这个张量的形态

# shape [2], 一维数组中的元素有一个, 说明这个张量是一个 1 为的数组,且阶为1

# 定义一个 2 维的张量

x = tf.constant(

[[1, 2], [1, 2]]

)

# 当我们通过查看这个张量的形态

# shape [2 2] 一维数组有2个元素, 说明是一个2维的张量, 且 2 * 2 是一个的矩阵(行*列)

# 定义一个 2 维的张量

x = tf.constant(

[[1, 2], [1, 2], [1, 3]]

)

# shape [3 2] 一维数组的元素有2个,说明这个张量也是一个2维的张量, 且 3 * 2 的矩阵

# 定义一个 3 维的张量

x = tf.constant(

[[[1, 2], [1, 2]], [[1, 2], [1, 2]], [[1, 2], [1, 2]]]

)

# shape [3 2 2] 里面的元素是3个,说明这个张量是一个三维的矩阵

# 我是这样理解的

# [1, 2] 是第一个同学的(数学成绩,语文成绩)

# [1, 2] 是第二个同学的成绩

# [[1, 2], [1, 2]] 这个数组表示一个班的成绩

# [[[1, 2], [1, 2]], [[1, 2], [1, 2]], [[1, 2], [1, 2]]] 这个是1班2班3班里面所有同学的成绩

# 这就是一个三维张量

# 如何定义一个四维张量

# 我在引入一个年级的一个班的一个同学的成绩

x = tf.constant(

[ # 年级

[ # 班级

[ # 同学

[77, 23], # 第二位同学的成绩

]

],

[[[22, 23]]], # 2 年级

[[[22, 23]]] # 3年级

]

)

# shape [3 1 1 2] 这是一个4维向量 3个年级下面有1个班级下面有1个同学下面有2科成绩

# 定义一个4维张量

x = tf.constant(

[

[

[

[100., 100., 100.],

[100., 100., 100.],

[100., 100., 100.]

],

[

[100., 100., 100.],

[100., 100., 100.],

[100., 100., 100.]

],

[

[100., 100., 100.],

[100., 100., 100.],

[100., 100., 100.],

]

]

]

)

# shape [1 3 3 3], shape是一个一维数组,里面有4个元素,说明该张量是一个4维矩阵

# 其中第一个1 代表最外层元素只有1个

# 第一个3 代表把外面2层元素拨开,可以划分为 3 个元素

# 第二个3 代表把外面3层拨开,可以划分为 3 个元素

# 做最后一个3 ,吧外面4层拨开,可以划分为 3 个元素

# 我就明白了如何通过张量得到shape形态了

# 这下我彻底理解了4维张量了

# 比如我输入一张图片x,这个图片是 3 * 3的图片

x = tf.constant(

[ # 一张图片

[ # 图片的宽

[ # 图片的高

[100., 100., 100.], # 里面那一层就是图片的通道

[100., 100., 100.],

[100., 100., 100.]

],

[

[100., 100., 100.], # 里面那一层就是图片的通道

[100., 100., 100.],

[100., 100., 100.]

],

[

[100., 100., 100.], # 里面那一层就是图片的通道

[100., 100., 100.],

[100., 100., 100.]

]

]

]

)

# 第一个扩折号表示图片,他里面有1个元素,说明是1张图片

# 第二个扩折号表示图片的宽,他里面有3个元素, 说明他是 宽为3的图片

# 第三个扩折号表示图片的高,他里面有3个元素,说明他是一个 高为3的图片

# 第四个扩折号表示图片的通道(就是说是彩色图片还是黑白图片),彩色图片为3, 黑白图片为1, 我们可以看出里面有3个元素,说明他的通道数为3, 他是一个彩色图片

# 通过这个张量分析,我们得到他是 一张3*3的彩色图片

# 从这里得到出`他的形态是 [1, 3, 3, 3]

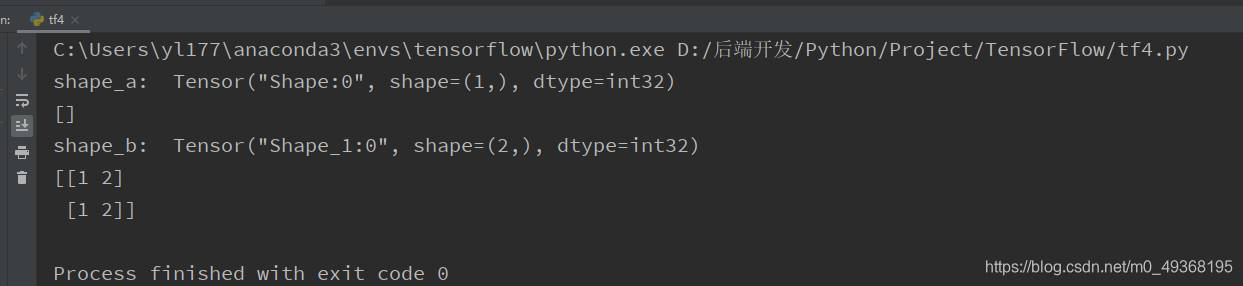

3. 在TensorFlow中查看和设定张量的形态

就如上面的代码,我们在写一遍,分别定义一个 1维,2维的矩阵,用一个张量来存放该节点

import tensorflow as tf

import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2'

# 张量存放这个矩阵节点的

# 输入x的数据是标量,所以得到的形态是“[]”

matrix_a = tf.constant([])

# 输入x的数据是二维数组,得到的形态也是对应的2阶的“[2 3]”

matrix_b = tf.constant([[1, 2], [1, 2]])

sess = tf.Session()

result1 = sess.run(matrix_a)

# shape函数就是用来, 查看某个节点的形态,参数就是节点

shape_a = tf.shape(matrix_a)

print("shape_a: ", shape_a)

print(result1)

result2 = sess.run(matrix_b)

shape_b = tf.shape(matrix_b)

print("shape_b: ", shape_b)

print(result2)

sess.close()

执行结果

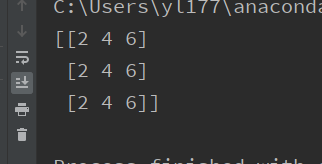

4. 矩阵的基本运算

- 矩阵的加法

import tensorflow as tf

import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2'

a = tf.constant([[1, 2, 3], [1, 2, 3], [1, 2, 3]])

b = tf.constant([[1, 2, 3], [1, 2, 3], [1, 2, 3]])

c = tf.add(a, b)

# 第二种写法

# c = a + b

sess = tf.Session()

res = sess.run(c)

print(res)

sess.close()

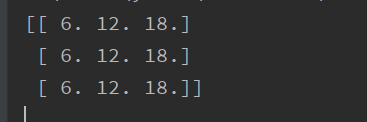

执行结果

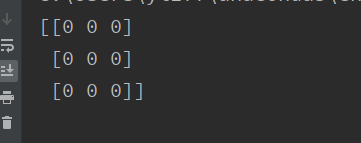

- 矩阵的减法

import tensorflow as tf

import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2'

a = tf.constant([[1, 2, 3], [1, 2, 3], [1, 2, 3]])

b = tf.constant([[1, 2, 3], [1, 2, 3], [1, 2, 3]])

# c = tf.subtract(a, b)

# 第二种写法

c = a - b

sess = tf.Session()

res = sess.run(c)

print(res)

sess.close()

执行结果

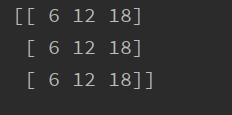

- 矩阵的乘法(用常量写矩阵)

import tensorflow as tf

import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2'

a = tf.constant([[1, 2, 3], [1, 2, 3], [1, 2, 3]])

b = tf.constant([[1, 2, 3], [1, 2, 3], [1, 2, 3]])

c = tf.matmul(a, b)

sess = tf.Session()

res = sess.run(c)

print(res)

sess.close()

执行结果

- 矩阵的乘法(用变量写矩阵)

import tensorflow as tf

import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2'

# Variable第一个参数是初始值,第二个参数是数据类型

a = tf.Variable([[1, 2, 3], [1, 2, 3], [1, 2, 3]], dtype=tf.float32)

b = tf.Variable([[1, 2, 3], [1, 2, 3], [1, 2, 3]], dtype=tf.float32)

c = tf.matmul(a, b)

sess = tf.Session()

# 变量初始化

init = tf.global_variables_initializer()

sess.run(init)

res = sess.run(c)

print(res)

sess.close()

执行结果

- 求逆矩阵

iimport tensorflow as tf

import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2'

a = tf.constant([[1.,2.],[3.,4.]])

inverse = tf.matrix_inverse(a)

sess = tf.Session()

res = sess.run(inverse)

print(res)

sess.close()

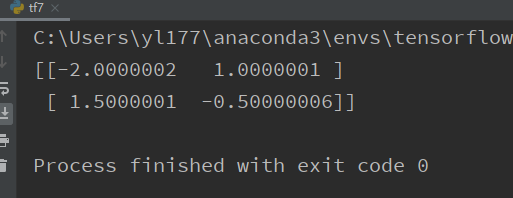

执行结果

- 转置矩阵

import tensorflow as tf

import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2'

a = tf.constant([[1.,2.],[3.,4.]])

transpose = tf.transpose(a)

sess = tf.Session()

res = sess.run(transpose)

print(res)

sess.close()

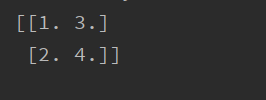

执行结果

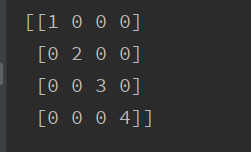

- 对角矩阵

import tensorflow as tf

import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2'

a = tf.constant([1,2,3,4])

diagmatrix= tf.matrix_diag(a)

sess = tf.Session()

res = sess.run(diagmatrix)

print(res)

sess.close()

执行结果