ISLR—第二章 Statistical Learning

Statistical Learning

Y 和X的关系

why estimate f

- 用来预测

预测的时候可以将f^当成一个black box来用,目的主要是预测对应x时候的y而不关系它们之间的关系。 - 用来推断

推断的时候,f^不能是一个black box,因为我们想知道predictor和response之间的关系,用来做特征提取,关系分析等。

根据目的是预测还是推断或者两者结合选择不同的模型,需要做一下trade off。

how estimate f

- 参数方法

它将确定了f的形式,将估计p维的f函数降为了对一些参数的估计

先构建参数表达式,然后用参数表达式去训练数据,例如linear regression。

优点是模型和计算简单,缺点是预先确定了f的形式,可能会和真实的f相差较大。 - 非参数方法

对f的形式并未做假设,它要求得到的结果与训练集越接近越好,但是保证模型不要太过复杂。

优点是适用于更多的f,能够得到更高的正确率,缺点是因为是无参数估计,所以需要的数据量是很大的。

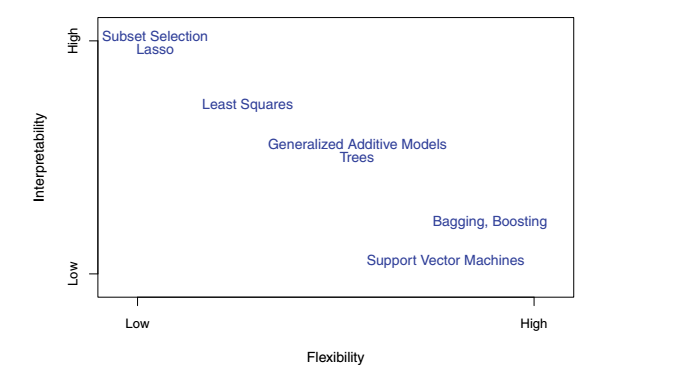

The Trade-Off Between Prediction Accuracy and Model

Interpretability

- Subset Selction Lasso(最难理解)

- Least Squares

- Generallized Additive Models Trees

- Bagging,Boosting

- SVM(最灵活)

模型越复杂,对于模型的可解释度越小。

如果需要对模型进行高精度预测的话,比如股票市场,可以采用更flexible的方法。

然而,在股票市场,高精度的方法有时候效果更差,原因是对训练数据产生了过拟合。

Supervised Versus Unsupervised Learning

Regression Versus Classification Problems

以上两部分的内容在Ng的ML课程中有详细的介绍

二 Assessing model Accuracy

1 Measuring quality of fit

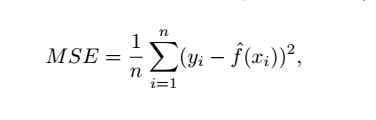

均方误差 MSE

MSE越小越好

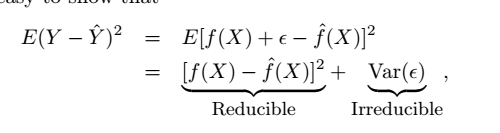

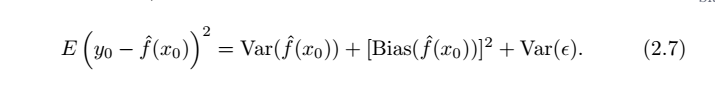

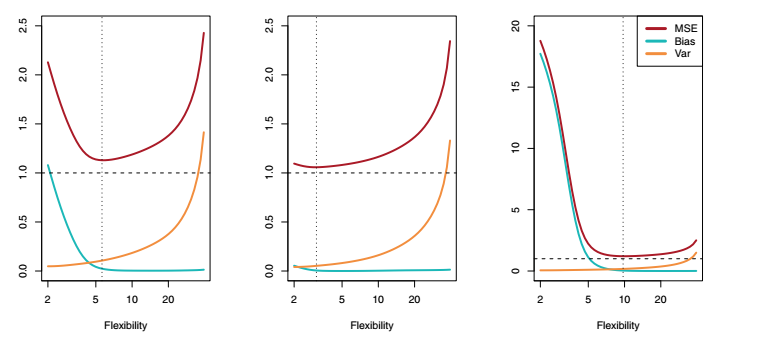

The Bias-Variance Trade-Off

(1) 公式中第一项是预测的方差(variance),表示了如果我们更换一个训练集,预测函数f(x)的变化程度,一般来说,自由度越高的方法具有越大的方差;

(2) 第二项是预测的偏差( bias),某种学习算法的平均估计结果所能逼近学习目标的程度一般来讲,自由度越高的方法具有越小的偏差; 独立于训练样本的误差,刻画了匹配的准确性和质量:一个高的偏差意味着一个坏的匹配

(3) 最后一项是不可消除偏差。

训练充足后,训练数据的轻微扰动都会导致学习器发生显著变化,发生过拟合。

当方差和偏差加起来最优的点,就是我们最佳的模型复杂度。

红色的曲线代表了MSE,橘黄色曲线代表方差,蓝色的曲线代表偏差,水平虚线代表了不可消除偏差,竖直虚线代表了模型实际的自由度。

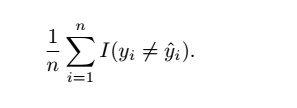

2 classification setting

训练错误率

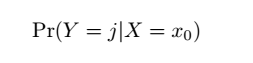

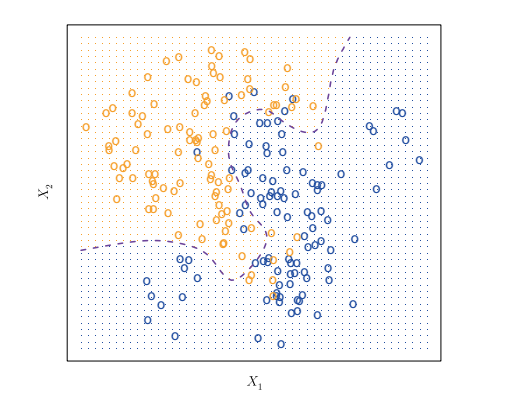

(1)bayes classifier

条件概率

贝叶斯错误率

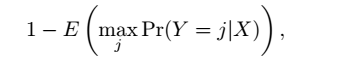

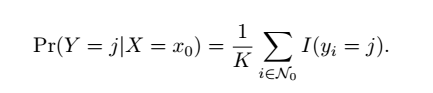

(2)K-Nearest Neighbors(KNN)

理论上,我们偏爱贝叶斯分类器去得到最优的模型。

但是实际上,我们并不知道特定点X对应的Y分布,因此不能够直接使用贝叶斯分类器。

但是,有很多方法,可以人工地构造条件概率分布,然后接着使用贝叶斯分类器。

KNN虽然很简单,但是它的错误率却可以很逼近最低的错误率

R—exercise