Requests库详细的用法

介绍

对了解一些爬虫的基本理念,掌握爬虫爬取的流程有所帮助。入门之后,我们就需要学习一些更加高级的内容和工具来方便我们的爬取。那么简单介绍一下 requests 库的基本用法

安装

利用 pip 安装

pip install requests

基本请求

req = requests.get("http://www.baidu.com")

req = requests.post("http://www.baidu.com")

req = requests.put("http://www.baidu.com")

req = requests.delete("http://www.baidu.com")

req = requests.head("http://www.baidu.com")

req = requests.options("http://www.baidu.com")

get请求

参数是字典,我们也可以传递json类型的参数:

import requests

url = "http://www.baidu.com/s"

params = {'wd': '毛利'}

response = requests.get(url, params=params)

print(response.url) # http://www.baidu.com/s?wd=%E6%AF%9B%E5%88%A9

response.encoding = 'utf-8'

html = response.text

# print(html)

post请求

参数是字典,我们也可以传递json类型的参数:

url = "https://accounts.douban.com/j/mobile/login/basic"

formdata = {

'ck': '',

'name':'13717378202',

'password': '',

'remember': 'false',

'ticket': '',

}

response = requests.post(url, data=formdata)

response.encoding = 'utf-8'

html = response.text

# print(html)

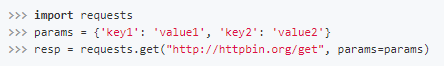

传递URL参数也不用再像urllib中那样需要去拼接URL,而是简单的,构造一个字典,并在请求时将其传递给params参数:

此时,查看请求的URL,则可以看到URL已经构造正确了:

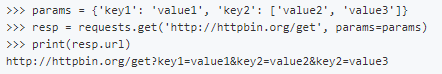

并且,有时候我们会遇到相同的url参数名,但有不同的值,而python的字典又不支持键的重名,那么我们可以把键的值用列表表示:

自定义请求头部

伪装请求头部是采集时经常用的,我们可以用这个方法来隐藏:

headers = {'User-Agent': 'python'}

r = requests.get('http://www.baiducom', headers = headers)

print(r.request.headers['User-Agent'])

设置超时时间

可以通过timeout属性设置超时时间,一旦超过这个时间还没获得响应内容,就会提示错误

requests.get('http://github.com', timeout=0.001)

代理访问

采集时为避免被封IP,经常会使用代理。requests也有相应的proxies属性

import requests

proxies = {

"http": "http://10.10.1.10:3128",

"https": "https://10.10.1.10:1080",

}

requests.get("http://httpbin.org/get", proxies=proxies)

如果代理需要账户和密码,则需这样

proxies = {

"http": "http://user:pass@10.10.1.10:3128/",

}

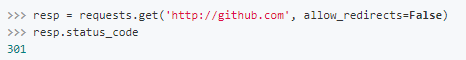

重定向

在网络请求中,我们常常会遇到状态码是3开头的重定向问题,在Requests中是默认开启允许重定向的,即遇到重定向时,会自动继续访问。

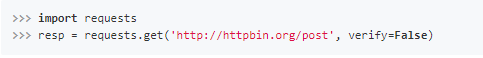

ssl验证

有时候我们使用了抓包工具,这个时候由于抓包工具提供的证书并不是由受信任的数字证书颁发机构颁发的,所以证书的验证会失败,所以我们就需要关闭证书验证。

在请求的时候把verify参数设置为False就可以关闭证书验证了。

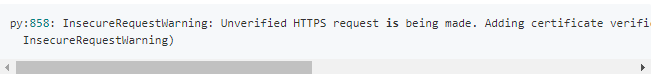

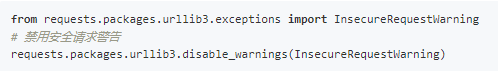

但是关闭验证后,会有一个比较烦人的warning

可以使用以下方法关闭警告

获取响应信息

代码 含义

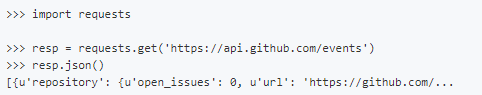

resp.json() 获取响应内容(以json字符串)

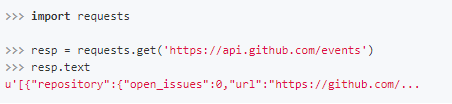

resp.text 获取响应内容 (以字符串)

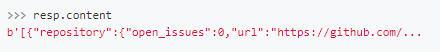

resp.content 获取响应内容(以字节的方式)

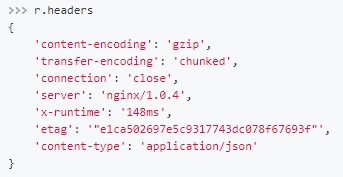

resp.headers 获取响应头内容

resp.url 获取访问地址

resp.encoding 获取网页编码

resp.request.headers 请求头内容

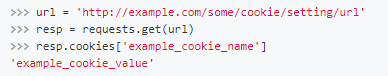

resp.cookie 获取cookie

Requests会自动的根据响应的报头来猜测网页的编码是什么,然后根据猜测的编码来解码网页内容,基本上大部分的网页都能够正确的被解码。而如果发现text解码不正确的时候,就需要我们自己手动的去指定解码的编码格式

而如果你需要获得原始的二进制数据,那么使用content属性即可。

如果我们访问之后获得的数据是JSON格式的,那么我们可以使用json()方法,直接获取转换成字典格式的数据。

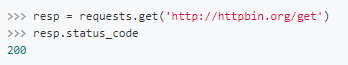

通过status_code属性获取响应的状态码

通过headers属性获取响应的报头

通过cookies属性获取服务器返回的cookies

session自动保存cookies

在Requests中,实现了Session(会话)功能,当我们使用Session时,能够像浏览器一样,在没有关闭关闭浏览器时,能够保持住访问的状态。

这个功能常常被我们用于登陆之后的数据获取,使我们不用再一次又一次的传递cookies。

首先我们需要去生成一个Session对象,然后用这个Session对象来发起访问,发起访问的方法与正常的请求是一摸一样的。

```

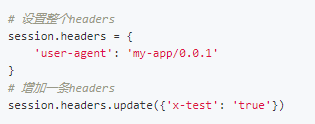

同时,需要注意的是,如果是我们在get()方法中传入headers和cookies等数据,那么这些数据只在当前这一次请求中有效。如果你想要让一个headers在Session的整个生命周期内都有效的话,需要用以下的方式来进行设置:无锡人流多少钱 http://www.bhnfkyy.com/

小试牛刀

登录豆瓣

步骤

找到登录的url,保存cookie

用session保存对话的cookie,再访问网页

# -*- coding:utf-8 -*-

# time :2019/4/3 12:55

# author: 毛利

import requests

class DouBanLogin(object):

def __init__(self,name,password):

self.name = name

self.password = password

def login(self):

sesstion = requests.Session()

sesstion.headers.update({

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.121 Safari/537.36'

})

# 拿到cookie

#sesstion.get('https://www.douban.com/')

#print(sesstion.cookies)

login_url = 'https://accounts.douban.com/j/mobile/login/basic'

form_data = {

'ck':'' ,

'name': self.name,

'password': self.password,

'remember': 'false',

'ticket': ''

}

res = sesstion.post(login_url, data=form_data)

# print(res.text)

if res.json()["status"] == "success":

print('登录成功')

res = sesstion.get('https://www.douban.com/')

print(res.text)

else:

print('登录失败')

if __name__ == '__main__':

name = input('请输入你的账号')

password = input('请输入你的密码')

login = DouBanLogin(name, password)

login.login()