scrapy安装(Linux环境)及爬取百度

scrapy安装(Linux环境)及爬取百度

安装scrapy

1、 在终端中激活虚拟环境;注意:

(1) 虚拟环境之前已建立,可以在pycharm中事先建好

(2) 得与虚拟环境文件夹在同一目录下才能找到并激活虚拟环境

命令:source activate {虚拟环境名称}

激活后路径最前面有(虚拟环境名称)的显示

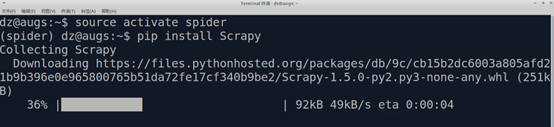

2、 安装scrapy

pip install Scrapy

3、 安装后查看

scrapy version

显示版本号则说明安装成功。

爬取百度

1、 在终端中激活虚拟环境

source activate spider

2、 进入/spider下目录/exec

cd /spider/exec

3、 在exec目录下创建scrapy项目e14

scrapy startproject e14

4、 在自动生成的目录/e14/spider下,新建baiduspider.py,写BaiduSpider类

5、 在终端中先进入e14目录,再爬百度

cd e14

scrapy crawl baidu

此时爬不到内容,但是能看到response_status_count/200,即访问成功。

6、 打开settings.py文件,将ROBOTSTXT_OBEY参数由True改为False,即:

ROBOTSTXT_OBEY = False

7、再次执行scrapy crawl baidu,即可取得内容。