Oozie_03运行官方案例【20161116】

3.1官方的案例

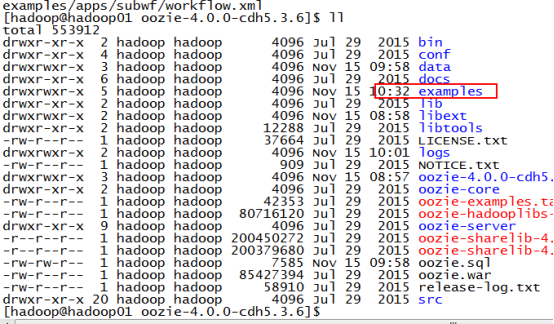

(1)Oozie根目录下找到 oozie-examples.tar.gz

(2)解压tar -zxvf oozie-examples.tar.gz 生成example文件夹

[hadoop@hadoop01 oozie-4.0.0-cdh5.3.6]$ tar -zxvf oozie-examples.tar.gz

(3)拷贝(2)新生成的examples到HDFS的用户家目录下

[hadoop@hadoop01 hadoop-2.5.0-cdh5.3.6]$

bin/hdfs dfs -put /opt/cdh-5.3.6/oozie-4.0.0-cdh5.3.6/examples examples

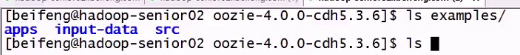

(4)查看examples里面内容

三个目录apps input-data src,三个目录主要功能及截图如下

apps:官方自带的workflow的案例,有hive mapreduce.....

input-data:输入的数据

src:源码包

(5)配置案例自带的mapreduce程序

查看其中一个mao-reduce案例,里面有五个文件:

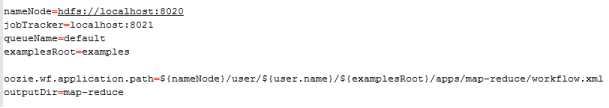

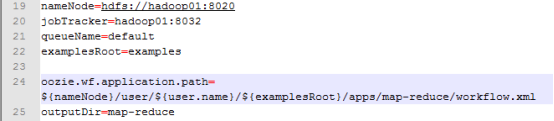

job.properties:两个作用:指定workflow的地址 声明相关变量

nameNode=主机名

jobTracker 端口为8032(就是resourcemanger地址)

queueName队列名称不改

examplesRoot

ooize.wf.application.path=主机名/用户名/.. 指定了workflow的地址

原有内容

修改下面内容 修改了nameNode和jobTracker两处

lib 存放jar包 【不用修改】

workflow.xml :实际运行的workflow【运行该案例这个配置不用修改】

prepare标志作用对提前删除输出目录

.输出目录同输入目录同建立在/user/hadoop/examples下面(如下图)

configuration标志对

job-with-config-class.properties 【不修改】

workflow-with-config-class.xml 【不修改】

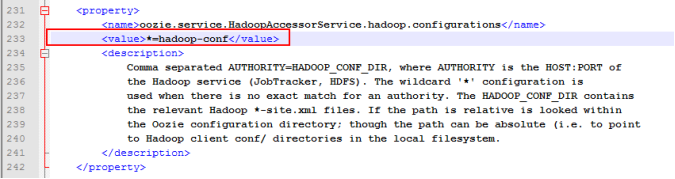

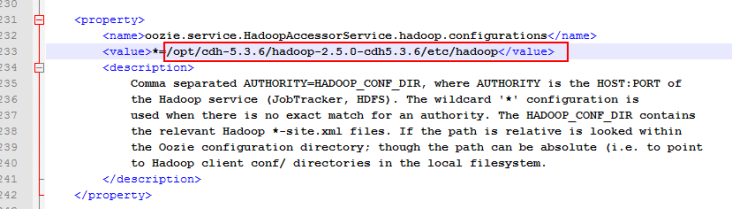

(6)修改oozie-site.xml

修改前内容

该属性修改为hadoop的配置文件

注意: *=不能删除

(7)重启oozie

[hadoop@hadoop01 oozie-4.0.0-cdh5.3.6]$ bin/oozied.sh stop

[hadoop@hadoop01 oozie-4.0.0-cdh5.3.6]$ bin/oozied.sh start

(8)再次提交

[hadoop@hadoop01 oozie-4.0.0-cdh5.3.6]$ bin/oozie job -oozie http://hadoop01:11000/oozie -config examples/apps/map-reduce/job.properties -run

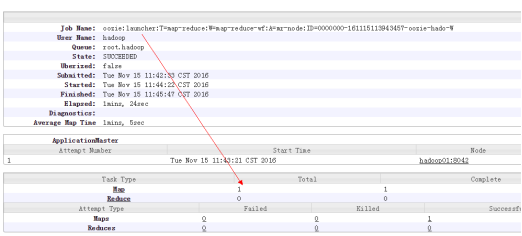

命令行界面

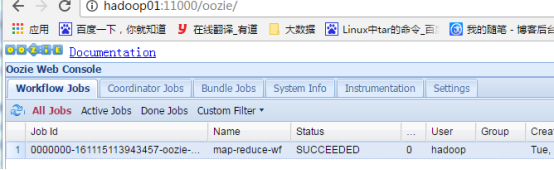

Oozie图形界面

(9)总结

第一点:运行时指定的job.properties文件是本地的,不是hdfs上面的,不过建议修改完该properties文件最好重新上次,把整个包重新上传

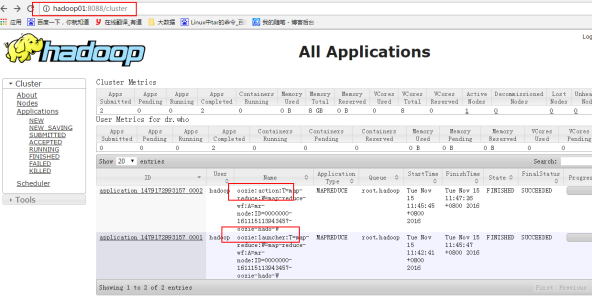

第二点:运行一个workflow 启动了两个mapreduce

一个是oozie:launcher 用于对workflow进行封装(封装程序只有map任务)

一个是oozie:action 执行的mapreduce

利用8088端口查看

action:launcher只有map任务