pbs集群 计算节点采用Infiniband互联

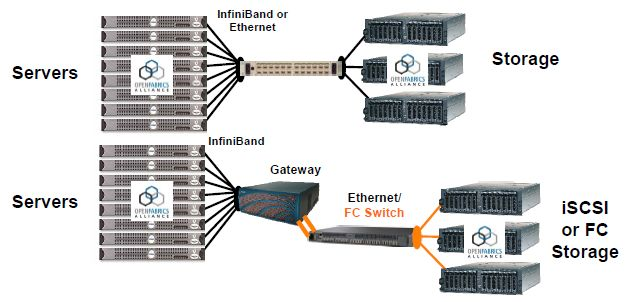

Infiniband Architecture(IBA)是一种网络通信协议,是为硬件实现而设计的,而TCP则是为软件实现而设计的,因此Infiniband是比TCP更轻的传输服务,不需要重新排序数据包,较低的链路层提供有序的数据包交付.

Infiniband通过交换机在节点间直接创建一个私有的,受保护的通道,进行数据的传输,无需cpu参与,远程直接内存访问(RDMA)和发送/接收由Infiniband适配器管理和执行负载.

adapter通过PCIe接口一端连接到cpu,另一端通过Infiniband网络端口连接到Infiniband子网,与其他网络协议相比,具有更高的带宽,更低的延迟,增强的可伸缩性.

RDMA(RemoteDirect Memory Access)技术全称远程直接内存访问,就是为了解决网络传输中客户端与服务器端数据处理的延迟而产生的。它将数据直接从一台计算机的内存传输到另一台计算机,无需双方操作系统的介入。这允许高吞吐、低延迟的网络通信,尤其适合在大规模并行计算机集群中使用。RDMA通过网络把资料直接传入计算机的内存中,将数据从一个系统快速移动到远程系统内存中,而不对操作系统造成任何影响,这样就不需要用到多少计算机的处理能力。它消除了数据包在用户空间和内核空间复制移动和上下文切换的开销,因而能解放内存带宽和CPU周期用于改进应用系统性能。

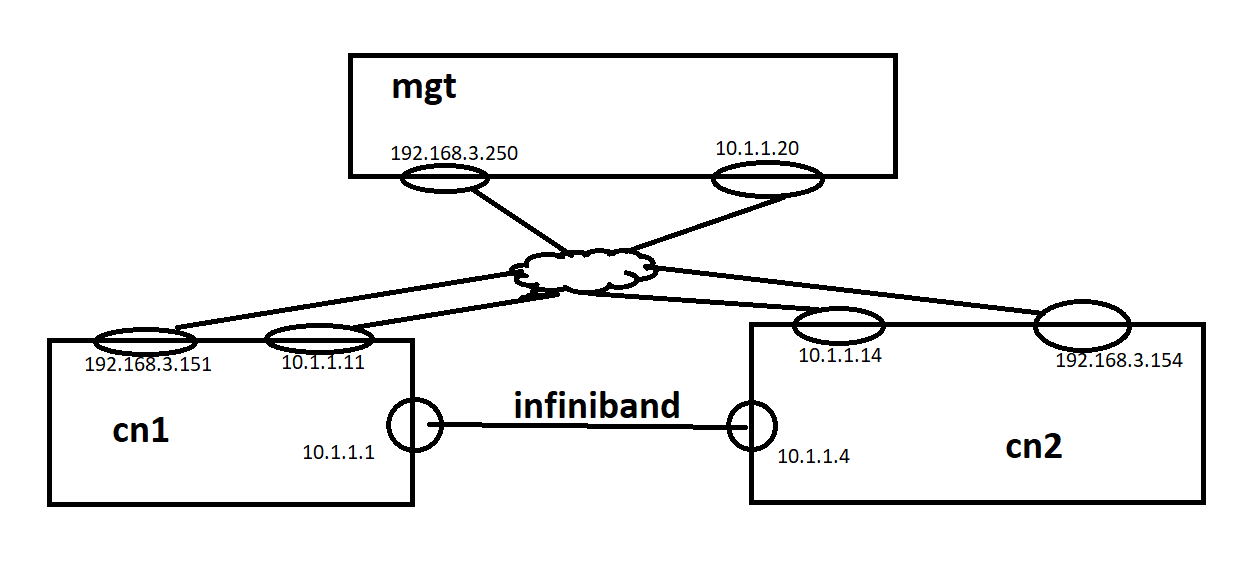

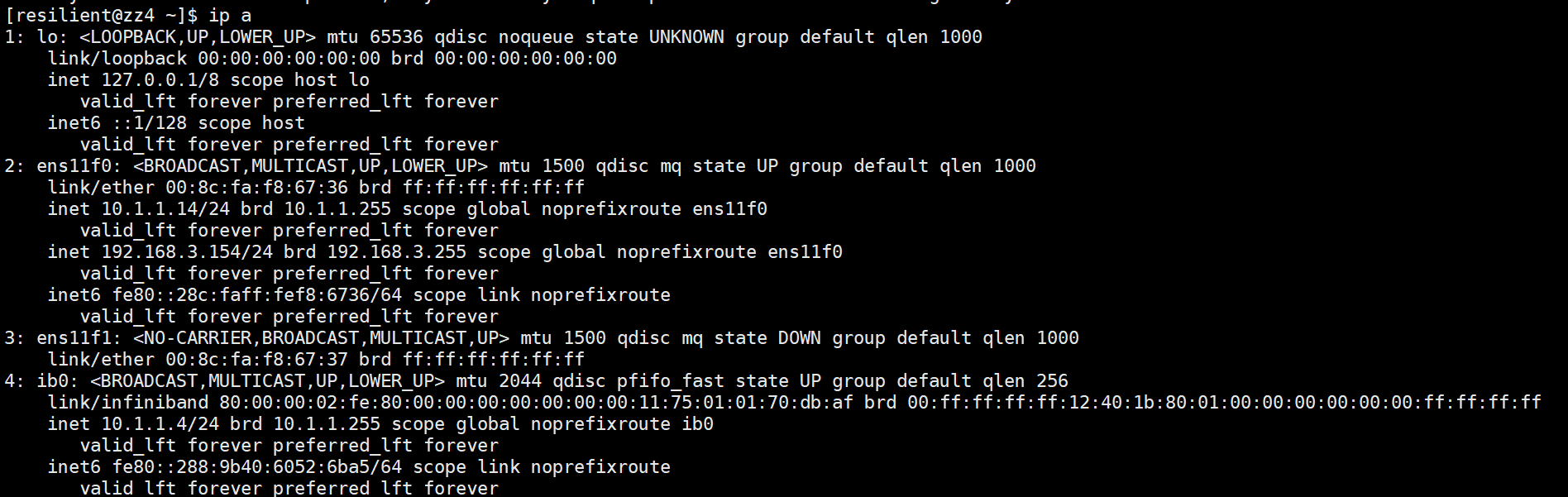

pbs集群节点采用10.1.1.0/24网段,以太网采用192.168.3.0/24网段.mgt节点同时作为nfs和nis服务器

mgt:192.168.3.250 10.1.1.20

cn1:192.168.3.151 10.1.1.11 10.1.1.1(infiniband与cn2:10.1.1.14直连)

cn4:192.168.3.154 10.1.1.14 10.1.1.14(infiniband与cn1:10.1.1.1直接)

这里仅对网络做出说明

各种ethernet工具都无法对infiniband生效,只能通过设置多个ip地址进行联通,mgt与cn1,cn2通信通过10.1.1.0/24Ethernet直接通信,再通过内核转发和infiniband的网卡地址通信,pbs对集群的hosts文件要求严格,通过间接的方式实现互通

上面是大体的网络拓扑

/etc/hosts文件为

10.1.1.20 mgt

10.1.1.11 cn1

10.1.1.14 cn4

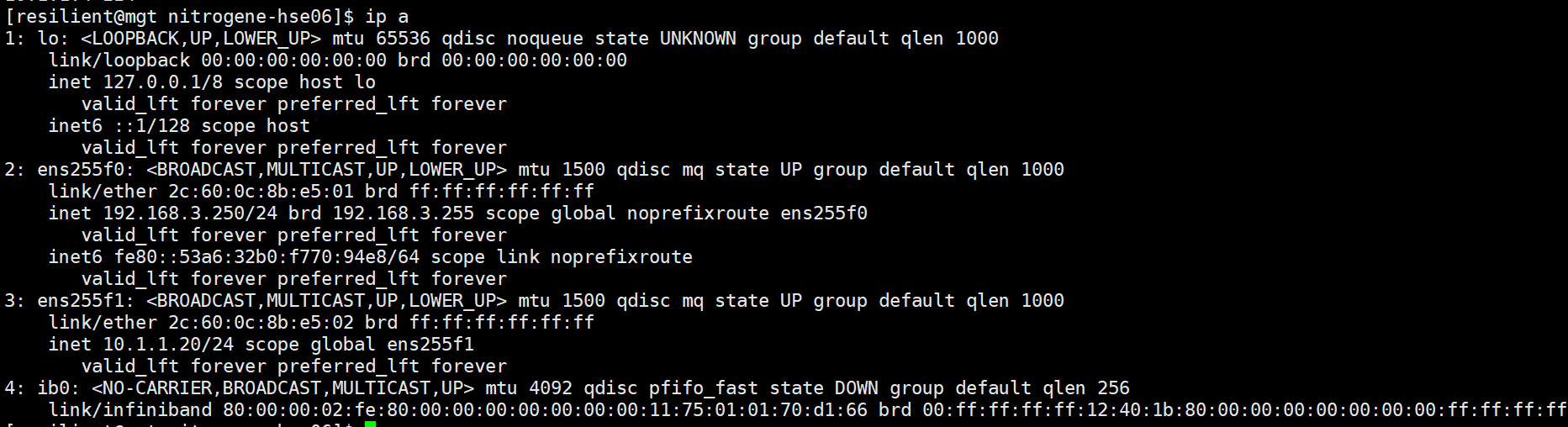

mgt的ip

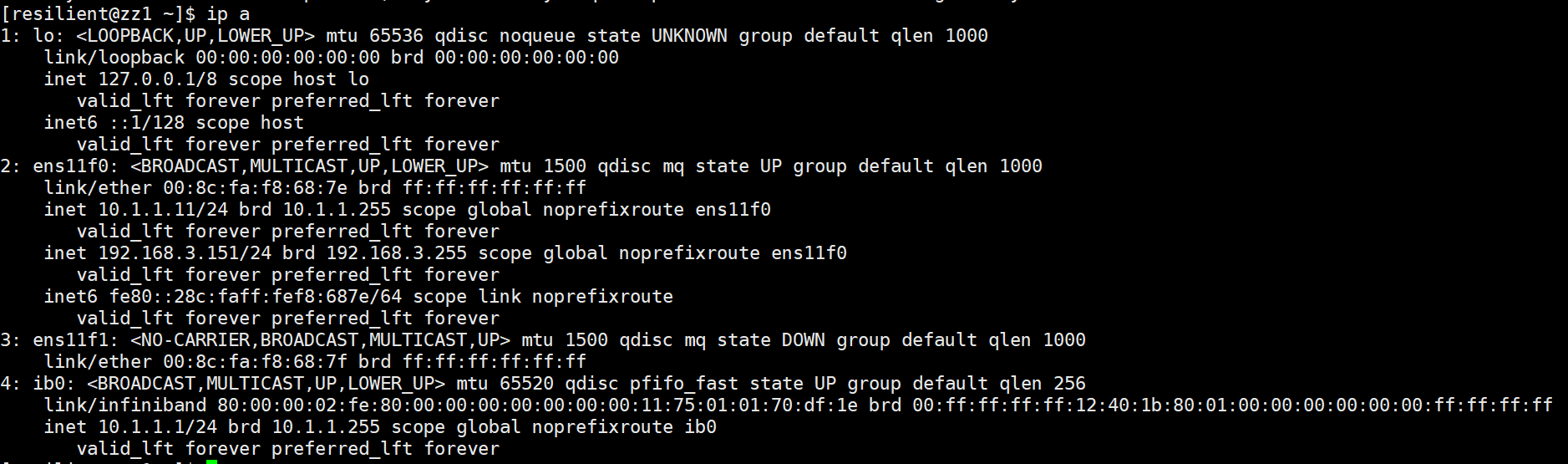

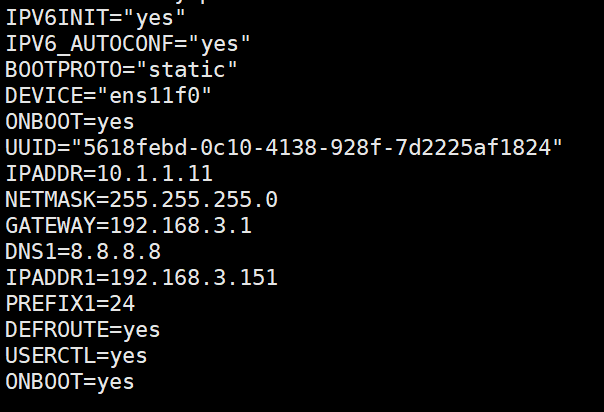

cn1的ip

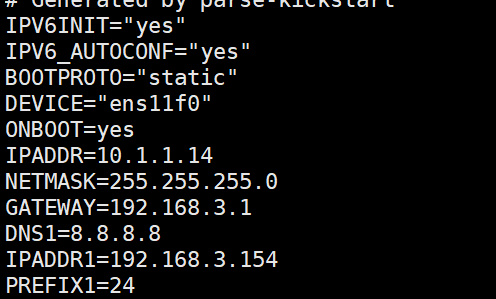

cn4的ip

网络配置文件

cn1

cn4

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 单元测试从入门到精通

· 上周热点回顾(3.3-3.9)

· winform 绘制太阳,地球,月球 运作规律