kettle 批量抽取多个表数据

使用kettle从一个库将数据抽取到另一个库,单个表一个转换就可以简单实现了,那如果是好多表呢,难道要建若干个转换来实现这个功能吗,那就尝试做一个批量抽取的job吧!

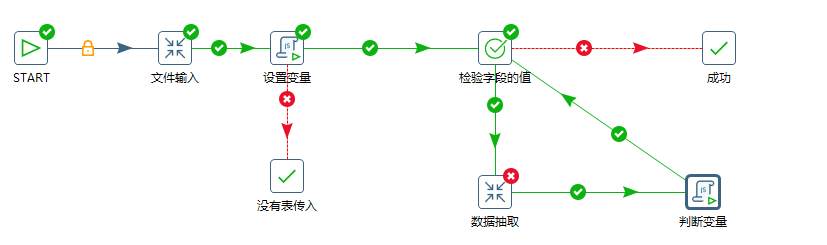

- 整个抽取过程包括一个job和两个trans,先来看看整个job吧:

job的start和success就没什么可说的了,两个脚本是关键,接下来一步一步来。

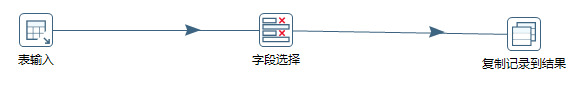

- 首先是文件输入这个trans:

这个trans的作用是提取表名并放入结果集中,表输入是用一段SQL语句将表名输出,字段选择是将SQL输出的那个含有表名的字段提取出来并重新命名,最后含有表名的记录复制到结果集中,方便下一个步骤的使用。

- 接下来设置变量的脚本:

var prevRow=previous_result.getRows();//获取上一个传递的结果集 if (prevRow == null &&(prevRow.size()=0)) { false; }else{ parent_job.setVariable("tables", prevRow);//ArrayList存储表名变量 parent_job.setVariable("size", prevRow.size());//存储执行表的总数量 parent_job.setVariable("i", 0);//循环控制变量 parent_job.setVariable("TABLENAME", prevRow.get(0).getString("tablenames","")); true; }

先获取上一个步骤的结果集,并将表名以ArrayList格式存储在tables这个变量中,将表的数量放入size这个变量中,定义i变量方便稍后控制循环,最后,将这个结果集中的第一个表名取出来并放入到TABLENAME这个变量中。

这个脚本的作用是将你要用的表名放到一个变量中,然后再设置另一个变量遍历取表名,这是很重要的一步。因为在job中有设置变量的这个选项,但是设置变量后,所有的表名都会在这一个变量中,如果你在下一步骤直接取用该变量的值,你得到的不是一个一个的表名,而是闪闪发光的红色报错。

没有表传入是条件判断false后的结果。

接下来就是这个抽取的核心了,

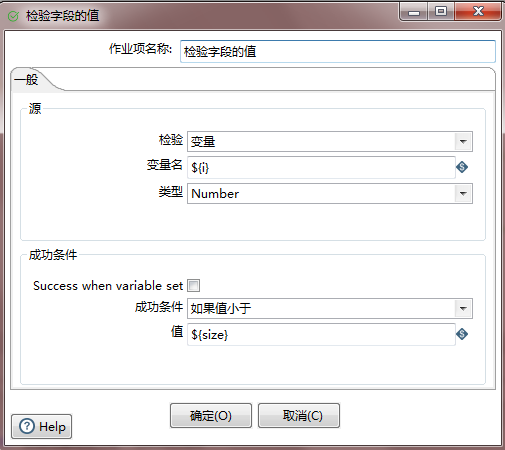

- 首先是条件判断:

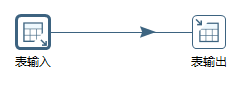

- 接着就是数据抽取:

- 最后就是遍历下一个表名:

var list_Tables =parent_job.getVariable("tables").replace(" ","").replace("[","").replace("]","").split(",");

var size = new Number(parent_job.getVariable("size"));

var i = new Number(parent_job.getVariable("i"))+1;

if(i<size){

parent_job.setVariable("TABLENAME", list_Tables[i]);

}

parent_job.setVariable("i",i);

true;

条件判断简洁后就是if i<size,然后对取出的表名进行抽取工作,很简单,一个表输入,一个表输出,就是一个表的抽取trans,只不过里面用的不是常量表名,而是变量表名select * from ${TABLENAME}(记得勾选替换变量哦)。最后的脚本密密麻麻的一坨,其实就是取出变量TABLENAME中的下一个表名,并且i++,这一步在我看来是最难的,因为不会写啊!

打完收工!

。。。。。还没完呢

总结一下:

-

目的:减少重复造轮子,那就是造一个模具

-

难点:在kettle中没有循环这个组件,想要实现就得自己动手实现循环

-

关键点:利用两个脚本来实现变量的设置和变量的遍历,再用一个检验字段的值实现条件判断,辛辛苦苦只是为了实现一行代码

for(i=0;i<size;i++) -

未解决的困难:在抽取表数据的时候发现,如果表中有clob字段并且存的数据很大的话,会抽取失败,原因是

> Clob 太大, 无法存储在 Java 字符串中

这个问题也再网上找过答案,但是木有找到解决的方法,如果网友有解决方法,敬请留下,感激不尽

-

后续:这个抽取数据的过程有个前提,那就是两个库里都有相同的表和对应的表结构,所以我在上述中也没有写到判断有没有表存在,下一步希望能够实现自动动态创建表,然后加到上述的job中,那就完美了。

打完收工

2016.11.29

总结4已解决:

经排查,上述的clob太大,无法存储的问题是因为有一个clob的字段的字符长度为31800,然后其余的字段都低于1800,将字符长度为31800的字段剔除后,能正常的抽取数据,可见是因为clob的字符长度过长引起的无法存储。

https://blog.csdn.net/qq_35318838/article/details/53322530

浙公网安备 33010602011771号

浙公网安备 33010602011771号