7.5.1 训练深层网络

当网络很深的时候会出现下面的问题

梯度消失是一般情况,所以上面讨论的是梯度消失的情况(每一层的梯度都很小,很多个很小的数相乘就会导致底部的层梯度比上面的层的梯度小);梯度爆炸是另外一回事

之所以会导致上面这种情况是因为不同层之间数据分布是有差别的。所以一个简单的想法就是我给数据的分布固定住

之所以不直接使用均值为

批量归一化的作用范围见下

上面两种方法是二选一;之所以要作用在激活函数之前,可以想一下如果我们作用在激活函数之后,

全连接层和卷积层不同的见下

卷积层那里,通道相当于特征

书上称样本均值和方差是噪音的原因就是我们每次是提取的小批量来进行计算的,小批量与总体分布肯定不同的,所以噪音是比较严重的(这也可能是批量规范化很有用的原因:通过在每个小批量中加入噪音来控制模型复杂度;而不是最初论文作者说的控制内部协变量偏移;所以没必要与丢弃法一起使用

归一化还有如下的知识点,看到时候整合一下

标准化的过程见下

注意,标准化选取的均值

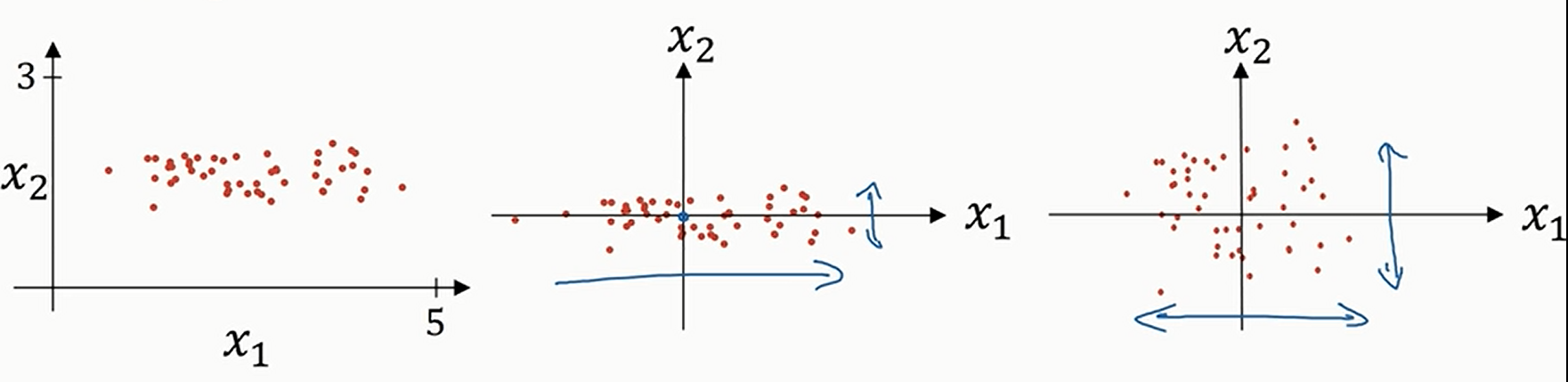

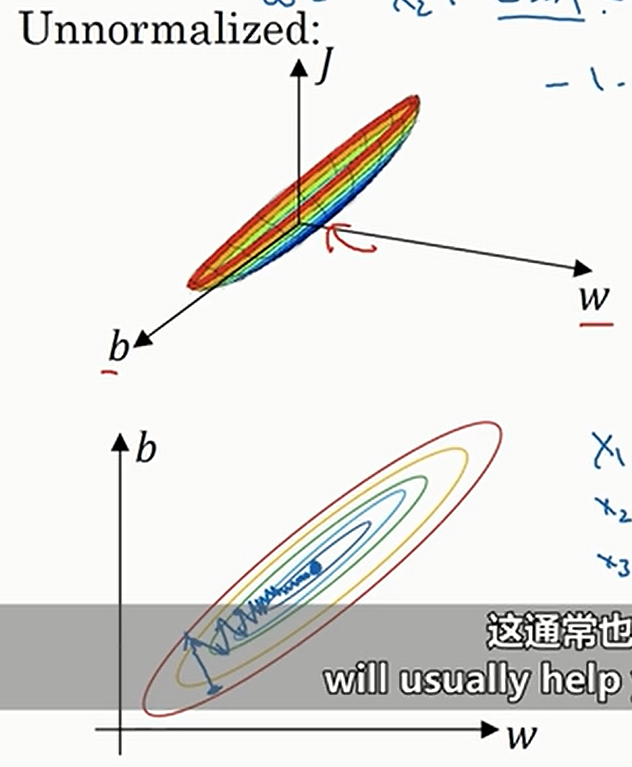

进行标准化的原因:如果特征之间的数据范围相差很大(比如对于

这个时候跑梯度下降的话,就有可能要多很多次才能到最小点,因为初始点的梯度方向不一定指向最小点

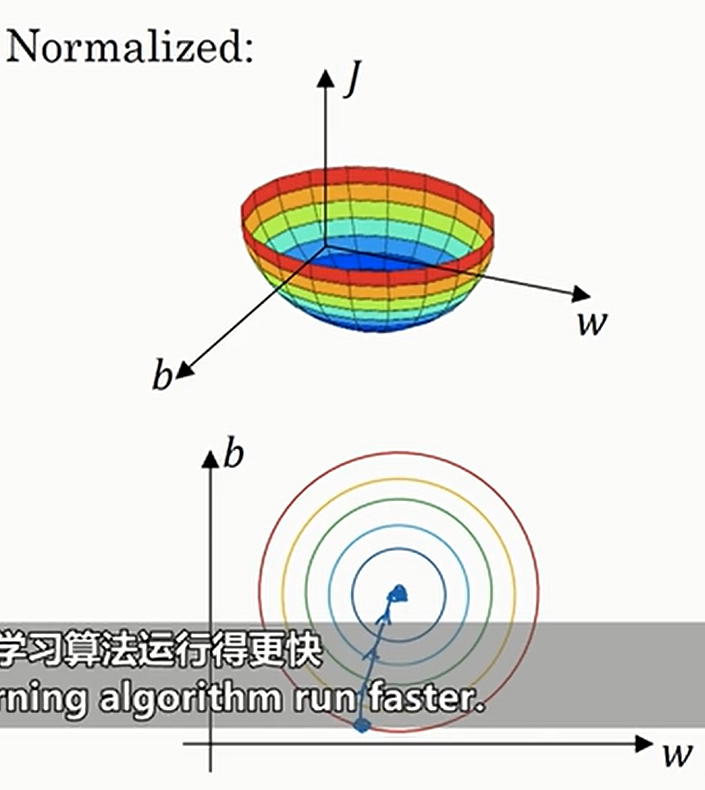

如果标准化了之后,损失函数就是圆的了,此时任何一个点的梯度方向都指向最小点,于是可以直接向最小点进行迭代,如下

也就是说,如果数据之间的范围相差不大,那其实是否标准化不太重要;只不过一律标准化总是没问题的

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构