191 Transform网络

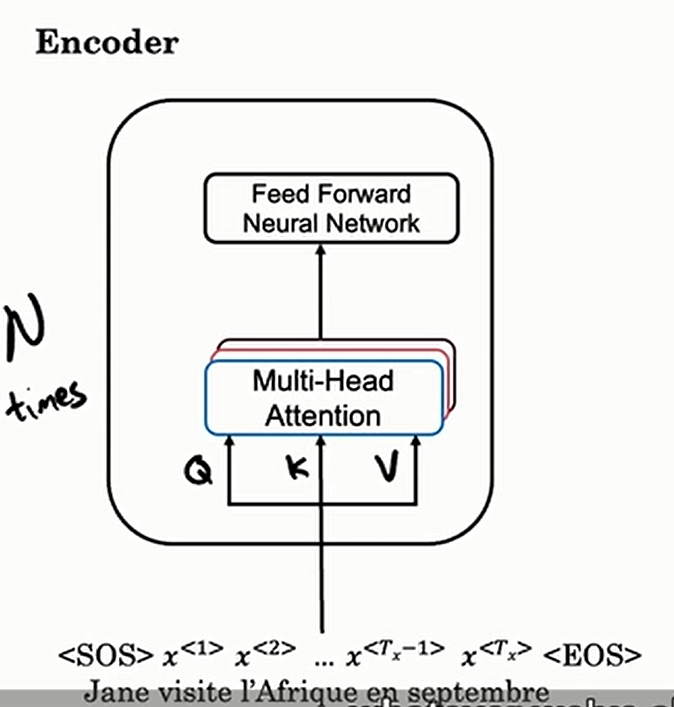

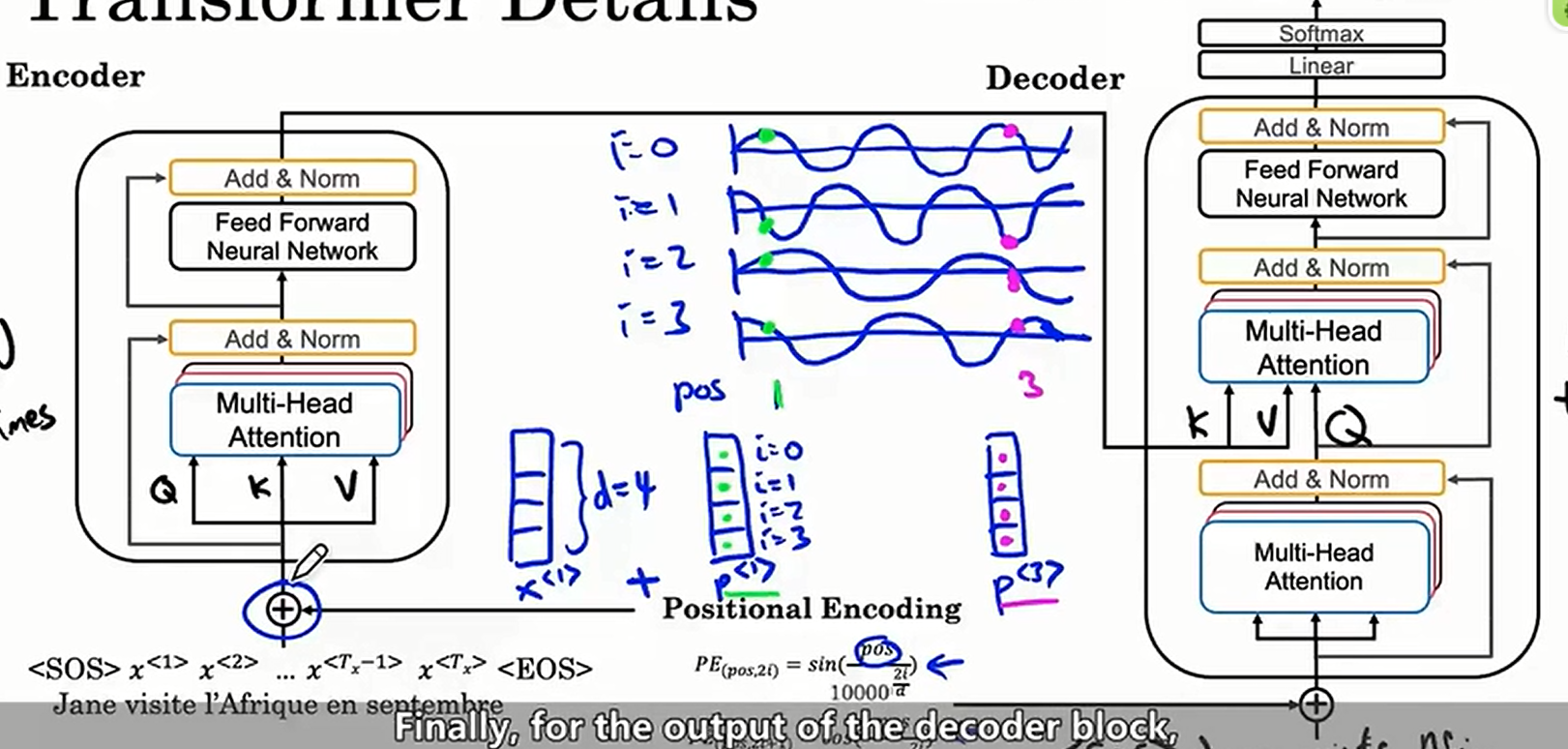

Transform网络首先构建编码器如下

首先将输入进行多头注意力转换,然后放入前向传播网络。这个过程会重复

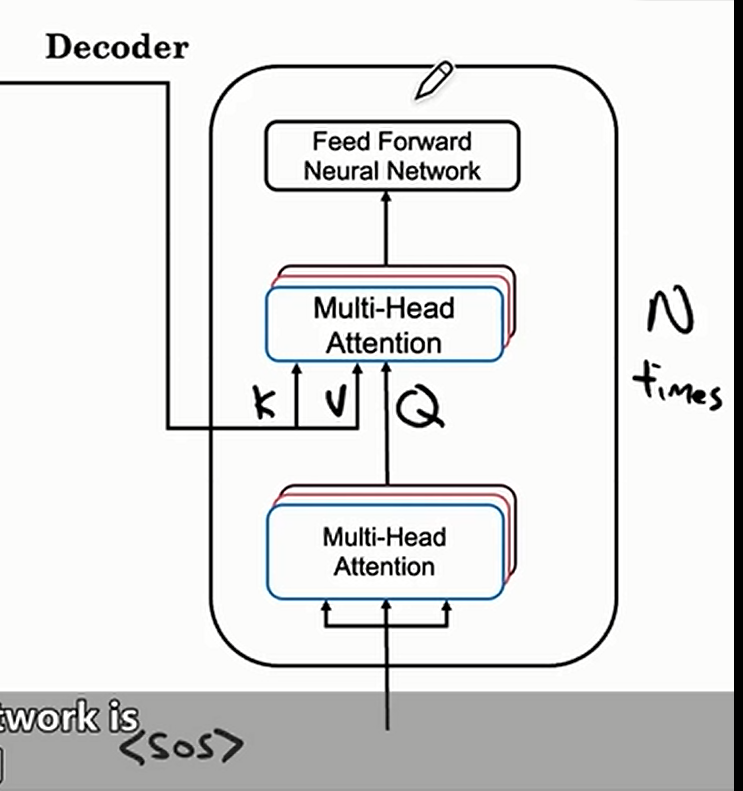

在翻译的时候,我们首先将句子开始标识作为输入,输入进解码器,解码器首先会将输入进行多头注意力转换,然后会将编码器的输出一起,再进行多头注意力的转换,最后再将输出放进前向传播网络。这个过程也会重复多次,如下

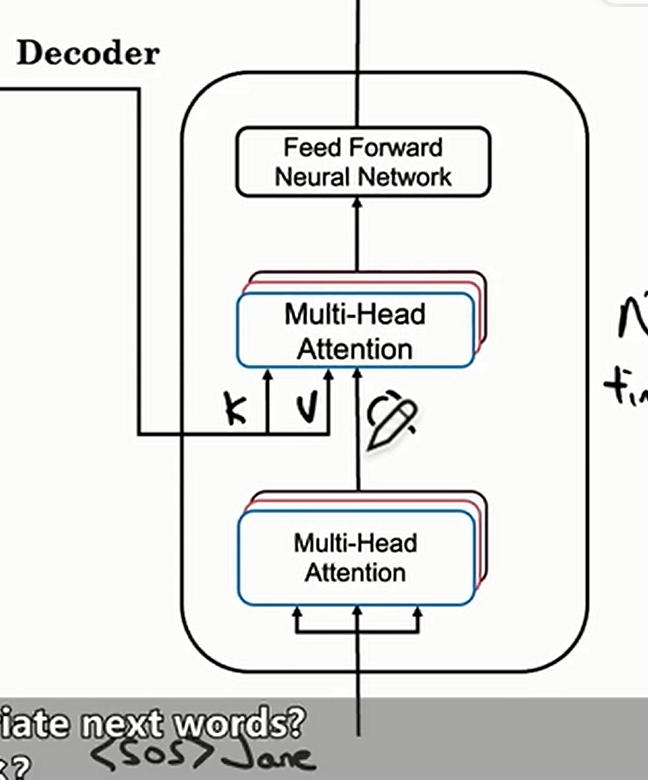

然后生成了预测单词,在预测单词加入输入并重复上述步骤如下

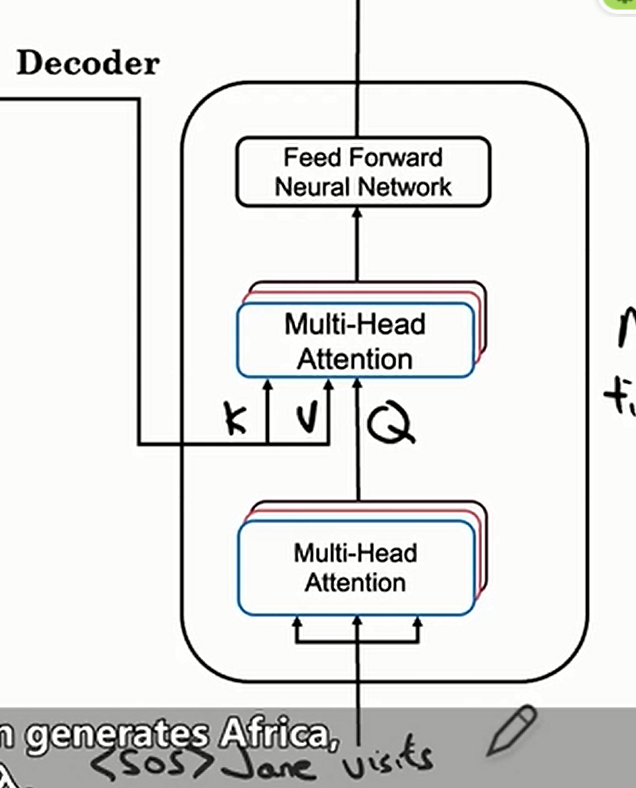

再重复上述过程如下

一直直到完成翻译为止

Transforms需要添加位置编码,因为注意力机制同时处理所有单词,没办法像RNN一样知道各个单词的位置,而单词的位置又很重要,所以需要添加位置编码

位置编码的方式就是使用三角函数,这样子还有一个好处就是不同的单词的位置编码一定不同

我们也会在Transform中使用残差网络;同时会使用BatchNorm;最后还会加上Softmax层和一个线性层,如下

最后视频讲了个掩码Softmax,没太听懂

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构

2024-02-24 Construct Tree

2024-02-24 Construct Matrix

2024-02-24 Yet Another Inversions Problem

2024-02-24 Watering an Array

2024-02-24 Erase First or Second Letter