189 自注意力机制

假设现在有一个句子:Jane visited Afica last September.

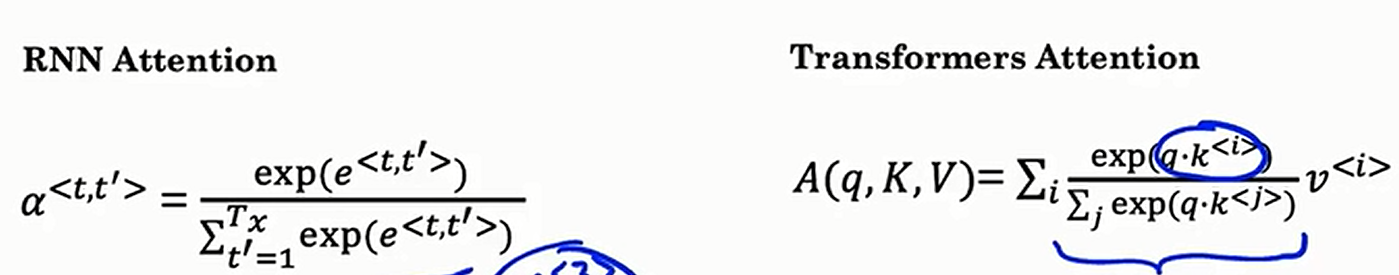

那么到底是将Afica当做一个大洲处理还是当做一个度假胜地处理呢?这个是要就要去考察上下文了。普通的RNN是没办法考虑下文的,双向RNN又只能一个词一个词的计算,而自注意力机制就可以并行计算,如下

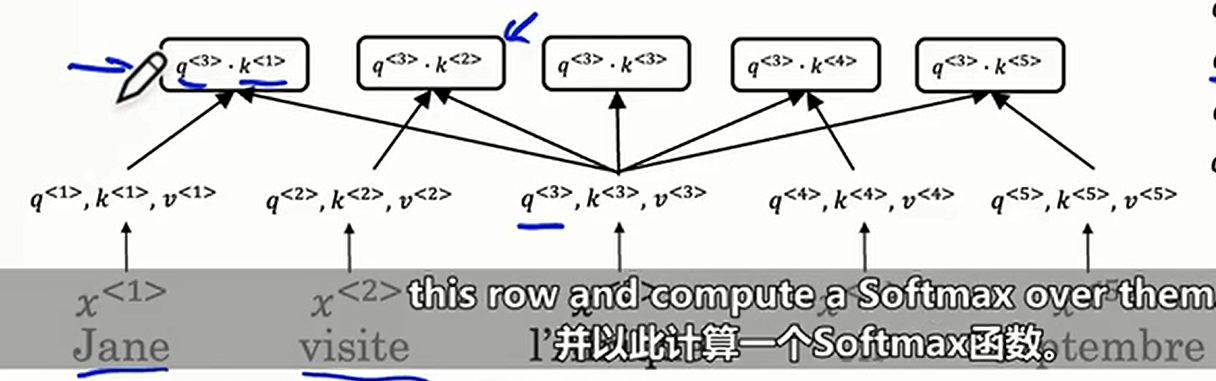

自注意力要计算每一个词元的注意力值,我们记第

查询和键的作用就是用来计算各个权重的,如下

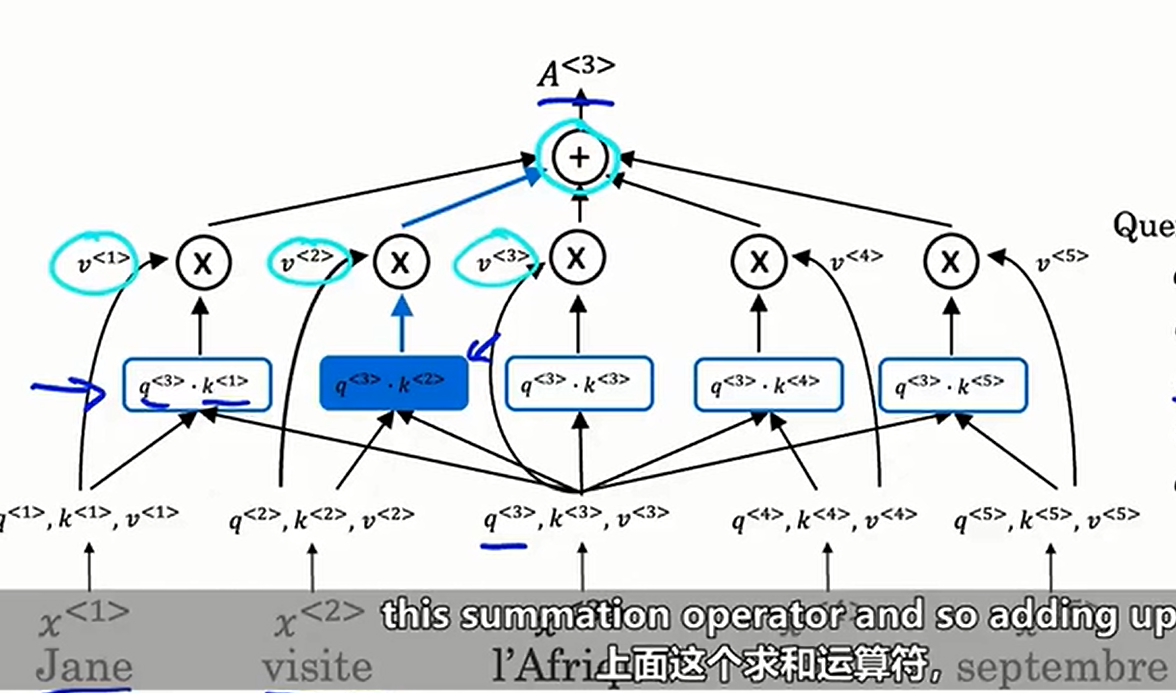

假设我们现在要推测Afica到底是什么,那么无疑visited这个词的作用非常大,所以我们就可以发现第二个权重的值比其他值大得多(这样就方便在后续让visit这个词的值占很大比例)

然后再

最后相加就可以得出注意力值

自注意力机制就让Afica不再是固定的词嵌入表示,而有了更灵活的操作方法

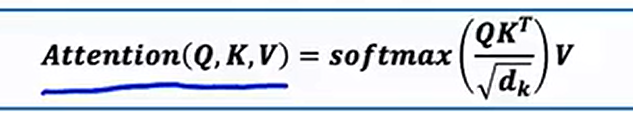

将所有词元的计算过程合并在一起,写成矩阵如下

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构

2024-02-24 Construct Tree

2024-02-24 Construct Matrix

2024-02-24 Yet Another Inversions Problem

2024-02-24 Watering an Array

2024-02-24 Erase First or Second Letter